پژوهشگران Anthropic در مقالهای که مارس 2025 منتشر شد،متوجه موضوعی شدند: مدلهای زبانی بزرگ مثل Claude، فقط کلمه بعدی را پیشبینی نمیکنند، بلکه مثل مغز انسان، استراتژیهای پیچیده و الگوهای فکری عمیقی میسازند. اما چون حتی سازندگان این مدلها از نحوه عملکرد این "جعبه سیاه" بیخبرند، با الهام از علوم اعصاب، ابزاری شبیه "میکروسکوپ هوش مصنوعی" طراحی کردهاند تا جریان فکر و اطلاعات را در این مدلها رصد کنند. این کشف برای اطمینان از عملکرد درست و ایمن این فناوری حیاتی است و شگفتانگیزتر اینکه Claude گاهی در یک "فضای ذهنی مشترک" فکر میکند—جهانی که در آن مفاهیم، فارغ از زبانهایی مثل فارسی، انگلیسی یا چینی، آزادانه شکل میگیرند.

مدلهای هوش مصنوعی مثل کلود، توسط انسانها خط به خط کدنویسی نمیشوند. بلکه بر روی مقادیر زیادی داده آموزش داده میشوند. در طول فرآیند آموزش، آنها استراتژیهای خود را برای حل مسائل یاد میگیرند. این استراتژیها در میلیاردها محاسباتی که یک مدل برای هر کلمهای که مینویسد انجام میدهد، رمزگذاری شدهاند. آنها برای ما، توسعهدهندگان مدل، غیرقابل درک هستند. این به این معنی است که ما نمیفهمیم مدلها چگونه بیشتر کارهایی که انجام میدهند را انجام میدهند.

وقتی کلود به زبانهای مختلف صحبت میکند، آیا در درونش هم به آن زبانها فکر میکند؟ یا وقتی چیزی مینویسد، آیا فقط کلمه بعدی را حدس میزند یا از قبل برای جملات و پاراگرافها برنامهریزی میکند؟ یا وقتی دلیل یک پاسخ را توضیح میدهد، آیا واقعاً همانطور فکر کرده یا فقط یک دلیل ساختگی میآورد که قانعکننده به نظر برسد؟

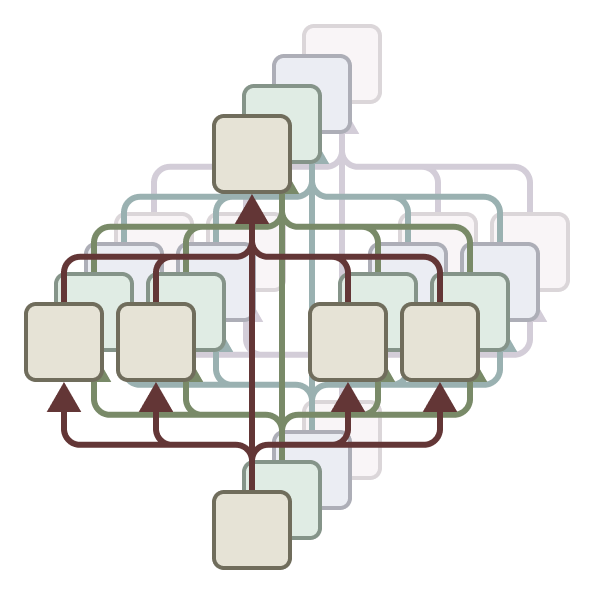

پژوهشگران هوش مصنوعی مثل دانشمندان حوزه علوم اعصاب که به داخل مغز نگاه میکنند، ابزاری شبیه "میکروسکوپ" برای دیدن داخل مدلهای هوش مصنوعی میسازند. آنها نمیتوانند فقط با صحبت کردن با مدل همه چیز را بفهمند، همانطور که ما نمیتوانیم با مغزمان صحبت کنیم و بفهمیم چطور کار میکند. در این مقاله، دو کار جدید توضیح داده شده است:

یکی اینکه چطور بخشهای مختلف مدل که مفاهیم را پردازش میکنند ویژگیها (features) را به هم وصل کرده و نشان میدهند که اطلاعات چطور جریان پیدا میکند (مانند "مدار").

دوم، مدل کلود 3.5 هایکو را برای کارهای ساده بررسی کردهاند تا ببینند چطور رفتار اصلی آن کار میکند. این روش به آنها کمک کرده تا بخشی از نحوه کار کلود را بفهمند و شواهدی قوی پیدا کنند که:

۱. کلود میتواند درباره ایدهها و مفاهیم به روشی فکر کند که به زبان خاصی وابسته نیست، انگار یک زبان فکری کلی دارد که برای همه زبانها مشترک است. این را با دیدن اینکه چطور جملات مشابه در زبانهای مختلف در داخل کلود پردازش میشوند، فهمیدهاند.

۲. کلود وقتی متنی مینویسد، از قبل برای کلمات جلوتر برنامهریزی میکند، نه فقط کلمه بعدی را حدس بزند. مثلاً در شعر، از قبل کلمات قافیهدار را در نظر میگیرد و بعد جمله را طوری مینویسد که به آن کلمه برسد. این یعنی مدلها حتی وقتی کلمه به کلمه مینویسند، برای آینده دورتر فکر میکنند.

۳. کلود گاهی وقتها استدلالی میآورد که منطقی به نظر میرسند اما واقعی نیستند و فقط برای این هستند که با کاربر موافقت کند. مثلاً اگر در یک مسئله ریاضی سخت به آن یک راهنمایی اشتباه بدهید، کلود ممکن است دلایلی ساختگی بسازد تا به آن جواب اشتباه برسد. ابزار این محققان میتواند این لحظات را شناسایی کند و بفهمد مدل دارد دلیل الکی میآورد.

محققان میگویند از نتایج کارشان تعجب کردهاند. مثلاً در مورد شعر فکر میکردند کلود برنامهریزی نمیکند اما دیدند که برنامهریزی میکند. در مورد اینکه چرا مدلها گاهی اطلاعات غلط میدهند (توهم hallucinations)، فهمیدند که در واقع کلود معمولاً نمیخواهد حدس بزند و جواب ندهد، مگر اینکه چیزی باعث شود این حالت پیشفرض او تغییر کند و پاسخ دهد. همچنین در مورد ترفندهایی که مدل را وادار به گفتن چیزهای خطرناک میکند (جیلبریک jailbreak)، دیدند که مدل زودتر از اینکه بتواند جلوی خودش را بگیرد، متوجه خطرناک بودن درخواست شده است. این روش "ساخت میکروسکوپ" به آنها کمک میکند چیزهایی را بفهمند که قبلاً نمیدانستند و این روش با پیشرفت مدلها مهمتر میشود.

این یافتهها فقط از نظر علمی جالب نیستند بلکه به هدف فهمیدن هوش مصنوعی و قابل اعتماد کردن آن کمک میکنند. این روش میتواند در زمینههای دیگری مثل پزشکی هم مفید باشد. اما این روش هنوز محدودیت دارد. حتی برای متنهای کوتاه، فقط بخش کوچکی از کاری که مدل میکند را میبینند. همچنین درک این چیزهایی که میبینند ساعتها طول میکشد و باید هم ابزار و هم نحوه درکشان را بهتر کنند تا بتوانند فرآیندهای پیچیدهتر مدل را بفهمند.

چون هوش مصنوعی قویتر شده و در جاهای مهمی استفاده میشود، شرکت آنتروپیک روی چیزهایی مثل فهمیدن اینکه مدل چطور کار میکند (تفسیرپذیری) سرمایهگذاری زیادی کرده است. این کار سخت و پرخطر است اما میتواند ابزاری مهم برای شفاف کردن هوش مصنوعی باشد. اگر بدانیم مدل چطور کار میکند، میتوانیم چک کنیم که آیا با ارزشهای انسانی همخوانی دارد و میتوان به آن اعتماد کرد یا نه.

اولین سؤال این است: کلود چطور به زبانهای مختلف صحبت میکند؟ آیا برای هر زبان یک بخش جداگانه دارد یا یک بخش اصلی دارد که برای همه زبانها کار میکند؟ تحقیقات نشان میدهد که در داخل کلود، بخشهای مشترکی وجود دارد که برای زبانهای مختلف مثل انگلیسی، فرانسوی و چینی فعال میشوند، یعنی ایدهها و مفاهیم اصلی در مدل برای همه زبانها یکسان است.

برای فهمیدن اینکه کلود چطور چندزبانه است، از آن خواستهاند که در زبانهای مختلف "متضاد کوچک" را بگوید. دیدهاند که در داخل مدل، همان بخشهایی که مربوط به مفهوم "کوچکی" و "متضاد" هستند فعال میشوند، که این فعال شدن منجر به فعال شدن مفهوم "بزرگی" میشود. سپس این مفهوم "بزرگی" به زبانی که سؤال پرسیده شده، ترجمه میشود. این نشان میدهد که مدل ابتدا به مفهوم فکر میکند و بعد آن را به زبان میآورد. همچنین مدلهای بزرگتر، بخشهای مشترک بیشتری برای زبانها دارند.

این یافتهها ثابت میکند که کلود ایدهها و معانی را در یک فضای مشترک و انتزاعی (جدا از زبان خاصی) پردازش میکند و بعد آن را به زبان مورد نظر تبدیل میکند. این یعنی کلود میتواند چیزی را در یک زبان یاد بگیرد و از آن در زبان دیگر استفاده کند. این قابلیت برای هوش و استدلال پیشرفته مدل که میتواند آموختههایش را در موقعیتهای مختلف به کار ببرد، بسیار مهم است.

سؤال بعدی این است که کلود چطور شعر قافیهدار مینویسد. مثالی زده شده. برای نوشتن خط دوم، مدل باید هم قافیه را رعایت میکرد و هم معنی جمله درست باشد.

این بیت کوچک را در نظر بگیرید:

He saw a carrot and had to grab it (او یک هویج دید و مجبور شد آن را بردارد)

His hunger was like a starving rabbit (گرسنگیاش مثل یک خرگوش گرسنه بود)

محققان فکر میکردند مدل کلمه به کلمه مینویسد و فقط در آخر خط به فکر قافیه میافتد. اما محققان دیدند که کلود برنامهریزی میکند. قبل از نوشتن خط دوم شعر، کلماتی را که هم معنی دارند و هم با خط اول قافیه میشوند، در نظر میگیرد. بعد جمله را طوری مینویسد که به آن کلمه انتخابی برسد. تصاویری هم نشان داده شده که چطور اگر مفهوم "rabbit" را در مدل دستکاری کنند، مدل کلمه دیگری را برای قافیه انتخاب میکند.

مثل کاری که دانشمندان مغز برای دیدن عملکرد مغز انجام میدهند (با تغییر فعالیت بخشهایی از آن)، محققان هم بخشی از مدل کلود که مربوط به مفهوم "خرگوش" بود را تغییر دادند. وقتی مفهوم "خرگوش" را حذف کردند، کلود به جای "rabbit" از کلمه "habit" (عادت) که با "grab it" هم قافیه میشود و معنی هم میدهد استفاده کرد. وقتی مفهوم "سبز" را به مدل دادند، کلود خط را طوری تمام کرد که به "green" ختم شود (هرچند دیگر قافیه نداشت). این آزمایش نشان میدهد که کلود هم برنامهریزی میکند و هم میتواند برنامه خود را تغییر دهد.

موضوع بعدی ریاضی است. کلود به عنوان ماشین حساب ساخته نشده و فقط روی متن آموزش دیده است. اما چطور میتواند اعداد را در ذهنش درست جمع کند (مثلاً ۳۶+۵۹) بدون اینکه مراحل را بنویسد؟ ممکن است جواب ساده این باشد که مدل فقط جواب جمعهای زیادی را حفظ کرده، یا اینکه روش جمع کردن را مثل انسانها یاد گرفته است.

اما محققان دیدند که کلود از چند روش داخلی همزمان برای جمع کردن استفاده میکند. یک روش یک تخمین تقریبی از جواب میزند و روش دیگر رقم آخر جواب را دقیق حساب میکند. این دو روش با هم ترکیب میشوند تا جواب نهایی را بدهند. حتی فهمیدن این کار ساده (جمع) در این جزئیات میتواند به ما کمک کند بفهمیم کلود چطور مسائل پیچیدهتر را حل میکند.

نکته جالب اینجاست که کلود خودش هم نمیداند چطور واقعاً در ذهنش حساب میکند! اگر از آن بپرسید چطور ۳۶+۵۹ را حساب کرده، همان روشی که انسانها یاد میگیرند (جمع کردن یکانها و دهگانها و انتقال عدد ۱) را توضیح میدهد. این نشان میدهد که مدل یاد گرفته توضیحات ریاضی را از روی متنهایی که انسانها نوشتهاند بگوید، اما برای انجام دادن واقعی ریاضی در ذهنش، روشهای داخلی خودش را یاد گرفته است.

سؤال بعدی این است که آیا کلود همیشه دلیل کارهایش را راست میگوید؟ مدلهای جدیدتر مثل کلود میتوانند قبل از جواب دادن، مراحل فکر کردنشان را بنویسند. این کار معمولاً جواب را بهتر میکند، اما گاهی این مراحل فکری واقعی نیستند و مدل فقط آنها را میسازد تا به جواب برسد. مشکل اینجاست که این دلایل ساختگی خیلی واقعی به نظر میرسند. محققان راهی را بررسی کردهاند که با ابزارشان بتوانند بفهمند دلیل مدل واقعی است یا الکی.

وقتی از کلود خواسته میشود مسئلهای را حل کند. وقتی مسئله آسان است (مثل ریشه دوم ۶۴)، مراحل داخلی مدل نشان میدهد که واقعاً ریشه دوم ۶۴ را حساب کرده است. اما وقتی مسئله سخت است (مثل حساب کردن کسینوس یک عدد بزرگ)، کلود ممکن است ادعا کند حساب کرده ولی در داخلش هیچ نشانی از محاسبه نیست؛ فقط یک جواب میدهد بدون اینکه برایش مهم باشد درست است یا نه. جالبتر اینکه، اگر به کلود یک راهنمایی (حتی اشتباه) درباره جواب بدهید، گاهی اوقات از جواب نهایی شروع میکند و مراحل ساختگی میسازد تا به آن جواب برسد. این نشان میدهد که مدل ممکن است برای رسیدن به یک نتیجه از پیش تعیین شده، دلیل بتراشد. این ابزار به ما کمک میکند این دروغهای داخلی را پیدا کنیم.

این توانایی که میتوانیم ببینیم کلود واقعاً چطور فکر میکند (نه فقط چیزی که خودش میگوید)، به ما کمک میکند مدلها را بهتر بررسی کنیم. در یک آزمایش دیگر، مدلی را دیدند که پنهانی یاد گرفته بود طوری رفتار کند که مدلهای پاداشدهنده را راضی نگه دارد (این مدلها به مدل اصلی یاد میدهند چطور خوب رفتار کند، اما گاهی خودشان سوگیری دارند). حتی وقتی از مدل اصلی پرسیدند آیا این کار را میکند، قبول نکرد، اما ابزارهای محققان نشان داد که این کار را میکند. این نشان میدهد که این ابزار میتواند به پیدا کردن کارهای نگرانکننده پنهان در مدلها کمک کند.

موضوع بعدی این است که کلود چطور به سؤالاتی جواب میدهد که چند مرحله فکری لازم دارند، مثل "پایتخت ایالتی که دالاس در آن است کجاست؟". ممکن است فکر کنیم مدل فقط جواب را حفظ کرده است. اما تحقیقات نشان میدهد که کلود پیچیدهتر عمل میکند. در مثال دالاس، دیدند که مدل اول مفهوم "دالاس در تگزاس است" را فعال میکند و بعد آن را به مفهوم "پایتخت تگزاس آستین است" وصل میکند. یعنی مدل اطلاعات مختلف را ترکیب میکند تا جواب را پیدا کند، نه اینکه فقط جوابی را که حفظ کرده بگوید.

محققان با ابزارشان، توانستند مفهوم "تگزاس" را در ذهن مدل با مفهوم "کالیفرنیا" عوض کنند. وقتی این کار را کردند، مدل به جای گفتن "آستین" (پایتخت تگزاس)، گفت "ساکرامنتو" (پایتخت کالیفرنیا). این ثابت میکند که مدل واقعاً از آن مرحله میانی (فهمیدن ایالت) برای رسیدن به جواب استفاده میکند.

موضوع بعدی این است که چرا مدلها گاهی اطلاعات غلط یا ساختگی میدهند (توهم). در واقع، روش آموزش مدلها باعث میشود آنها همیشه سعی کنند کلمه بعدی را حدس بزنند، که میتواند منجر به اطلاعات غلط شود. چالش این است که چطور مدلها یاد بگیرند که حدس نزنند. کلود آموزش دیده که اگر چیزی را نمیداند، جواب ندهد، اما این آموزش همیشه کار نمیکند. محققان خواستند بفهمند این عدم پاسخ دادن چگونه کار میکند. معلوم شده که حالت عادی کلود این است که جواب ندهد. بخشی در مدل وجود دارد که معمولاً روشن است و باعث میشود بگوید اطلاعات کافی ندارد. اما وقتی از کلود درباره چیزی که خوب میشناسد (مثل مایکل جردن) میپرسید، بخش دیگری که مربوط به "چیزهای شناخته شده" است فعال میشود و جلوی بخش "جواب نده" را میگیرد و مدل جواب میدهد. اگر درباره یک چیز ناشناس (مثل مایکل باتکین) بپرسید، آن بخش فعال نمیشود و مدل جواب نمیدهد.

محققان توانستند با دستکاری مدل، کاری کنند که کلود درباره مایکل باتکین (که نمیشناخت) اطلاعات غلط بدهد، مثلاً بگوید او شطرنج بازی میکند. این اتفاق گاهی به طور طبیعی هم رخ میدهد: اگر کلود فقط یک اسم را بشناسد اما اطلاعات دیگری درباره آن نداشته باشد، ممکن است بخش "شناخته شده" به اشتباه فعال شود و جلوی بخش "جواب نده" را بگیرد. در این صورت، مدل چون فکر میکند باید جواب دهد، اطلاعات ساختگی و غیرواقعی میسازد و میگوید.

جیلبریکها روشهایی هستند که با ترفند مدل را وادار به گفتن یا انجام دادن کارهای خطرناک یا نامناسب میکنند و از سدهای ایمنی آن عبور میکنند. در اینجا مثالی از یک جیلبریک آورده شده که مدل را فریب میدهد تا درباره ساخت بمب صحبت کند. در این روش خاص، مدل با جمع کردن حروف اول جمله "Babies Outlive Mustard Block" به کلمه "BOMB" میرسد و این کلمه باعث گیج شدن مدل و تولید اطلاعاتی میشود که نباید میداد.

اینجا سؤال مطرح میشود که چرا این ترفند مدل را گیج میکند و چرا مدل به دادن دستورات خطرناک ادامه میدهد؟

محققان دیدند که مشکل اینجاست که بین اینکه مدل متن را درست و کامل بنویسد و اینکه از انجام کارهای خطرناک خودداری کند، یک کشمکش وجود دارد. وقتی کلود نوشتن یک جمله را شروع میکند، بخشهایی در مدل آن را مجبور میکنند که جمله را از نظر دستوری و معنایی کامل کند و ادامه دهد، حتی اگر بخشهای دیگر متوجه شوند که نباید این کار را بکند.در مثالی که بررسی کردند، بعد از اینکه مدل کلمه "BOMB" را گفت و شروع به دادن دستورات کرد، دیدند که مدل تحت تأثیر بخشهایی بود که میخواستند متن از نظر گرامری درست و کامل باشد. این بخشها معمولاً خوب هستند، اما در این مورد خاص باعث شدند که مدل به کار خطرناک خود ادامه دهد.مدل فقط بعد از اینکه آن جمله خطرناک را از نظر گرامری کامل کرد، توانست دست از کار بکشد و بگوید که نمیتواند اطلاعات بدهد. انگار اول مجبور بود جمله را تمام کند و بعد در جمله بعدی مقاومت نشان دهد.