هوش مصنوعی در سالهای اخیر توانسته قدرت چشمگیری در تحلیل دادههای بصری پیدا کند. از تشخیص اجزای صفحه گرفته تا تولید طراحیهای گرافیکی، مدلهایی مانند CNN به ابزارهای محبوبی برای درک بصری محیط تبدیل شدهاند. با این حال، وقتی پای تجربه کاربری (UX) به میان میآید، هنوز فاصله زیادی بین «دیدن» و «درک کردن» وجود دارد. در این مقاله، نگاهی داریم به محدودیتهای ذاتی مدلهای پردازش تصویر در تحلیل تجربه کاربری، و اینکه چرا هنوز هم تصمیمگیری نهایی در UX، به انسان نیاز دارد. مدلهای بینایی ماشین میتوانند تشخیص دهند که یک دکمه در کجا قرار گرفته یا چیدمان صفحه چگونه است، اما نمیدانند چرا کاربر روی دکمه کلیک نمیکند یا در چه نقطهای تجربهاش دچار اختلال میشود.

دون نورمن (Don Norman)، بنیانگذار مفهوم UX:

"درک رفتار انسانها به شناسایی الگوها در پیکسلها محدود نمیشود. موضوع اصلی، همدلی، نیت و بافت است — چیزهایی که هوش مصنوعی هنوز فاقد آنهاست."

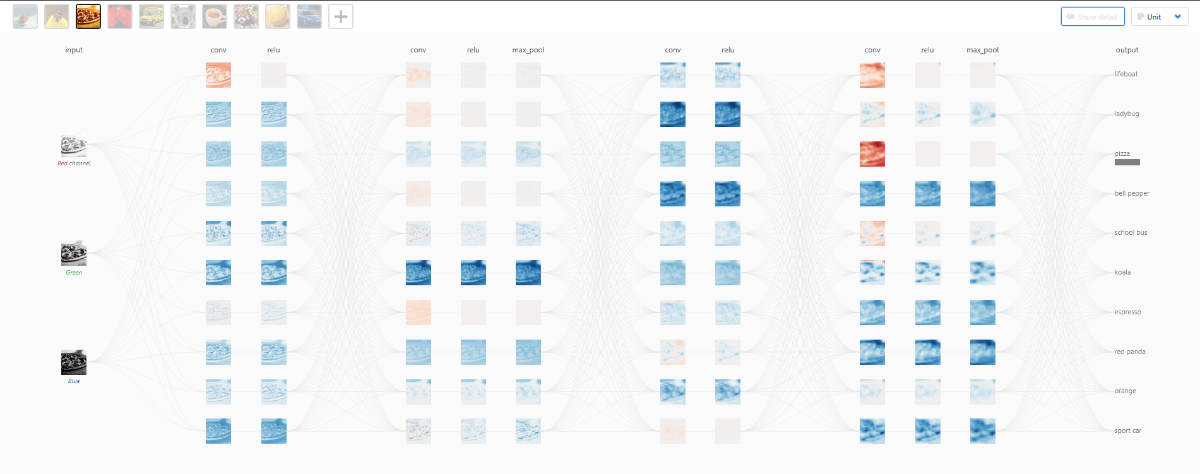

شبکه عصبی کانولوشنی (Convolutional Neural Network یا بهاختصار CNN) یکی از رایجترین مدلهای پردازش تصویر است. عملکرد آن را میتوان در چند مرحله توضیح داد:

بهزبان ساده، CNN فقط یاد میگیرد که «چه چیزی شبیه چه چیزیست» — اما نمیداند «چرا آن چیز در آنجا قرار دارد» یا «چه تاثیری بر کاربر دارد».

برای آنکه هوش مصنوعی بتواند تجربه کاربری را بهتر بفهمد، باید از مدلهایی فراتر از تصویر استفاده کنیم:

تیم فیگما در بلاگ رسمیشان نوشتهاند:

"هوش مصنوعی میتواند الگوهای طراحی تولید کند، اما اینکه این الگوها واقعاً قابلفهم یا کاربردی باشند، چیزی است که فقط انسانها — و کاربران واقعی — میتوانند مشخص کنند."

طراحی UX یعنی درک اهداف انسانی در بستر انسانی. چیزی فراتر از تشخیص بصری.

جرد اسپول (Jared Spool)، پژوهشگر تجربه کاربری:

"هوش مصنوعی در شبیهسازی طراحی عالی عمل میکند. اما شبیهسازی همدلی؟ آن دیگر طراحی نیست — نمایش است."

هوش مصنوعی میتواند ابزار خوبی برای تحلیل رابط کاربری باشد، اما تا زمانی که نتواند نیت، احساس و تجربه انسانی را درک کند، تصمیمگیری درباره UX همچنان وظیفهای انسانی باقی میماند.

تا اطلاع ثانوی، طراحی تجربه کاربری هنوز قلمرو طراحان است — و شاید اینطور هم بهتر باشد.