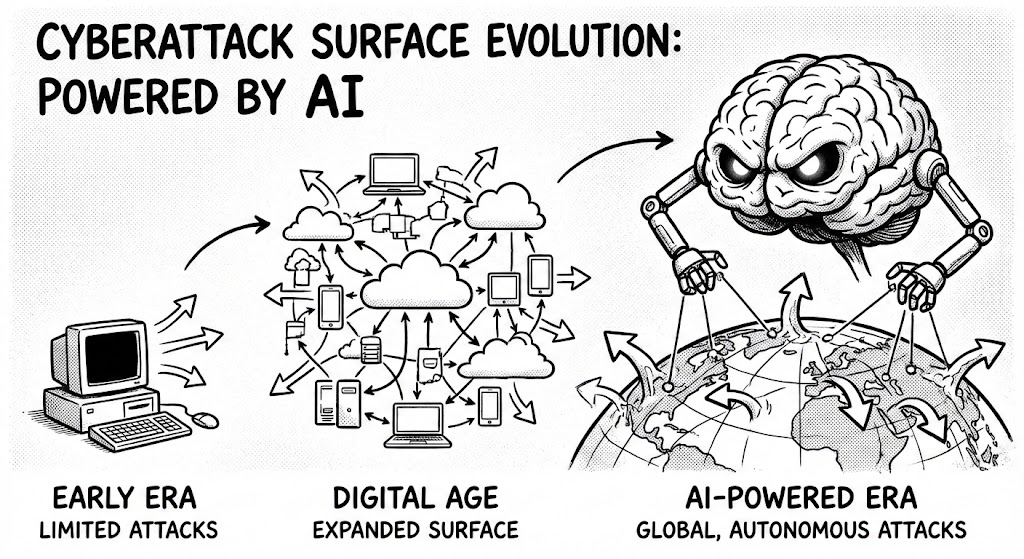

در حالی که کسبوکارها از هوش مصنوعی برای بهبود خدمات خود استفاده میکنند، مهاجمان نیز از آن برای افزایش مقیاس، پیچیدگی و کارایی حملات خود بهره میبرند. هدف این متن، تحلیل بردارهای حمله نوظهور مبتنی بر هوش مصنوعی است تا متخصصان امنیت سایبری را برای مقابله با این موج جدید از تهدیدات آماده سازد. برای درک این حملات، ابتدا باید مکانیزم فنی اصلی که نیروی محرکه آنهاست را بررسی کنیم.

درک معماری فنی مشترک پشت این تهدیدات جدید، از اهمیت استراتژیک برخوردار است، زیرا به ما امکان میدهد تا به جای واکنش به حملات ، به طور پیشگیرانه از خود دفاع کنیم. یک الگوی تکرارشونده در این حملات، استفاده از یک «عامل» (Agent) هوشمند خودمختار برای رهبری و هماهنگی حمله است. این عامل مانند یک مدیر پروژه عمل میکند که میتواند به طور مستقل تصمیمگیری کرده، وظایف را برنامهریزی و عملیات را اجرا کند.

عامل برای انجام وظایف تحلیلی و تولید محتوای خود، از یک «مدل زبانی بزرگ» (LLM) به عنوان موتور پردازشی استفاده میکند. LLM در تجزیه و تحلیل اسناد پیچیده (مانند گزارشهای آسیبپذیری)، درک دادههای بدون ساختار و تولید محتوای بسیار متقاعدکننده مانند ایمیلهای فیشینگ یا کدهای بدافزار، تخصص دارد. این ترکیب قدرتمند عامل و LLM، پایه و اساس فنی بردارهای حمله متنوعی را تشکیل میدهد.

این بخش به بررسی شش نمونه مشخص از حملاتی میپردازد که با استفاده از هوش مصنوعی تقویت شدهاند. این حملات دیگر در حوزه تئوری قرار ندارند و به طور فعال در حال وقوع هستند. هر یک از این بردارها، کاربرد عملی معماری عامل/LLM است که در بخش قبل توضیح داده شد.

هوش مصنوعی فرآیند تلاش برای ورود به سیستم را خودکار و بهینهسازی میکند و به طور چشمگیری کارایی و مقیاس حملات مبتنی بر اعتبارنامه را افزایش میدهد. ابزاری مانند BruteForceAI، که در اصل یک چارچوب تست نفوذ (pen testing) است اما به راحتی میتواند برای اهداف مخرب استفاده شود، از یک عامل و یک LLM برای شناسایی خودکار صفحات ورود به سیستم در وبسایتها استفاده میکند. LLM با تجزیه و تحلیل صفحه، فرمهای ورود را با نرخ موفقیت ۹۵٪ شناسایی میکند. پس از شناسایی، عامل یکی از دو نوع حمله زیر را اجرا میکند:

حمله Brute Force: در این روش، عامل تمام ترکیبات ممکن شناسههای کاربری و رمزهای عبور را روی یک حساب کاربری آزمایش میکند. این روش به دلیل وجود سیاستهای قفل حساب (مانند مسدود شدن پس از سه تلاش ناموفق) اغلب کارایی محدودی دارد.

حمله Password Spraying: در این روش هوشمندانهتر، عامل یک رمز عبور رایج را بر روی تعداد زیادی از حسابهای کاربری مختلف امتحان میکند. این تاکتیک به طور خاص از سیاستهای قفل حساب برای هر کاربر (per-account) که با تلاشهای مکرر روی یک حساب فعال میشوند، عبور میکند و شانس موفقیت را به طور قابل توجهی افزایش میدهد.

پیامد استراتژیک این قابلیت این است که هوش مصنوعی به مهاجمان اجازه میدهد تا حملات ورود به سیستم را در مقیاس وسیع و با حداقل دخالت انسان اجرا کنند.

هوش مصنوعی قادر است یک چرخه عمر کامل حمله باجافزاری را به صورت کاملاً خودکار هدایت کند. یک پروژه تحقیقاتی به نام prompt lock نشان داد که چگونه یک عامل هوش مصنوعی میتواند تمام مراحل یک حمله را به تنهایی مدیریت کند:

برنامهریزی حمله: عامل به طور مستقل اهداف و استراتژی کلی حمله را تعیین میکند.

تحلیل دادههای حساس: پس از نفوذ، عامل فایلها را تحلیل کرده و دادههای باارزش را برای به حداکثر رساندن باج ممکن، شناسایی و اولویتبندی میکند.

تولید حمله: عامل کد لازم برای اجرای تاکتیکهای مخرب را مینویسد.

اجرای حمله: در نهایت، عامل عملیات را اجرا میکند که میتواند شامل رمزگذاری دادهها برای دریافت باج در ازای کلید رمزگشایی، استخراج دادهها (exfiltration) با تهدید به انتشار عمومی آنها، یا تهدید به حذف کامل دادهها برای افزایش فشار بر قربانی باشد.

علاوه بر این، هوش مصنوعی قابلیتهای پیشرفتهتری را نیز فعال میکند:

یادداشتهای باجخواهی شخصیسازی شده: LLMها میتوانند یادداشتهای باجخواهی بسیار متقاعدکننده و سفارشیسازی شده تولید کنند که به طور خاص به فایلهای قربانی اشاره میکند.

حملات چندریختی (Polymorphic): هوش مصنوعی میتواند کد حمله را برای هر قربانی به طور منحصر به فرد تغییر دهد. این امر باعث میشود که شناسایی حمله با استفاده از روشهای مبتنی بر امضا (signature-based detection) تقریباً غیرممکن شود.

این قابلیتها حتی میتوانند در قالب «باجافزار به عنوان یک سرویس» (Ransomware as a Service) در فضای ابری ارائه شوند و در دسترس طیف گستردهای از مهاجمان قرار گیرند.

هوش مصنوعی، به ویژه LLMها، اثربخشی حملات فیشینگ را به طور چشمگیری افزایش دادهاند. LLMها میتوانند ایمیلهایی با گرامر و املای بینقص به هر زبانی تولید کنند، حتی اگر مهاجم به آن زبان تسلط نداشته باشد. این موضوع یکی از شاخصهای کلیدی سنتی برای شناسایی ایمیلهای فیشینگ را از بین میبرد و بازآموزی کاربران را برای شناسایی نشانههای جدید ضروری میسازد. مهاجمان برای این کار از LLMهای بدون محدودیت (guardrails) که اغلب در دارک وب یافت میشوند، استفاده میکنند، زیرا مدلهای تجاری رایج از تولید محتوای مخرب خودداری میکنند.

مهمتر از آن، هوش مصنوعی قابلیت «فرا-شخصیسازی» (hyper-personalization) را فراهم میکند. یک عامل هوش مصنوعی میتواند به طور خودکار رسانههای اجتماعی و منابع عمومی را برای جمعآوری اطلاعات در مورد یک هدف خاص جستجو کند. سپس از این اطلاعات برای ایجاد یک ایمیل فیشینگ بسیار خاص و قابل باور استفاده میکند که احتمال موفقیت آن را به شدت افزایش میدهد.

نتایج یک آزمایش توسط IBM تکاندهنده است: یک هوش مصنوعی تنها در ۵ دقیقه یک ایمیل فیشینگ تولید کرد که اثربخشی آن تقریباً با ایمیلی که یک انسان در ۱۶ ساعت ایجاد کرده بود، برابر بود. این مقایسه پیامدهای اقتصادی این فناوری را به وضوح نشان میدهد و با توجه به اینکه هوش مصنوعی به طور مداوم در حال بهبود است، این تهدید روز به روز جدیتر خواهد شد.

کلاهبرداری مبتنی بر هوش مصنوعی با استفاده از دیپفیک (Deepfake) به یک تهدید بسیار واقعی تبدیل شده است. فرآیند ایجاد یک دیپفیک با استفاده از هوش مصنوعی مولد (Generative AI) به شرح زیر است:

یک نمونه صوتی یا تصویری از هدف (قربانی) به مدل هوش مصنوعی مولد داده میشود.

مدل، یک کپی دیجیتال از ظاهر، صدا و رفتار هدف ایجاد میکند.

مهاجم یک اسکریپت (متن) ارائه میدهد و مدل، خروجی دیپفیک را تولید میکند که در آن هدف، کلمات مهاجم را بیان میکند.

نکته نگرانکننده این است که برای ایجاد یک دیپفیک صوتی بسیار باورپذیر، تنها به چند ثانیه از صدای یک فرد (حتی به کوتاهی سه ثانیه) نیاز است. تأثیر این فناوری در دنیای واقعی قبلاً به اثبات رسیده است:

۲۰۲۱: یک دیپفیک صوتی که صدای یک مدیر اجرایی را تقلید میکرد، کارمندی را متقاعد کرد تا ۳۵ میلیون دلار را به حساب مهاجمان منتقل کند.

۲۰۲۴: یک دیپفیک ویدیویی از یک مدیر ارشد مالی (CFO) در یک تماس ویدیویی، منجر به انتقال ۲۵ میلیون دلار دیگر شد.

پیام این حوادث قاطع و روشن است: در ارتباطات دیجیتال، دیگر نمیتوان به حواس بینایی و شنوایی اعتماد کرد مگر اینکه حضور فیزیکی تأیید شده باشد.

هوش مصنوعی فرآیند ایجاد کد اکسپلویت برای آسیبپذیریهای شناختهشده را دموکراتیزه میکند و آن را در دسترس افرادی قرار میدهد که مهارت برنامهنویسی ندارند. پروژه تحقیقاتی CVE Genie این قابلیت را به نمایش گذاشت. در این پروژه، یک عامل هوش مصنوعی اسناد عمومی مربوط به آسیبپذیریها و افشاگریهای رایج (CVE) را به یک LLM میدهد. LLM جزئیات فنی آسیبپذیری را استخراج کرده و اطلاعات را به عامل بازمیگرداند. سپس عامل از این اطلاعات برای نوشتن خودکار کد اکسپلویت کاربردی استفاده میکند.

نتایج کلیدی این پروژه عبارتند از:

نرخ موفقیت ۵۱٪ در تولید اکسپلویتهای کاربردی از روی اسناد عمومی.

هزینه تولید هر اکسپلویت کمتر از ۳ دلار.

پیامد استراتژیک این موضوع این است که مهاجمان فاقد مهارتهای فنی اکنون میتوانند اکسپلویتهای پیچیده تولید کنند. این قابلیت همچنین میتواند برای ایجاد بدافزارهای (malware) مبهم (obfuscated) استفاده شود که شناسایی آنها را برای سیستمهای امنیتی بسیار دشوارتر میکند.

بردارهای حمله منفردی که مورد بحث قرار گرفتند، تنها بخشی از یک تصویر بزرگتر هستند. تهدید نهایی، ادغام این قابلیتها در یک کمپین حمله کاملاً خودمختار است که توسط یک عامل هوش مصنوعی واحد هدایت میشود. چنین عاملی میتواند کل زنجیره کشتار (Kill Chain) را از ابتدا تا انتها مدیریت کند:

اتخاذ تصمیمات استراتژیک: انتخاب اهداف با ارزش و تعیین نوع حمله مناسب.

شناسایی قربانی: یافتن سازمانها یا افرادی که بیشترین پتانسیل برای پرداخت باج را دارند.

تحلیل دادهها: پردازش حجم عظیمی از دادههای سرقت شده برای شناسایی اطلاعات حیاتی.

ایجاد هویتهای جعلی: ساختن شخصیتهای ساختگی برای پنهان کردن هویت مهاجم در حین اخاذی.

ایجاد باجافزار: تولید خودکار بدافزار سفارشی برای هر حمله.

تنظیم مطالبات باج: کالیبره کردن مبلغ درخواستی بر اساس ارزش دادهها و توانایی مالی هدف.

این تحول، پارادایم مهارتهای مورد نیاز برای یک مهاجم را به طور کامل تغییر میدهد. دیگر نیازی به تخصص فنی نخبه نیست؛ مهاجم تنها کافی است ایده کلی حمله را به عامل هوش مصنوعی بدهد (رویکردی که "vibe hacking" نامیده میشود) و هوش مصنوعی تمام جزئیات پیچیده اجرا را بر عهده میگیرد. این پارادایم «vibe hacking»، بسیار شبیه به تولید خودکار اکسپلویت توسط CVE Genie، نمایانگر دموکراتیزه شدن نهایی حملات سایبری پیشرفته است که آنها را از حوزه متخصصان نخبه به هر فردی با نیت مخرب و دسترسی به یک عامل هوش مصنوعی منتقل میکند.

برای مقابله با این چالش فزاینده، سازمانها دیگر نمیتوانند به روشهای دفاعی سنتی اکتفا کنند. توصیه استراتژیک نهایی روشن است: تنها راه برای مقابله با هوش مصنوعی مهاجم، استفاده از هوش مصنوعی برای دفاع است. سازمانها باید هوش مصنوعی را برای تقویت قابلیتهای پیشگیری، شناسایی و پاسخ خود به کار گیرند. آینده امنیت سایبری یک نبرد بین «هوش مصنوعی خوب در مقابل هوش مصنوعی بد» خواهد بود و اطمینان از پیروزی هوش مصنوعی خوب یک ضرورت انکارناپذیر است.