به قلم پوریا دیانتی، ورودی ۴۰۰ کارشناسی مهندسی کامپیوتر صنعتی اصفهان

بازنگریشده توسط پارسا شیرکوند، ورودی ۴۰۲ کارشناسی مهندسی کامپیوتر صنعتی اصفهان

وقتی صحبت از هوش مصنوعی میشود، اغلب نگاهها متوجه الگوریتمها و مدلهای پیچیدهی ریاضی است. اما باید در نظر داشت که هیچ الگوریتمی—حتی پیشرفتهترین آنها—بدون داده توان کار کردن ندارد. داده، مادهی خامی است که الگوریتمها را تغذیه میکند و به آنها امکان میدهد الگوهای نهفته در جهان واقعی را شناسایی کنند. درست مثل موتور قدرتمندی که بدون سوخت فقط یک تکه فلز بیجان است.

در دهههای آغازین تحقیقات هوش مصنوعی (۶۰ و ۷۰ میلادی)، رویکردها بیشتر بر سیستمهای خبره (Expert Systems) متمرکز بود. پژوهشگران سعی میکردند دانش و قوانین یک حوزه را بهطور دستی وارد کامپیوتر کنند. مشکل اینجا بود که دنیا بسیار پیچیدهتر از آن است که بتوان همهی قوانینش را نوشت. نتیجه این شد که با وجود شور و شوق اولیه، پیشرفت چندانی حاصل نشد.

تحول واقعی از زمانی آغاز شد که پژوهشگران به جای «قانوننویسی»، به یادگیری از دادهها روی آوردند. این تغییر رویکرد با افزایش دسترسی به دادههای دیجیتال همزمان شد. رشد اینترنت در دههی ۹۰، دیجیتالی شدن فرآیندهای تجاری و اجتماعی، و بعدتر شبکههای اجتماعی و گوشیهای هوشمند، به انبوهی از دادهها منجر شد. همین پدیده بود که بعدها با عنوان Big Data شناخته شد: دادههایی با حجم بسیار زیاد، سرعت تولید بالا، و تنوع گسترده.

این دادههای عظیم، بستر رشد الگوریتمهای جدید را فراهم کردند؛ بهویژه یادگیری عمیق (Deep Learning) که در سالهای ۲۰۱۰ به بعد جهش بزرگی در هوش مصنوعی ایجاد کرد. دلیل موفقیت یادگیری عمیق هم دقیقاً همین بود که برای عملکرد خوب، نیاز به حجم عظیمی از دادههای برچسبخورده دارد. برای نمونه:

پیشرفت چشمگیر در تشخیص تصویر (مثلاً شناسایی گربه در یک ویدئو یا تشخیص تومور در تصاویر پزشکی) زمانی امکانپذیر شد که میلیونها تصویر دیجیتال همراه با برچسب در دسترس پژوهشگران قرار گرفت.

در پردازش زبان طبیعی، موتورهای ترجمهی ماشینی یا چتباتها توانستند کیفیتی نزدیک به ترجمهی انسانی پیدا کنند، چون میلیاردها جملهی موازی در زبانهای مختلف جمعآوری و استفاده شد.

به زبان ساده: هرچه داده بیشتر، متنوعتر و باکیفیتتر باشد، مدلهای هوش مصنوعی هم «باهوشتر» میشوند. درست شبیه کودکی که اگر فقط در یک محیط کوچک زندگی کند، تجربیات محدودی خواهد داشت؛ اما اگر در معرض انواع موقعیتها، فرهنگها و زبانها قرار بگیرد، فهم عمیقتر و گستردهتری از جهان پیدا میکند.

همانطور که برای ساختن یک بنا به مصالح مختلف نیاز داریم، برای ساختن هوش مصنوعی هم دادهها در شکلها و قالبهای گوناگون مورد استفاده قرار میگیرند. شناخت این دستهبندیها کمک میکند بفهمیم چرا بعضی الگوریتمها برای یک نوع داده فوقالعاده عمل میکنند ولی برای نوع دیگر به ابزارهای متفاوتی نیاز دارند.

دادهها را میتوان بر اساس میزان نظم و ساختارشان دستهبندی کرد. بخشی از آنها کاملاً منظماند و شکل جدول دارند؛ یعنی هر ردیف و ستون معنا و جایگاه مشخصی دارد. پایگاههای دادهی سنتی مثل SQL دقیقاً برای همین نوع اطلاعات ساخته شدهاند. نمونهی روشن آن تراکنشهای بانکی است که شامل مبلغ، تاریخ و شماره حساب میشود، یا فهرست مشتریان یک فروشگاه و دادههای حسگرهایی که در هر لحظه دما و فشار را ثبت میکنند. مزیت این شکل از دادهها پیشبینیپذیری و سهولت پردازش است، هرچند که در عمل تنها بخش کوچکی از واقعیتهای پیچیدهی جهان را پوشش میدهند.

در مقابل، نوعی از دادهها وجود دارد که نه به اندازهی جدولها منظماند و نه آنقدر بیسامان که نتوان الگویی در آنها پیدا کرد. به اینها دادههای نیمهساختیافته گفته میشود. این دادهها شکل ثابتی ندارند اما میتوان نظم کلی یا الگوی تکرارشوندهای در آنها دید. فایلهای JSON یا XML، ایمیلها با بخشهای مختلفی مثل متن، فرستنده، زمان و پیوست، و همچنین لاگهای سیستم نمونههایی از این گروه هستند. چنین دادههایی انعطافپذیرترند و در عین حال همچنان قابلیت پردازش نسبتاً بالایی دارند.

اما دنیای اصلی دادهها در عصر دیجیتال به دادههای بدون ساختار تعلق دارد. حجم عظیمی از آنچه امروز تولید میشود در این دسته قرار میگیرد: متنهایی مثل پستهای شبکههای اجتماعی، مقالات یا پیامها؛ تصاویر و ویدئوها؛ و همچنین فایلهای صوتی و موسیقی. این دادهها در حالت خام برای ماشینها چندان قابل استفاده نیستند؛ مثلاً عکسی که برای ما بلافاصله قابل درک است، برای کامپیوتر چیزی جز مجموعهای از پیکسلها به نظر نمیرسد. همین چالش باعث شد که روشهای پیشرفتهای مثل یادگیری عمیق، شبکههای عصبی کانولوشنی در حوزهی تصویر و مدلهای زبانی در حوزهی متن، وارد عمل شوند و توانایی پردازش و فهم این نوع دادهها را فراهم کنند.

لازم به ذکر است که در عمل، اکثر سامانههای هوش مصنوعی ترکیبی از انواع مختلف دادهها را مصرف میکنند. برای مثال، یک سرویس پیشنهاد فیلم ممکن است از دادههای ساختیافته (امتیازدهی کاربران)، دادههای نیمهساختیافته (لاگهای فعالیت کاربر) و دادههای بدون ساختار (پوستر فیلمها، توضیحات متنی) همزمان استفاده کند. هرچه تنوع دادهها بیشتر باشد، درک مدل از جهان واقعی نیز کاملتر خواهد بود.

در حوزهی هوش مصنوعی معمولاً این تصور وجود دارد که هرچه داده بیشتر باشد، نتیجهی بهتری به دست میآید. درست است که الگوریتمها برای کشف الگوهای پنهان به حجم بالایی از داده نیاز دارند، اما صرفِ داشتن دادهی زیاد کافی نیست. اگر کیفیت داده پایین باشد، حتی میلیونها نمونه هم نمیتواند مدلی دقیق و قابل اعتماد بسازد.

کیفیت داده یعنی اطلاعاتی که به مدل داده میشود باید دقیق، مرتبط و عاری از خطا باشد. دادههای ناقص یا پر از نویز نهتنها کمکی نمیکنند، بلکه مدل را منحرف میسازند. به همین دلیل بخش بزرگی از پروژههای هوش مصنوعی صرف پاکسازی و آمادهسازی دادهها میشود؛ کاری که گاهی از طراحی خود الگوریتم هم پیچیدهتر و زمانبرتر است.

یکی از مهمترین چالشها در این مسیر مسئلهی سوگیری یا بایاس دادههاست. الگوریتمها در واقع بازتاب دادههایی هستند که با آنها آموزش دیدهاند. اگر این دادهها یکطرفه یا محدود باشند، خروجی هم تبعیضآمیز خواهد شد. نمونهی شناختهشده آن سامانههای تشخیص چهره است که وقتی بیشتر بر پایهی تصاویر سفیدپوستان آموزش میبینند، در شناسایی افراد با رنگ پوست تیره خطاهای بیشتری دارند. یا موتور جستوجویی که فقط با متون رسمی تمرین کرده باشد، در برخورد با زبان محاوره یا اصطلاحات خیابانی دچار سردرگمی میشود.

بنابراین تنوع دادهها به اندازهی حجم آنها اهمیت دارد. مدلی که با دادههای متنوع آموزش ببیند، میتواند در موقعیتهای مختلف دنیای واقعی نیز درست عمل کند. برای مثال، اگر یک خودرو خودران فقط در هوای آفتابی آموزش دیده باشد، طبیعی است که در روزهای بارانی یا برفی عملکرد ضعیفی داشته باشد.

در نهایت، کمیت همچنان اهمیت دارد، اما به تنهایی کافی نیست. ترکیب حجم زیاد با کیفیت بالا و تنوع واقعی، همان چیزی است که دادهها را به سوختی سالم و مؤثر برای موتور هوش مصنوعی تبدیل میکند.

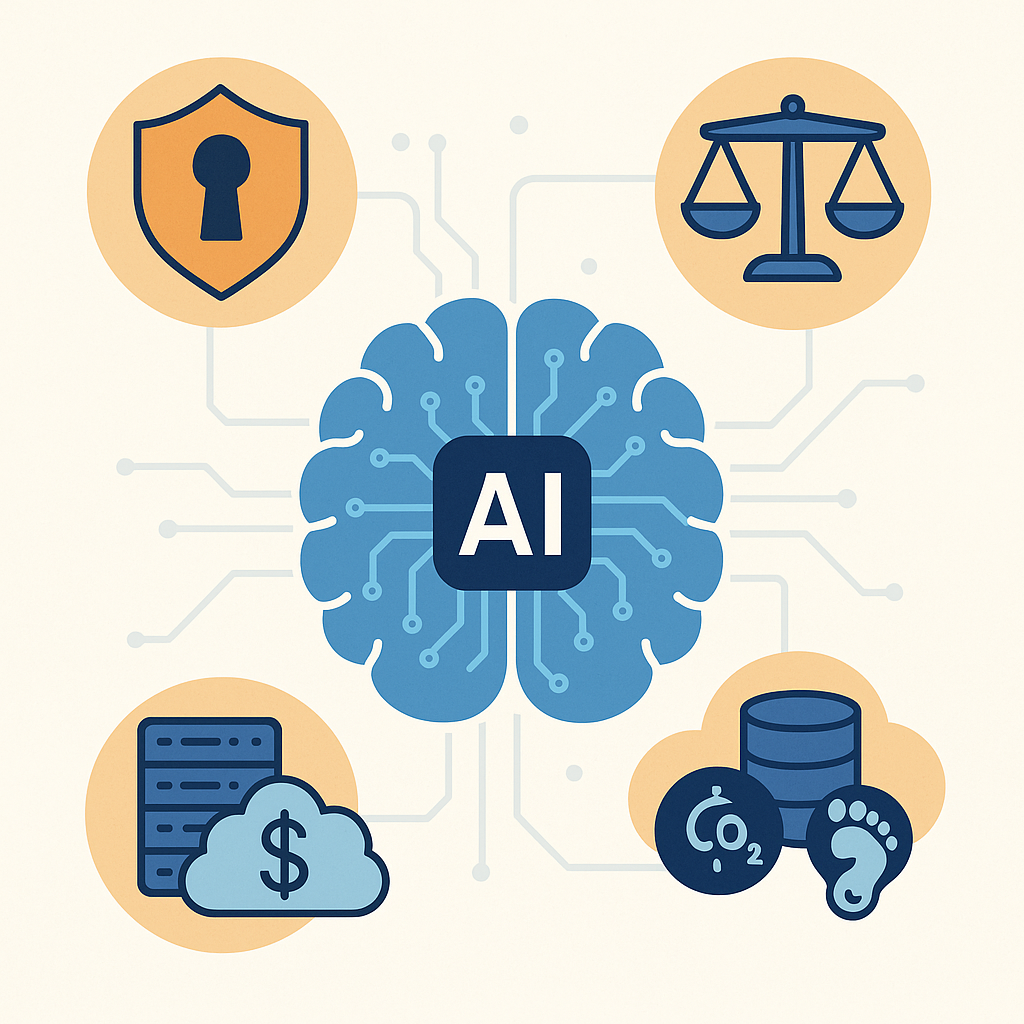

وقتی از دادهها به عنوان «سوخت» هوش مصنوعی یاد میشود، اغلب تصویری امیدوارکننده و مثبت به ذهن میآید: هرچه داده بیشتر، مدل قویتر و نتیجه دقیقتر. اما این نیمهی روشن ماجراست. واقعیت این است که همین سوخت میتواند خطرناک هم باشد و اگر مدیریت نشود، پیامدهای سنگینی به دنبال خواهد داشت. هرچه دادهها حجیمتر و حساستر میشوند، چالشهای استفاده از آنها هم چند برابر میگردد.

یکی از مهمترین مسائل، موضوع حریم خصوصی و امنیت است. بسیاری از دادههایی که امروزه برای آموزش مدلها استفاده میشوند، در اصل دادههای شخصی افرادند: از تاریخچهی جستوجوی اینترنتی و پیامهای خصوصی در اپلیکیشنها گرفته تا اطلاعات پزشکی و مالی. کافی است چنین دادههایی نشت پیدا کنند یا به دست هکرها بیفتند تا زندگی میلیونها نفر دستخوش آسیب شود. ماجرای افشای اطلاعات کاربران شبکههای اجتماعی و سوءاستفاده از آنها برای تبلیغات هدفمند یا حتی کمپینهای سیاسی نمونهای روشن از این خطر است. برای مقابله با این تهدیدها، مقرراتی مانند GDPR در اروپا یا قوانین مشابه در دیگر کشورها وضع شدهاند تا استفاده از دادهها شفافتر، کنترلشدهتر و مبتنی بر رضایت کاربران باشد. با این حال، اجرای این قوانین همیشه آسان نیست و همچنان شاهد نقض حریم خصوصی در مقیاس وسیع هستیم.

چالش دیگری که کمتر فنی و بیشتر اخلاقی و حقوقی است، به مسئلهی مالکیت دادهها برمیگردد. پرسش ساده اما بنیادین این است: دادهها به چه کسی تعلق دارند؟ آیا فردی که آنها را تولید کرده مالک اصلی است، یا شرکتی که آنها را جمعآوری و ذخیره کرده؟ این بحث بهویژه در حوزهی محتوای خلاقانه پررنگتر شده است. بسیاری از هنرمندان و نویسندگان اعتراض کردهاند که آثارشان بدون اجازه برای آموزش مدلهای تولیدکنندهی متن و تصویر به کار رفته است. از نگاه آنها، این نوع استفاده شکلی از بهرهبرداری بدون جبران عادلانه است. در مقابل، شرکتهای هوش مصنوعی معمولاً استدلال میکنند که دادهها از فضای عمومی اینترنت جمعآوری شده و قابل استفاده برای همهاند. این تضاد دیدگاهها به بحثهای داغی دربارهی اخلاق، حقوق مالکیت فکری و ضرورت وضع قوانین جدید منجر شده است.

سومین مانع بزرگ در مسیر دادهها مربوط به هزینهها و زیرساخت است. دادههای بزرگ فقط مشکل حقوقی یا اخلاقی ندارند، بلکه بار مالی و فنی سنگینی هم به همراه میآورند. ذخیرهسازی فایلهای عظیمی مثل ویدئوها یا تصاویر باکیفیت، نیازمند فضا و تجهیزات گسترده است. حتی وقتی دادهها ذخیره شدند، تازه مرحلهی پردازش آغاز میشود. تحلیل دادههای عظیم به قدرت محاسباتی بالا احتیاج دارد؛ از پردازندههای گرافیکی پیشرفته گرفته تا خوشههای بزرگ سرورهای ابری. این زیرساختها ارزان نیستند و اغلب تنها در اختیار شرکتهای بزرگ فناوری قرار دارند.

فراتر از هزینهی مالی، یک هزینهی زیستمحیطی هم مطرح است. مراکز داده که قلب تپندهی هوش مصنوعی محسوب میشوند، انرژی بسیار زیادی مصرف میکنند. این مصرف بالا نهتنها قبضهای نجومی برق تولید میکند، بلکه به افزایش انتشار کربن و فشار بر محیط زیست هم منجر میشود. در دورانی که بحران تغییرات اقلیمی به دغدغهی جهانی تبدیل شده، نمیتوان از این بُعد ماجرا چشمپوشی کرد. هوش مصنوعی از یک سو نوید پیشرفت میدهد، اما از سوی دیگر ردپای کربنی آن میتواند مانعی جدی برای پایداری محیطی باشد.

در مجموع، روشن است که دادهها صرفاً فرصت نیستند. در کنار تمام توانمندیهایی که فراهم میکنند، مجموعهای از مسئولیتها و چالشها را نیز با خود میآورند. هوش مصنوعی بدون داده نمیتواند رشد کند، اما رشد بیحساب و کتاب هم به همان اندازه خطرناک است. از یک طرف باید به امنیت و حریم خصوصی کاربران احترام گذاشت؛ از طرف دیگر حقوق تولیدکنندگان داده و محتوای خلاقانه باید رعایت شود. در کنار اینها، بار مالی و زیستمحیطی مدیریت دادهها نیز باید در نظر گرفته شود.

بنابراین آیندهی هوش مصنوعی نه فقط به پیشرفت الگوریتمها، بلکه به توانایی ما در مدیریت هوشمندانهی دادهها گره خورده است. تنها با ایجاد توازن میان استفادهی گسترده و مسئولانه، میتوان اطمینان داشت که دادهها واقعاً به ابزاری برای پیشرفت تبدیل میشوند و نه تهدیدی برای افراد، جوامع و حتی سیارهای که بر آن زندگی میکنیم.

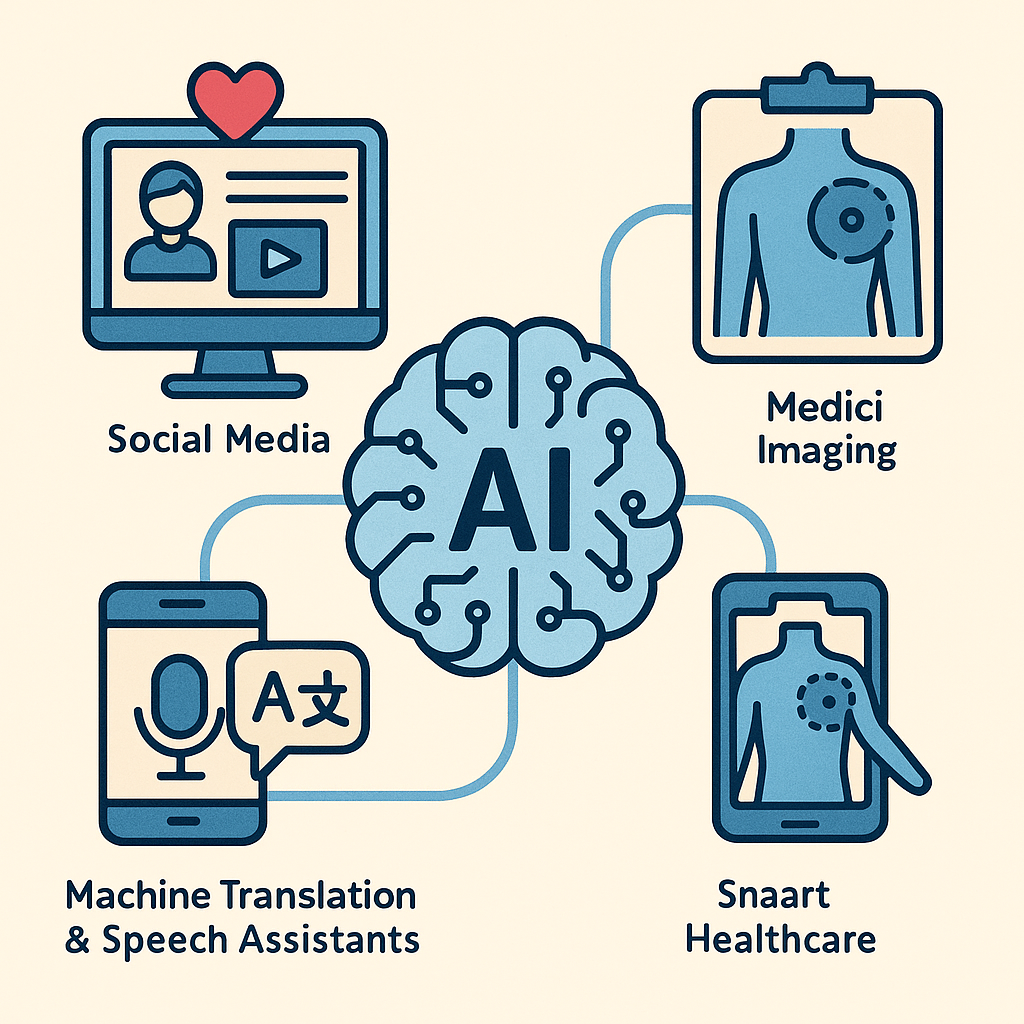

برای درک نقش واقعی دادهها کافی است به چند حوزهی مهم نگاه کنیم؛ جاهایی که بدون داده، هیچ الگوریتمی نمیتواند به نتیجهای قابلاعتماد برسد.

یکی از نمونههای آشنا شبکههای اجتماعی هستند. محتوایی که در صفحهی شما ظاهر میشود، انتخابی تصادفی نیست. هر لایک، هر کلیک و هر لحظهای که روی یک ویدئو یا عکس مکث میکنید، بخشی از انبوهی از دادههای رفتاری است که سیستمها جمعآوری میکنند. این دادهها، که بیشترشان بدون ساختار هستند، به الگوریتمها کمک میکنند تا سلیقه و الگوی تعامل شما را بفهمند و در نهایت پستها یا تبلیغاتی را پیشنهاد کنند که بیشترین شانس جلب توجه شما را دارند.

در حوزهی سلامت، اهمیت دادهها شاید حتی بیشتر به چشم بیاید. سیستمهای تشخیص بیماری بر پایهی میلیونها تصویر پزشکی مثل MRI و CT Scan آموزش میبینند. این تصاویر پیش از ورود به مدلها، توسط پزشکان برچسبگذاری میشوند؛ مثلاً مشخص میشود کدام تصویر وجود یک تومور را نشان میدهد و کدام مربوط به بافت سالم است. وقتی این دادههای برچسبخورده وارد الگوریتمهای یادگیری عمیق میشوند، مدل میتواند الگوهایی را در تصاویر تشخیص دهد که حتی برای چشم انسان نامحسوساند. نتیجهی چنین فرایندی، تشخیص زودهنگام بیماریها، دقت بالاتر و تصمیمگیری آگاهانهتر پزشکان است.

نمونهی دیگر را میتوان در ترجمه ماشینی و دستیارهای صوتی دید. وقتی متنی را در یک مترجم آنلاین وارد میکنید یا با دستیار صوتی گوشیتان حرف میزنید، در واقع الگوریتمهایی در پسزمینه فعالاند که با استفاده از دادههای میلیاردها کاربر آموزش دیدهاند. مترجمهای ماشینی از انبوه جملات موازی، یعنی متونی که به زبانهای مختلف ترجمه شدهاند، یاد میگیرند. دستیارهای صوتی هم با شنیدن میلیونها ساعت گفتار انسان، به تدریج توانستهاند زبان طبیعی، لهجههای متنوع و حتی الگوهای گفتاری متفاوت را بهتر درک کنند.

این مثالها نشان میدهند که داده صرفاً بخشی تئوریک از یک الگوریتم نیست. داده همان چیزی است که موتور هوش مصنوعی را روشن نگه میدارد و تحولات بزرگی را رقم میزند که ما در زندگی روزمره لمسشان میکنیم؛ از شبکههای اجتماعی گرفته تا پزشکی و از ترجمه زبانها تا تعامل طبیعی با ماشینها.

وقتی به تاریخچه و وضعیت کنونی هوش مصنوعی نگاه میکنیم، یک حقیقت واضح میشود: هیچ پیشرفتی بدون داده ممکن نبود. الگوریتمها هرچقدر هم پیچیده و پیشرفته باشند، بدون داده مانند موتور خاموشی هستند که سوختی در اختیار ندارد. دادهها همان شالودهای هستند که کل بنای هوش مصنوعی بر آن استوار شده است.

در این مسیر دیدیم که دادهها در قالبهای مختلف—از ساختیافته و جدولی گرفته تا نیمهساختیافته و نهایتاً بدون ساختار—به کار میروند. هر یک از این انواع، چالشها و ارزشهای خاص خود را دارند. دادههای ساختیافته نظم و قابلیت پردازش سادهتری دارند، اما در برابر واقعیت پیچیدهی جهان کافی نیستند. دادههای نیمهساختیافته پلی میان نظم و بینظمی هستند. و نهایتاً دادههای بدون ساختار—که سهم عمدهی دنیای دیجیتال امروز را تشکیل میدهند—میدان اصلی رشد یادگیری عمیق و الگوریتمهای مدرن بودهاند.

در کنار کمیت عظیم دادهها، کیفیت و تنوع اهمیت کلیدی دارد. دادههای ناقص یا سوگیرانه نهتنها کمکی به پیشرفت مدلها نمیکنند، بلکه میتوانند به تولید خروجیهای ناعادلانه و گمراهکننده منجر شوند. به همین دلیل چرخهی دادهها شامل مراحل دقیق و زمانبر از جمعآوری، پاکسازی، برچسبگذاری، ذخیرهسازی و نهایتاً بهروزرسانی مداوم است. این چرخه همان کارخانهای است که دادهی خام را به مادهی ارزشمند و قابل مصرف برای الگوریتمها تبدیل میکند.

در نهایت نباید فراموش کرد که دادهها تنها منبع قدرت نیستند، بلکه مسئولیتهایی سنگین هم به همراه دارند. حفاظت از حریم خصوصی افراد، تعیین مرزهای مالکیت دادهها، و مدیریت هزینهها و زیرساختها از جمله چالشهایی هستند که همزمان با فرصتهای ناشی از دادهها پدیدار شدهاند.

به بیان ساده، اگر بخواهیم هوش مصنوعی را یک موجود زنده تصور کنیم، دادهها همان خونی هستند که در رگهای آن جریان دارد. بدون داده، هوش مصنوعی معنایی ندارد؛ و با دادهی درست، سالم و متنوع، این فناوری میتواند به ابزاری قدرتمند برای بهبود زندگی بشر تبدیل شود.

کتابها:

Artificial Intelligence: A Modern Approach – نوشتهی Stuart Russell و Peter Norvig. (یکی از جامعترین منابع برای درک مفاهیم بنیادی دادهها، الگوریتمها و سختافزار در هوش مصنوعی.)

Deep Learning – نوشتهی Ian Goodfellow، Yoshua Bengio و Aaron Courville. (منبع کلاسیک برای فهم الگوریتمهای یادگیری عمیق و نیازهای محاسباتی آنها.)

Machine Learning Yearning – نوشتهی Andrew Ng. (کتاب مختصر و کاربردی دربارهی نحوهی نگاه سیستمی به دادهها و الگوریتمها.)

مقالات و وبسایتها:

مقالات و وبلاگهای رسمی Google AI و DeepMind (برای مطالعهی پیشرفتهای اخیر در الگوریتمها و سختافزار).

GeeksforGeeks – Machine Learning Algorithms (مرجع دستهبندی و توضیح ساده الگوریتمها).

NVIDIA Developer Blog (منبع عالی برای فهم کاربرد GPUها در آموزش مدلهای هوش مصنوعی).

Google Cloud TPU documentation (برای آشنایی عملی با TPUها و کاربردشان در یادگیری عمیق).

منابع عمومیتر برای علاقهمندان:

دورههای آنلاین Coursera – Machine Learning (Andrew Ng) و Deep Learning Specialization.

مقالات وبسایت Towards Data Science در مدیوم (مناسب برای ترکیبی از نگاه عمومی و تخصصی).

نشریه فرامتن رو در پلتفرمهای مختلف دنبال کنید :)