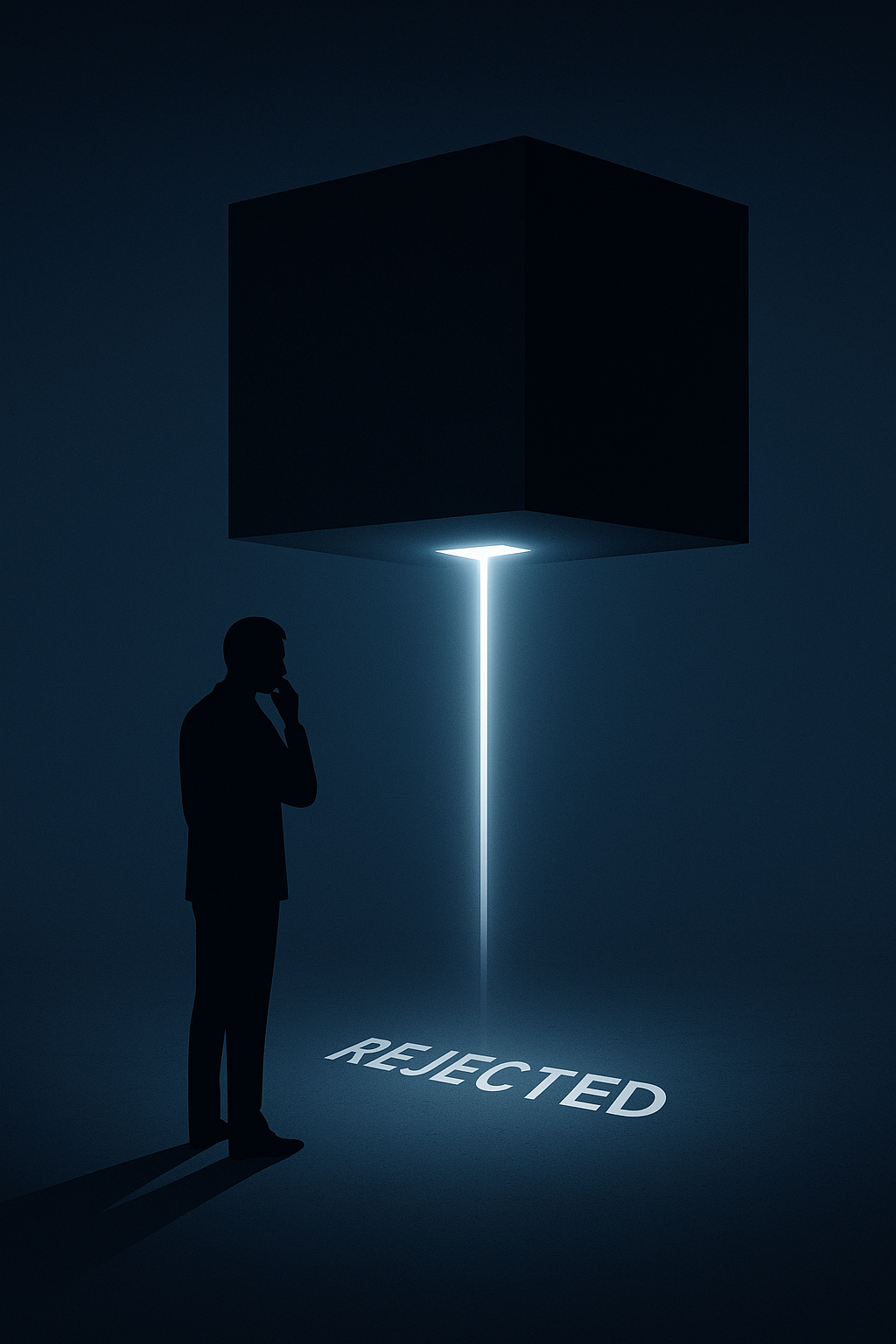

تصور کنید درخواست شما برای یک وام بانکی حیاتی، نه توسط یک انسان، بلکه توسط یک سیستم اعتبارسنجی هوشمند رد میشود. وقتی دلیل را جویا میشوید، تنها پاسخی که دریافت میکنید این است: «الگوریتم اینطور تشخیص داده است». هیچ توضیح دیگری وجود ندارد. هیچ منطق قابل فهمی ارائه نمیشود. شما با یک تصمیم سرنوشتساز روبرو هستید که از دل یک «جعبه سیاه» بیرون آمده و هیچ انسانی قادر به توضیح چرایی آن نیست. این سناریو، که روزبهروز در حال تبدیل شدن به یک واقعیت فراگیر است، نظام حقوقی را با یکی از عمیقترین چالشهای خود مواجه میکند: آیا میتوان به تصمیمی استناد کرد که هیچ انسانی نتواند منطق آن را بفهمد؟ و آیا مشروعیت تصمیمات الگوریتمی در حقوق، بدون شفافیت، امکانپذیر است؟

در دنیای فناوری، «جعبه سیاه هوش مصنوعی» (AI's Black Box) به الگوریتمهایی اطلاق میشود که فرآیند تصمیمگیری درونی آنها به قدری پیچیده است که حتی برای طراحان و توسعهدهندگانشان نیز به طور کامل قابل ردیابی و توضیح نیست. الگوریتمهای سنتی مانند یک «جعبه شیشهای» بودند؛ میشد منطق و قواعد (اگر-آنگاه) حاکم بر آنها را به وضوح دید. اما مدلهای یادگیری عمیق (Deep Learning) که امروزه قدرت بسیاری از سیستمهای هوشمند را تأمین میکنند، با تحلیل میلیونها داده، خودشان الگوها و ارتباطات درونی را کشف میکنند. این فرآیند خودآموز، به نتایج شگفتانگیزی منجر میشود، اما اغلب به قیمت از دست رفتن «شفافیت».

در واکنش به این چالش، یک مفهوم حقوقی نوین در حال شکلگیری است: «حق بر توضیح». این حق، که ریشههای آن در مقررات حفاظت از داده اتحادیه اروپا (GDPR) و به طور صریحتر در «قانون هوش مصنوعی» (AI Act) همین اتحادیه دیده میشود، بیان میکند که شهروندان باید بتوانند توضیحی معنادار در مورد منطق حاکم بر تصمیمات خودکاری که به طور قابل توجهی بر زندگی آنها تأثیر میگذارد، دریافت کنند. این دیدگاه، شفافیت را از یک مزیت فنی به یک الزام حقوقی تبدیل میکند.

در مقابل، نظام حقوقی ایران فاقد چنین مفهومی به صورت مشخص و مدون است. اگرچه اصولی مانند «حق دفاع» یا «ضرورت مستدل بودن آرای قضایی» وجود دارد، اما این اصول برای دنیای الگوریتمی طراحی نشدهاند و سکوت قانونگذار در این حوزه، یک خلأ جدی برای حمایت از حقوق شهروندان در برابر تصمیمات الگوریتمی در حقوق ایجاد کرده است.

عدم شفافیت، پیامدهای حقوقی ویرانگری به همراه دارد:

فلج شدن مسئولیت مدنی و کیفری: همانطور که در تحلیل مسئولیت قانونی هوش مصنوعی دیدیم، اثبات «رابطه سببیت» یکی از ارکان اصلی تحقق مسئولیت است. وقتی نتوان فهمید که چرا یک الگوریتم تصمیم اشتباهی گرفته، اثبات این رابطه و در نتیجه، احقاق حق زیاندیده تقریباً غیرممکن میشود.

نقض حقوق بنیادین دادرسی: در یک فرآیند کیفری، حق متهم برای دانستن دلایل اتهام و به چالش کشیدن آنها، یک اصل مسلم است. اگر بخشی از تصمیم یک قاضی بر پایه تحلیل یک الگوریتم جعبه سیاه باشد، حق دفاع متهم به طور جدی تضعیف میشود.

عدم امکان اعتراض مؤثر: چگونه میتوان به تصمیمی اعتراض کرد که دلایل آن را نمیدانیم؟ حق اعتراض، بدون دسترسی به منطق تصمیم، به یک حق توخالی و بیاثر تبدیل میشود.

الزام قانونگذار به شفافیت الگوریتمی (Explainable AI - XAI) یک شمشیر دولبه است.

مزایا: الزام به شفافیت، حقوق شهروندی را تقویت میکند، اعتماد عمومی به فناوری را افزایش میدهد، و زمینه را برای پاسخگویی و جبران خسارت فراهم میسازد.

معایب: منتقدان معتقدند که چنین الزامی میتواند نوآوری را کند کرده و شرکتهای فناوری را از توسعه مدلهای پیچیدهتر و دقیقتر بازدارد. گاهی میان «دقت» یک الگوریتم و «قابلیت توضیح» آن، یک توازن معکوس وجود دارد؛ یعنی دقیقترین مدلها، همانهایی هستند که توضیحشان دشوارتر است. همچنین، شفافیت کامل میتواند به افشای اسرار تجاری شرکتهای توسعهدهنده منجر شود.

سکوت قانونگذار ایرانی در این حوزه نمیتواند برای همیشه ادامه یابد. برای مواجهه با این چالش، برداشتن گامهای زیر ضروری است:

تصویب مقررات خاص در حوزه Explainable AI: قانونگذار باید با الهام از تجربیات جهانی، به ویژه AI Act اروپا، مقرراتی را برای سیستمهای هوش مصنوعی پرریسک (مانند کاربردهای قضایی، مالی و استخدامی) تدوین کند که حداقلهایی از شفافیت را الزامی نماید.

گنجاندن «حق بر توضیح» در حقوق شهروندی دیجیتال: این حق باید به عنوان یکی از حقوق بنیادین شهروندان در عصر دیجیتال به رسمیت شناخته شود.

ایجاد نهادهای نظارتی مستقل: لازم است نهادهایی فنی و حقوقی برای بازبینی و حسابرسی مدلهای هوش مصنوعی که در بخشهای حساس عمومی و خصوصی به کار گرفته میشوند، ایجاد گردد.

در نهایت، باید پذیرفت که در عصر هوش مصنوعی، مشروعیت با کارایی برابر نیست. یک تصمیم، هرچقدر هم که سریع و دقیق باشد، اگر قابل فهم و قابل نقد نباشد، فاقد مشروعیت حقوقی و اخلاقی است. چالش «جعبه سیاه هوش مصنوعی» به ما یادآوری میکند که آینده حقوق، نه در تسلیم شدن به پیچیدگیهای فنی، که در تلاش برای انطباق اصول بنیادین عدالت با واقعیتهای جدید نهفته است. مشروعیت تصمیمات خودکار، به «قابلیت توضیح و پاسخگویی» آنها گره خورده و نظامهای حقوقی سنتی، از جمله ایران، باید هرچه سریعتر خود را برای این واقعیت جدید و اجتنابناپذیر آماده کنند.