رگولاتوری AI یا قانونگذاری هوش مصنوعی، تلاشی است برای ایجاد چارچوبهای حقوقی، اخلاقی و نظارتی جهت مدیریت توسعه و استفاده از سیستمهای هوشمند. این تلاش، نه به قصد محدود کردن نوآوری، بلکه با هدف اعتمادسازی، تضمین ایمنی و جلوگیری از آسیبهای احتمالی صورت میگیرد. با فراگیر شدن ابزارهای هوش مصنوعی، دغدغههای جهانی مشترکی پدید آمده است: چگونه میتوان از تبعیض الگوریتمی جلوگیری کرد؟ چه کسی مسئول خسارات ناشی از یک تصمیم اشتباه AI است؟ و چگونه میتوان شفافیت و پاسخگویی را در سیستمهای پیچیده تضمین نمود؟ پاسخ به این پرسشها، کشورها را به سمت اتخاذ رویکردهای متفاوتی برای سیاستگذاری فناوری سوق داده است.

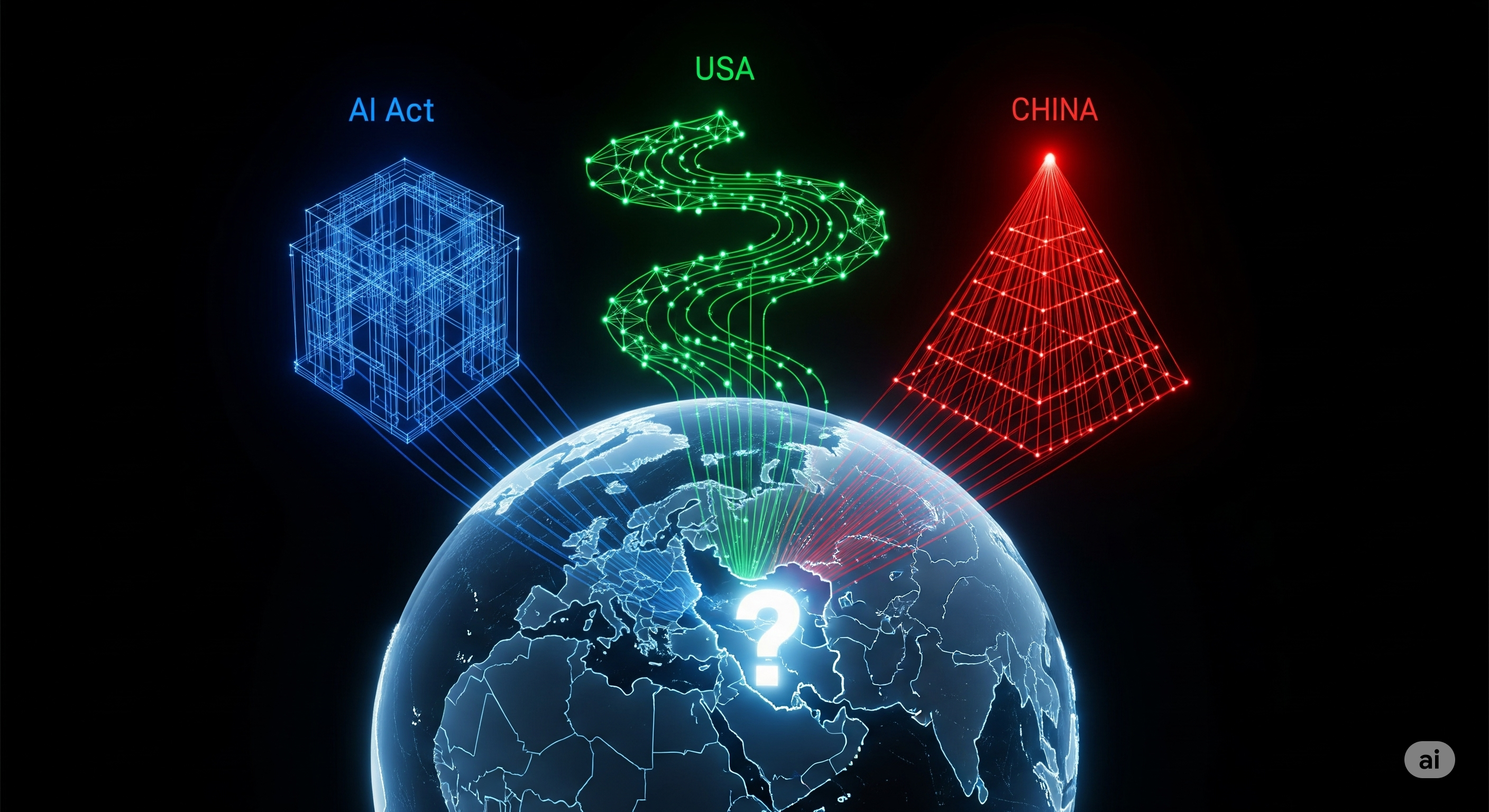

در حال حاضر سه مدل اصلی برای رگولاتوری AI در جهان در حال شکلگیری است که هر کدام بازتابی از ارزشهای اقتصادی، اجتماعی و سیاسی مناطق خود هستند.

اتحادیه اروپا با ارائه «قانون هوش مصنوعی» (AI Act اتحادیه اروپا) پیشگامترین و جامعترین رویکرد را اتخاذ کرده است. سنگ بنای این قانون، «طبقهبندی ریسک» (Risk-Based Approach) است. در این مدل، سیستمهای هوش مصنوعی به چهار دسته تقسیم میشوند:

ریسک غیرقابل قبول (Unacceptable Risk): سیستمهایی که تهدیدی آشکار برای حقوق بنیادین انسانها هستند (مانند سیستمهای امتیازدهی اجتماعی دولتی) به طور کامل ممنوع میشوند.

ریسک بالا (High-Risk): سیستمهای مورد استفاده در حوزههای حساس مانند استخدام، اعتبارسنجی بانکی، اجرای قانون و دادرسی، تحت الزامات سختگیرانهای در خصوص شفافیت، نظارت انسانی، امنیت و کیفیت داده قرار میگیرند.

ریسک محدود (Limited Risk): سیستمهایی مانند چتباتها باید به طور شفاف به کاربر اطلاع دهند که در حال تعامل با یک ماشین است.

ریسک حداقلی (Minimal Risk): اکثر سیستمهای هوش مصنوعی (مانند بازیها یا فیلترهای اسپم) در این دسته قرار گرفته و قوانین خاصی بر آنها حاکم نیست.

ایالات متحده، با اولویت دادن به نوآوری و رقابت، رویکردی غیرالزامآور و مبتنی بر اصول اخلاقی را در پیش گرفته است. به جای یک قانون جامع، نهادهایی مانند مؤسسه ملی استاندارد و فناوری (NIST)، چارچوبهای مدیریت ریسک داوطلبانهای را منتشر کردهاند که به شرکتها در توسعه مسئولانه AI کمک میکند. تمرکز اصلی بر مسئولیتپذیری شرکتی و قوانین بخشی (Sector-Specific) است تا یک قانونگذاری فراگیر.

سیاستگذاری فناوری در چین، اهدافی دوگانه را دنبال میکند: تبدیل شدن به قدرت اول جهانی در زمینه هوش مصنوعی تا سال ۲۰۳۰، و در عین حال، حفظ کنترل کامل دولت بر فضای دیجیتال. قوانین چین بیشتر بر نظارت بر رفتار پلتفرمهای بزرگ، کنترل الگوریتمهای توصیهگر محتوا، و تضمین همراستایی توسعه AI با ارزشهای سوسیالیستی تمرکز دارد.

در کنار این سه مدل اصلی، کشورهایی مانند انگلستان، کانادا و برزیل نیز در حال تدوین چارچوبهای ملی خود هستند که اغلب ترکیبی از رویکردهای فوق است.

در میانه این تحولات جهانی، وضعیت ایران و هوش مصنوعی با ابهامات و چالشهای جدی روبروست.

پاسخ کوتاه، «خیر» است. در حال حاضر، هیچ قانون مشخص و مستقیمی برای قانونگذاری هوش مصنوعی در ایران وجود ندارد. اگرچه میتوان برخی از قوانین موجود را با تفسیری موسع به این حوزه تسری داد:

قانون جرایم رایانهای: این قانون به سوءاستفاده از سامانههای رایانهای میپردازد، اما ظرفیت لازم برای مواجهه با چالشهای نوینی مانند تبعیض الگوریتمی یا مسئولیت ناشی از خطای AI را ندارد.

قوانین حریم خصوصی: قوانین پراکندهای در این حوزه وجود دارد، اما هیچکدام برای حفاظت از دادهها در مقیاس کلان (Big Data) که خوراک اصلی سیستمهای هوشمند است، طراحی نشدهاند.

قانون حمایت از حقوق مؤلفان: همانطور که پیشتر بحث شد، این قانون در برابر آثار خلقشده توسط AI سکوت کرده است.

وضعیت فعلی ایران و هوش مصنوعی با سه چالش بنیادین مشخص میشود:

نبود نهاد متولی مشخص: برخلاف سایر کشورها، هنوز یک نهاد واحد و مشخص به عنوان رگولاتور اصلی هوش مصنوعی در ایران تعیین نشده است. نهادهایی مانند مرکز ملی فضای مجازی، وزارت ارتباطات و معاونت علمی ریاست جمهوری هرکدام به صورت پراکنده فعالیتهایی دارند، اما یک سیاستگذاری منسجم و یکپارچه وجود ندارد.

کمبود زیرساختها و سرمایه انسانی: توسعه و نظارت بر AI نیازمند زیرساختهای دادهای قوی و نیروی انسانی متخصص در حوزههای فنی و حقوقی است که در هر دو زمینه با کمبود مواجه هستیم.

غیبت در گفتوگوهای بینالمللی: عدم حضور فعال ایران در فرآیندهای جهانی تدوین استانداردها و قوانین، میتواند منجر به انزوای فناورانه و عدم انطباق با مقررات بینالمللی در آینده شود.

برای خروج از وضعیت سکون فعلی و حرکت به سمت یک سیاستگذاری فناوری مسئولانه، برداشتن گامهای زیر ضروری است:

تشکیل کارگروه ملی رگولاتوری AI: اولین قدم، ایجاد یک کارگروه بیننهادی با حضور نمایندگان قوه قضائیه، مرکز ملی فضای مجازی، وزارت ارتباطات، وزارت صمت، دانشگاههای برتر و بخش خصوصی است تا نقشه راه ملی رگولاتوری AI را تدوین کند.

الگوبرداری هوشمندانه از مدل طبقهبندی ریسک: به جای کپیبرداری مستقیم از AI Act اتحادیه اروپا، میتوان از «فلسفه» آن یعنی طبقهبندی ریسک، الگوبرداری کرد. باید مشخص شود که کدام کاربردهای هوش مصنوعی در ایران «پرخطر» محسوب شده و نیازمند نظارت سختگیرانهتر هستند.

توجه به اقتضائات بومی: قانونگذاری باید با در نظر گرفتن چالشهای بومی ایران صورت گیرد. مسائلی مانند نحوه حفاظت از حریم خصوصی در پلتفرمهای داخلی، مقابله با سوگیری داده در دادههای فارسی، و تدوین چارچوبهای اخلاقی برای استفاده از AI در نظام سلامت، باید در اولویت قرار گیرند.

تدوین سند ملی اخلاق هوش مصنوعی: پیش از تدوین قوانین الزامآور، میتوان با تدوین یک سند ملی اخلاقی، چارچوبهای کلی و اصول راهنما را برای توسعهدهندگان و کاربران دولتی و خصوصی مشخص نمود.

در نهایت، رویکرد ایران به قانونگذاری هوش مصنوعی نباید صرفاً واکنشی و بازدارنده باشد، بلکه باید فعالانه، آیندهنگر و زمینهساز یک نوآوری مسئولانه باشد.