آن که پرنقش زد این دایره مینایی کس ندانست که در گردش پرگار چه کرد (حافظ)

لوئیس فرای ریچاردسون (Lewis Fry Richardson) در نیمه ی قرن بیستم به مطالعه ی طول خط ساحلی کشور ها مشغول شد. او در حال بررسی این بود که آیا میتوان احتمال درگیری بین کشورها را بر اساس طول مرز مشترکشان پیشبینی کرد یا نه. اما در این مسیر متوجه پدیدهای عجیب شد: منابع مختلف، طول بسیار متفاوتی برای یک مرز یا خط ساحلی یکسان گزارش میکردند. بهویژه برای کشورهایی مانند بریتانیا.

مثلاً یک منبع میگفت طول خط ساحلی بریتانیا حدود ۲۴۰۰ کیلومتر است، دیگری ۳۴۰۰ کیلومتر و حتی منابعی بودند که ۱۲۰۰۰ کیلومتر گزارش میدادند! چرا اینهمه تفاوت؟

واقعیت این است که طول خط ساحلی به مقیاس اندازهگیری بستگی دارد! اگر با خطکشی به طول ۱۰۰ کیلومتر اندازه بگیرید، از بسیاری از خلیجها، بریدگیها و پیچوخمهای کوچک عبور میکنید. اما اگر خطکش شما فقط ۱ کیلومتر باشد، جزئیات بیشتری را ثبت میکنید. و اگر به اندازه ۱ متر یا حتی کوچکتر برسید، حتی فرورفتگیهای کوچک، سنگریزهها و دانههای شن را هم لحاظ خواهید کرد. هرچه واحد اندازهگیری کوچکتر باشد، طول خط ساحلی بیشتر میشود.

این مشاهدۀ عجیب همان پارادوکس خط ساحلی است:

طول اندازهگیریشدهی یک خط ساحلی، هرچه مقیاس اندازهگیری کوچکتر شود، بدون حد افزایش مییابد.

این وضعیت معنای «طول» به صورت کلاسیک آن را بی استفاده می کند! پس باید چه کرد؟

این پارادوکس توجه بنوآ مندلبرو (Benoit Mandelbrot) ، ریاضیدان فرانسوی را جلب کرد. او در سال ۱۹۶۷ مقالهای معروف با عنوان «خط ساحلی بریتانیا چقدر طول دارد؟ خودشباهتی آماری و بُعد کسری» منتشر کرد. اون دریافت که اشکال طبیعی مانند خط ساحلی، طول دقیقی در معنای کلاسیک ندارند. این اشکال دارای خودشباهتی هستند؛ یعنی الگوهای مشابهی در مقیاسهای مختلف ظاهر میشوند. مندلبرو مفهوم بُعد فرکتالی را برای اندازهگیری این پیچیدگی معرفی کرد.

برای یک خط صاف (یک بعدی)، بُعد آن برابر با ۱ است.

برای یک صفحه (دو بعدی)، بُعد آن ۲ است.

اما بعد خط ساحلی بریتانیا بین خط و صفحه است!! مقدار اندازه گیری شده ۱.۳۳ است. اما یافتن بعد فقط محدود به چنین موجودیت های جغرافیایی نمی شود. هر چیزی اطراف ما یک بعد دارد حتی زبان!

اکنون، بیایید فراتر رویم. «بعد»، میتواند از دیدگاهی عمومی تر هم دیده شود. بگذارید آن را در دل پویایی ببینیم: در ماشینهایی که نه تنها میاندیشند، بلکه انتخاب میکنند.

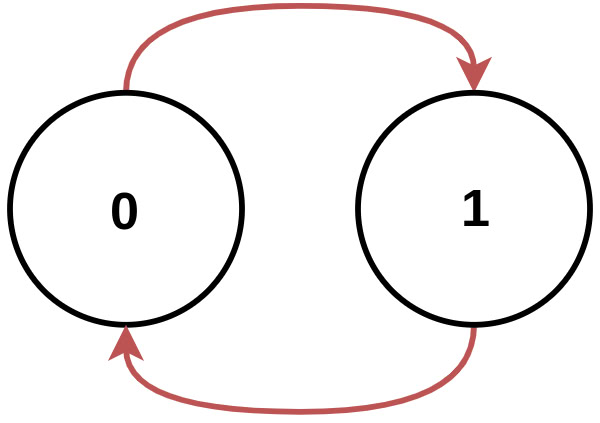

فرض کنید جهانی را داریم که در آن هر لحظه، آینده ی دقیقاً مشخص دارد؛ آیندهای که با بیرحمی ریاضی تعیین شده است. در چنین جهانی، شما آزادی ندارید. تنها یک مسیر است که باید آن را پیمود. این همان دنیای ماشینهای متعین (deterministic automata) است، اتوماتهایی که بدون تردید و بدون رؤیا، از یک وضعیت به وضعیت بعدی میخزند. شما قفل شدهاید. در اسارت علیت. شکل زیر یک مثال از چنین حالتی است:

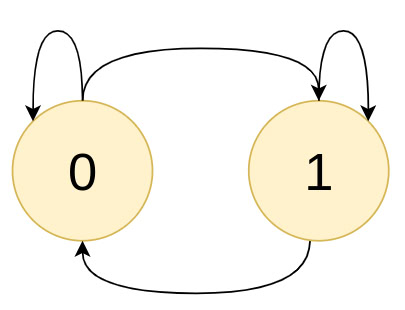

اما در جهانی دیگر، در ساختاری دیگر از ماشینها، «آزادی» (انتخاب آزاد) از تارهای علیت سر برمیکشد. در اینجا، در هر نقطه میتوانید بایستید یا حرکت کنید، انتخاب کنید یا نکنید. این همان آزادی است: جایی که امکان معنا مییابد. ساده ترین مثال آن شکل زیر است: در اینجا زبان ما فقط دو نماد ۰ و ۱ دارد و دو حالت برای حرکت بین آن ها:

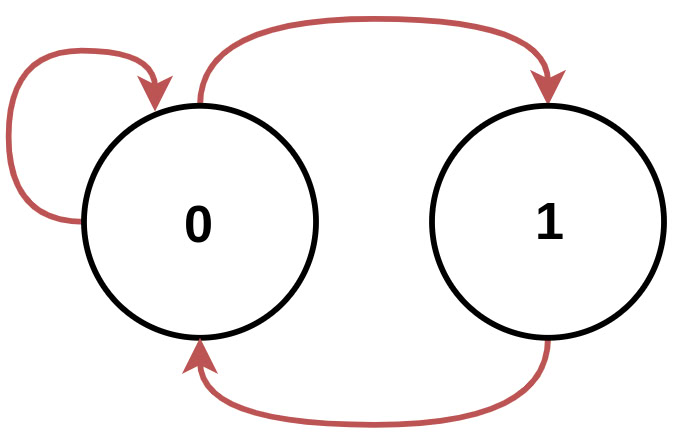

و آنگاه، نوعی میانجی، میان این دو جهان میزاید: اتوماتای جابجایی با نسبت طلایی.(golden mean shift automata) نه کاملاً آزاد، نه کاملاً مقید. گاه انتخاب دارید، گاه ندارید. چیزی شبیه به ساحت وجود ما، در مرز میان تقدیر و اراده. در شکل زیر ساده ترین نمونه ی اتوماتای طلایی را می بنید (که قبلا هم آن را بررسی کردیم)

اگر مسیرهای ممکن را بُعد بنامیم، پس ماشینهای متعین بُعدشان یک است: یک مسیر، یک انتخاب. اتومات دومی که بررسی کردیم بُعدش دو است: در آن هر حالت دو مسیر پیش روی شماست: در هر حالت هم می توانید در آنجا بمانید یا به حالت دیگر بروید. اما در اتوماتای نسبت طلایی، در یک حالت شما دو انتخاب دارید اما در حالت دیگر حرکت کاملا متعین است: «بُعد» (یا درجه ی انتخاب) در میان یک و دو است یک مقدار کسری یا به زبان دیگر فراکتالی. برای محاسبه «بعد» باید پرسید: در هر تغییر بر روی اتومات ها فضای حالت ها به چه نرخی رشد می کند! نرخ این رشد از قضا برابر با اولین مقدار ویژه (eigenvalue) ماتریس جابجایی اتومات (transition matrix) است.و این نرخ همان عدد طلاییست. ۱.۶۱۸۰. بنابراین بعد چنین ماشینی عدد طلایی است!

در حقیقت، آنچه ما «بُعد» مینامیم، چیزی نیست جز آنتروپی؛ میزان آزادی، میزان پیچیدگی یا نسبت تقدیر و اراده: نسبت آزادی و اسارت. و همانگونه که پیشتر گفتیم، آنتروپی صرفاً بینظمی نیست. آنتروپی، هندسهی آزادیست. نقشهی مرموزیست که نشان میدهد در کجا میتوان بود و در کجا نه.

زبان ماشینها نیز، زبان همین هندسه است. ما در نظریهی زبانها و اتوماتا، زبانهایی را تعریف می کنیم که اساس تمامی زبان های برنامه نویسی و ماشینی است. شما به یاد دارید که می توان ماشین هایی ساخت که زبان های ساده ای مانند (01)* یا تکرار 01 را ایجاد کنند ( regular expressions). در این نوع زبان ها احتمال رفتن از یک نماد به دیگری شکل های پیچیده تری را هم می سازند (زبان های حافظه دار و در نهایت ماشین تورینگ). در دسته ی زبان هایی که حرکت بین نماد های آن (در مثال بالا 0 , 1) احتمالاتی است ما با توالی های مختلفی مواجه هستیم که برخی از بقیه محتمل ترند. اگر حتی کلی تر به این موضوع نگاه کنید می توانید زبان های انسانی را هم توالی احتمالاتی از کلمات بدانید!

امروزه، مدلهایی در دل سیلیکون به نام ترنسفورمر (Transformers) ساختهایم که وقتی به آنها کلمهای داده میشود، میتوانند توزیع احتمال کلمهی بعدی را با دقتی شگرف پیشبینی کنند.در مدل های زبانی امروزی وقتی یک کلمه به عنوان ورودی داده می شود مدل با دقت بسیار بالایی توزیع احتمال کلمه ی بعدی را پیش بینی می کند. به این ترتیب می توانیم یک نمونه از توزیع کلمه ی بعدی برداریم و همینطور کلمات بعدی و بعدی را بسازیم تا جملات و پاراگراف های طولانی ایجاد کنیم.

اینجا هم یک فضا وجود دارد از کلماتی که پشت سر هم می آیند و برخی از دنباله ها قابل قبول هستند (مثلا «او به بازار رفت» ) و برخی غیر قابل قبول (مثلا «بازار او رفت» ) یا حتی بهتر: چه دنباله هایی با احتمال بیشتری یا کمتری می آیند (احتمال بیشتر مانند «در کتاب نوشتم» و احتمال کمتر «کتاب پرواز کرد»). آنتروپی یا «بعد» چنین ماشینی تمام آن چیزی است که شکل آن را تعیین می کند. شاید الان بهتر متوجه شده باشید که چرا در مدل های زبانی آنتروپی را مینیمم می کنیم. چیزی که یک شبکه ی عصبی مانند مدل های ترنسفورمر یاد میگیرند تابع آنتروپی هر کلمه به شرط کلمات قبلی است. این آنتروپی فضای بسیار پیچیده و تو در توی زبان را با دقتی بالا تخمین می زند. کاری که حتی تا چند سال پیش غیر ممکن بنظر می رسید.

اما آیا راهی وجود دارد که این را حتی شهودی تر درک کرد؟ برای این منظور فرض کنید شما در یک اتاق هستید که اجسامی در آن وجود دارند. در این حالت هر درجه ی آزادی محدودیت هایی برایش ایجاد می شود. مثلا ممکن است شما براحتی نتوانید به چپ حرکت کنید چون تخت در سمت چپ شماست. اما اگر روی تخت بروید (یعنی در جهت بالا-پایین کمی بالا رفتید اید) می توانید کمی به چپ تر بروید. در اینجا ما با ابعاد فراکتالی روبرو هستیم. اینجا دیگر «بعد» فضا ۳ نیست بلکه بستگی به جایی دارد که قرار گرفته اید، بعضی جاها سه و بعضی جاها کمتر! «بعد» به روشی برعکس مشخص می کند که چه اجسام و اشیایی در فضای اتاق وجود دارند! اگر شما چشم هایتان را ببندید و فقط به صورت تصادفی در اتاق حرکت کنید (فرض کنید حتی می توان بالا پایین هم رفت) در عمل می توانید تمام اتاق را «اسکن» کنید. حتی می توانید این را با دقت بیشتری هم انجام دهید. اگر یک پهپاد به اندازه ی یه زنبور را داخل بفرستید می توانید حتی لیوان توی اتاق رو هم تشخیص بدهید.

مدل های زبانی به همین شکل فضای حرکت بین کلمات را «می روبند»، در ابتدا برخی از ویژگی های کلی به راحتی قابل تشخیص می شوند: مثلا درفارسی فاعل و بعد مفعول و بعد فعل می آید. این دقیقا مانند آن است که در اتاق شما اشیای بزرگ مثل مبل و شومینه را تشخیص دهید. اما اگر با دقت بیشتری نگاه کنید الگو های ریز تری دیده می شود. مثلا اینکه در انگلیسی صفت قبل از موصوف می آید. با ادامه دادن افزایش دقت می توان به جایی رسید که ترتیب کلمات «the capital of france is به درستی کلمه paris را به عنوان کلمه بعدی پیدا کند. اینجا جایی است که شما از مولکول ها برای اسکن کردن «شکل داخل اتاق» استفاده می کنید.

مدل های زبانی در ابتدا هیچ تفاوتی بین انتخاب کلمات نمی گذارند. سیگنال تغییر و کاهش انتروپی (هدف کوچکتر کردن آنتروپی است) باعث می شود شبکه به تدریج بفهمد که کدام کلمات نباید بعد از کدام ها بیایند. این مانند این است که شما در ابتدا باید فرض کنید در هر جای اتاق در هر جهتی می توان حرکت کرد (بیشترین آنتروپی) و سپس چشم هایتان را ببندید به جلو بروید و پایتان به مبل بخورد اینجا می فهمید که «کجا نمی توان رفت». اینجا باید به نکته ی مهمی دقت کنید. وقتی می گوییم مدل زبانی به کلمه توجه می کند باید به این نکته دقت کنید که آن چیزی که مدل به آن دقت می کند بردار کلمه است.این بردار به تدریج اطلاعات زیادی را در خود ذخیره می کند مانند اینکه این توکن«فعل» است یا «مذکر» است یا غیره و غیره. چنین است که این مدل ها قادر به پیدا کردن ویژگی های بسیار سطح بالاتری می شوند. البته چنین ویژگی هایی لزوما همیشه برای ما دقیقا به همان معناهای «فعل» یا «مذکر» یا «اسم کشور» یا «فحش» نیست. به این ترتیب ساز و کارهای داخلی چنین شبکه هایی احتمالا برای همیشه غیر قابل تفسیر خواهد ماند.

اما معنای عمیقتر این است:

آنتروپی، هندسه است.

هندسه، ساختار است.

و ساختار، شکل اطلاعات است: از چینش کلمات یک شعر یا اثبات ریاضی تا نقشهی پخش انسولین در خون تا زبانِ خود کیهان.