ما در دورهای زندگی میکنیم که تب و تاب استفاده از مدلهای هوش مصنوعی به شدت داغ است و همه از این مدلها صحبت میکنند. همچنین باید توجه داشت که اجرای یک مدل زبانی بزرگ نیاز به منابع سختافزاری قابل توجهای دارد و روی اکثر کامپیوترهایی که ما در خانه یا محل کار داریم ممکن است اجرای آنها با چالشهایی از جمله پر شدن حافظهی RAM و عدم پشتیبانی از کارت گرافیک (GPU) و ... روبرو شود که همهی این موارد میتواند باعث اجرای کند و بعضا سخت این مدلها روی کامپیوترهای ضعیف شوند که در تجربهی کاربری نهایی ما از این مدلها تاثیر منفی خواهد داشت.

هدف من در این آموزش، معرفی مدلهای بزرگ هوش مصنوعی نیست و فرض من بر این است که شما اطلاعات اولیهای از LLMها دارید. همچنین قصد دارم که به شما کمک کنم که در صورتی که یک کامپیوتر قابل قبول دارید اما کارت گرافیک آن پشتیبانی نمیشود، شانس خود را برای راهاندازی کارت گرافیک روی Ollama امتحان کنید تا کامپیوتر شما بتواند پردازشهای هوش مصنوعی را با سرعت بیشتری انجام دهد و یک تجربهی قابل قبول را برای شما به همراه داشته باشد.

توجه: این آموزش برای Ollama نسخهی ویندوز آماده شده است.

نرمافزار Ollama یک ابزار متنباز است که به کاربران امکان اجرای مدلهای زبانی بزرگ (LLM) روی دستگاههای شخصی را میدهد. این نرمافزار به شما اجازه میدهد بدون نیاز به اینترنت یا سرورهای قدرتمند، از مدلهای هوش مصنوعی مانند Llama استفاده کنید.

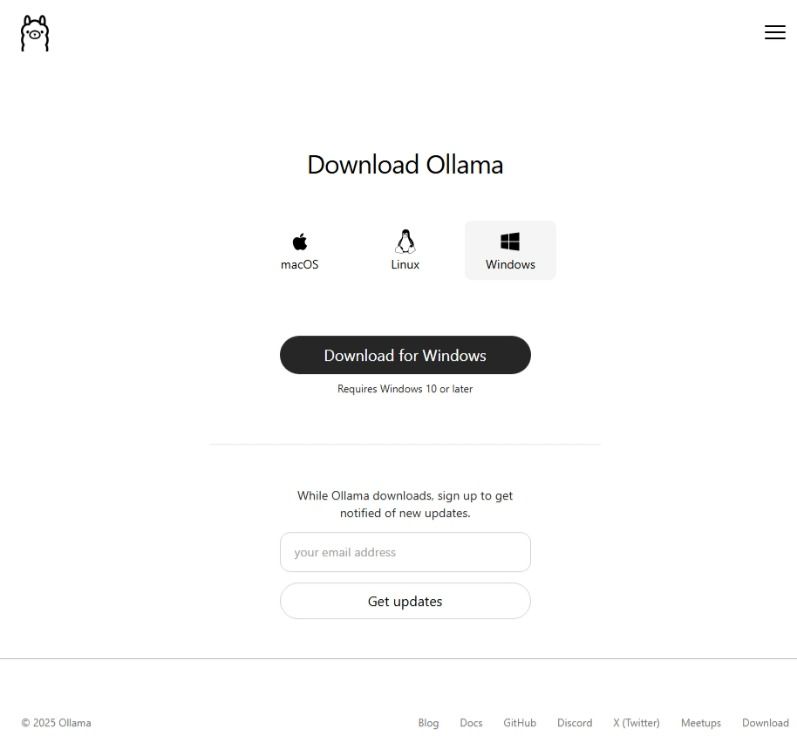

برای نصب این برنامه ابتدا به وبسایت این برنامه مراجعه کنید، با توجه به محدودیت دسترسی برای IPهای ایرانی بهتر است از سرویسهای DNS یا یک ابزار مناسب استفاده کنید:

بعد از ورود به سایت، روی دانلود کلیک کنید تا به صفحه انتخاب سیستمعامل هدایت شوید.

در این بخش ویندوز را انتخاب و Ollama را دانلود کنید.

حجم دانلودی نرمافزار حدودا 970 مگابایت تا 1 گیگابایت است. پس از دانلود، نصاب این برنامه را اجرا و مراحل نصب که خیلی ساده و بدون پیچیدگی است را جلو ببرید تا Ollama نصب شود.

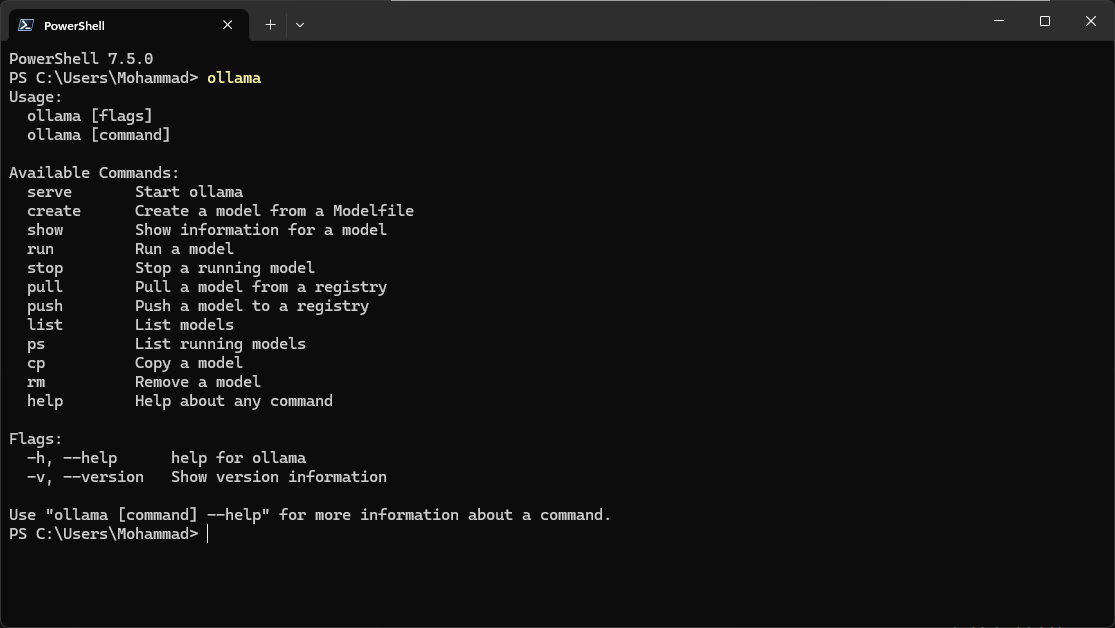

با توجه به اینکه ویندوز دارای چند محیط خط فرمان است، بسته به دلخواه CMD یا PowerShell را اجرا کنید و دستور زیر را در آن بنویسید:

ollama

نتیجه باید چنین چیزی باشد:

اگر نتیجه چیزی غیر از این بود، یکبار محیط خط فرمان را کامل ببنید و مجدد آن را اجرا و دستور بالا را بنویسد، اگر باز هم نتیجه مثل تصویر نبود، بهتر است که یکبار دیگر با دقت Ollama را حذف و نصب کنید و جهت اطمینان یکبار کامپیوتر را Restart کرده و مجدداً تلاش کنید.

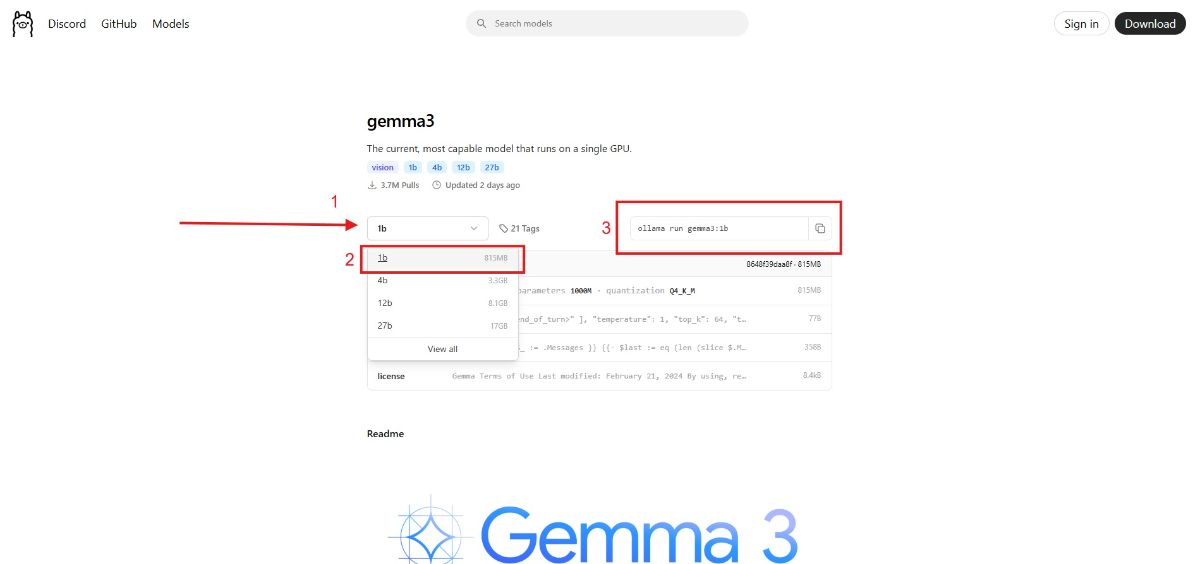

حال بهتر است که یک مدل دانلود و اجرا کنیم تا از صحت عملکرد Ollama و همچنین پشتیبانی یا عدم پشتیبانی آن از GPU مطمئن شویم.

برای شروع بهتر است که یکی از مدلهای سبک و با پارامتر کم، مثلا 1 تا 3 میلیارد پارامتر را انتخاب کنیم، مثل مدلهای Gemma3 1B یا Llama3.1 یا مشابه آن را دانلود کنید.

برای اینکار وارد سایت Ollama شوید و سپس از بخش Models یکی از مدلها را انتخاب کنید. من در اینجا مدل Gemma3 1B را انتخاب میکنم.

حال از بخش 3، دستور مربوط به نصب این مدل را کپی و در خط فرمان قرار میدهم تا نصب شود. این فرایند بسته به سرعت اینترنت ممکن است از چند ثانیه تا چند دقیقه زمان ببرد.

بعد از دانلود و راهاندازی مدل، در خط فرمان خواهید دیک که Ollama مدل را اجرا کرده و آمادهی گرفتن پرامپت است. با نوشتن دستور زیر میتوانید از محیط پرامپت نویسی خارج شوید:

/bye

قبل از اینکه به بررسی پشتیبانی یا عدم پشتیبانی Ollama از GPU برسیم، ابتدا از قسمت System Tray ویندوز سرویس Ollama را با گزینهی Quit Ollama ببندید تا دستورات بعدی که قرار است وارد کنید کار کنند و Error ندهند.

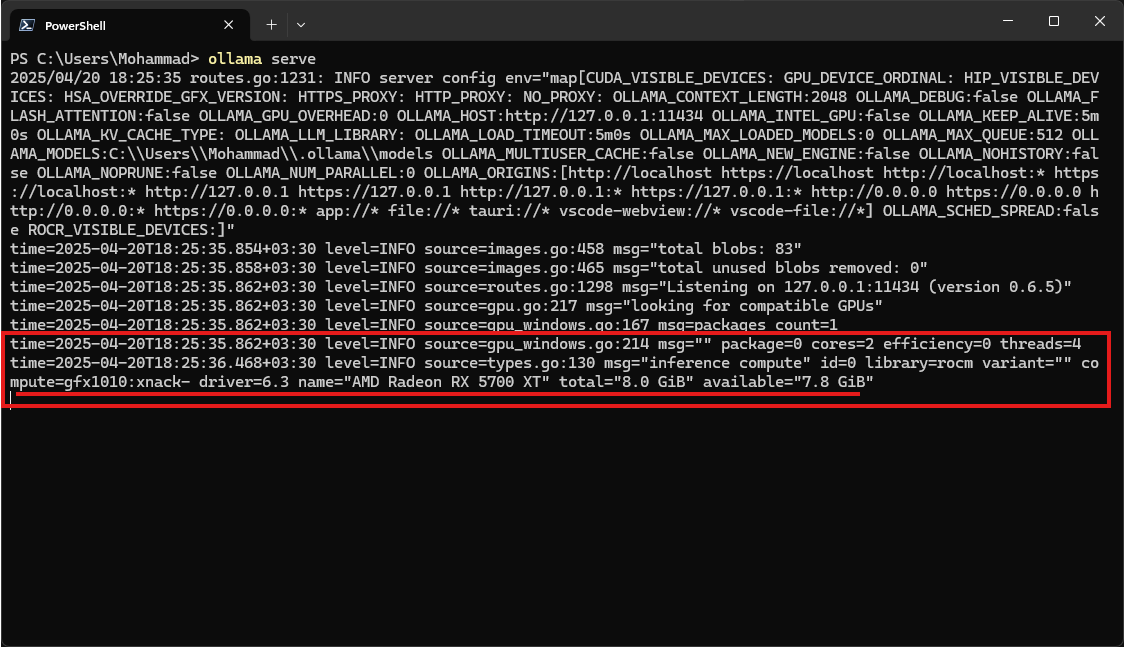

برای بررسی اینکه آیا Ollama از گرافیک AMD شما پشتیبانی میکند یا خیر این دستور را تایپ کنید:

ollama serve

سپس خطوطی که نوشته میشوند را بررسی کنید تا به خطی برسید که توضیحاتی مربوط به کارت گرافیک را داده است. اگر گرافیک شما پشتیبانی شود، باید چنین پیامی را داشته باشید:

اگر گرافیک شما پشتیبانی شود، میتوانید با خیال راحت از مدلهای هوش مصنوعی استفاده کنید و مطمئن باشید که بخش اعظم بار پردازشی روی کارتگرافیک کامپیوتر شما خواهد بود و سرعت به مراتب بالاتر و تجربهی باکیفیتتری خواهید داشت.

ولی اگر با پیامهایی مبنی بر عدم پشتیبانی از کارتگرافیک روبرو شدید بهتر است که طبق دستور العمل زیر مراحل را طی کنید تا Ollama بتواند از کارت گرافیک شما برای پرادازشهای هوش مصنوعی استفاده کند.

برای اینکه بدانید کد GPU کارتگرافیک شما چیست به این لینک مراجعه کنید و ببینید مدل گرافیک شما در مقابل کدام کد نوشته شده است. برای مثال سری گرافیکهای AMD RX 5700 و AMD RX 5700 XT کد مقابل آنها در ستون GPU Arches این کد gfx1010 است.

ابتدا این کد را برای مدل گرافیکی که دارید پیدا کنید تا در ادامه به سادگی بتوانید به فایلهای درست دسترسی داشته باشید.

بعد از پیدا کردن کد GPU، باید موارد مورد نیاز را یک به یک دانلود، نصب و راهاندازی کنیم.

مرحلهی اول، بهروز رسانی درایور کارت گرافیک

ابتدا آخرین نسخهی درایور کارت گرافیک را دانلود و نصب کنید. اینکار به شما اطمینان میدهد که میتوانید ادامهی کار را با کمترین مشکل بهپیش ببرید.

مرحلهی دوم، نصب AMD ROCm™ Software

ابزار ROCm یک نرمافزار متنباز از شرکت AMD است که شامل مدلهای برنامهنویسی، ابزارها، کامپایلرها، کتابخانهها و محیطهای اجرایی برای توسعهی راهحلهای هوش مصنوعی و پردازش با عملکرد بالا (HPC) روی پردازندههای گرافیکی این شرکت میباشد. ROCm بهطور ویژه برای هوش مصنوعی مولد و برنامههای HPC بهینهسازی شده است و امکان مهاجرت کدهای موجود را از پلتفرمهای دیگر به این پلتفرم بهراحتی فراهم میکند.

در زمان نگارش این مقاله برای این آموزش، نسخههای 6.2.4 و 5.7.1 سازگاری کاملی به جهت راهاندازی GPUهای پشتیبانی نشده دارند.

اگر میخواهید بسته به اینکه چه نسخهی جدیدی برای اینکار مناسب است، به مرحلهی بعدی بروید و در آنجا مشخص خواهد بود که ابزارهای بعدی با چه نسخهای سازگار هستند و شما به این مرحله باز گردید و نسخهی جدید سازگار را دانلود کنید.

برای دانلود ابزار HIP SDK که شامل پیشنیازهای ROCm و باقی موارد میشود، ابتدا وارد این لینک شوید و سپس بسته به اینکه از ویندوز 10/11 استفاده میکنید یا ویندوز سرور یکی از نسخههای سازگار و یکسان با ROCmlibs را دانلود کنید.

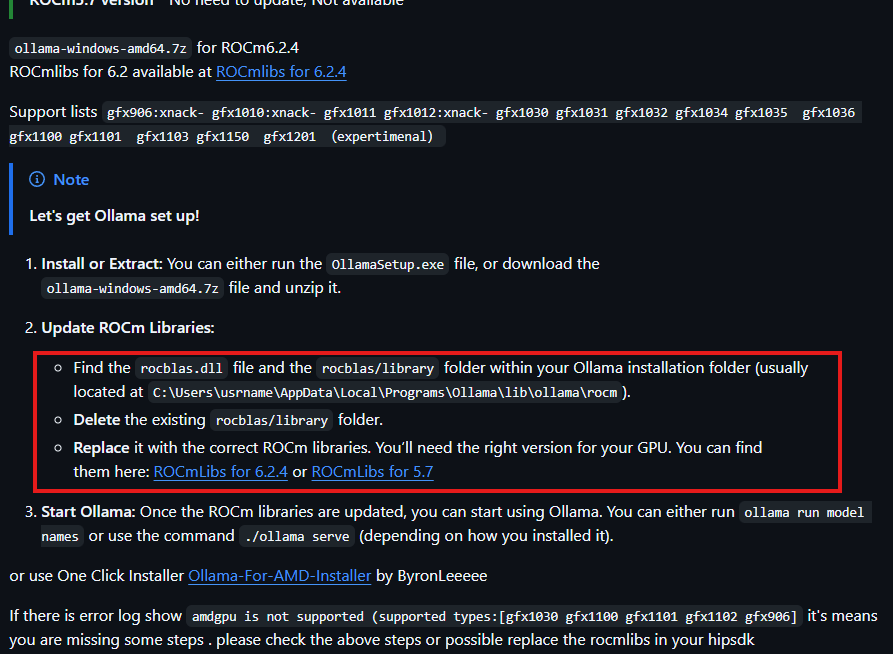

مرحلهی سوم، دانلود فایلهای اصلاح شده GPU

ابتدا وارد این لینک شوید و سپس به بخش دوم راهنمای نصب یعنی Update ROCm Libraries رفته و در آنجا یک یا دونسخه از پچهای مربوط به راهاندازی GPU وجود دارد که با نامهایی مانند ROCmlibs for 6.2.4 و مشابه آن مشخص شدهاند.

بسته به نسخهای که از HIP SDK نصب کردهاید و یا اینکه با توجه به محدودیتهایی که ممکن است در آینده پیش بیایید، بهتر است که نسخهی ROCmlibs و HIP SDK یکسان باشد. پس در انتخاب این دو مورد دقت زیادی داشته باشید.

حال وارد لینک ROCmlibs for 6.2.4 یا نسخههای دیگر آن شوید و از بخش Assets نسخهی مطابق با کد GPU خود را دانلود کنید.

نکته: این بخش برای هر کد GPU دو نسخه از پچ را برای دانلود قرار داده است. نسخهی -xnack و نسخهی -no xnack که بهتر است شما هر دو نسخه را دانلود کنید و داشته باشید.

اینکه xnack چیست خود نیاز به یک مقالهی جداگانه دارد که بیشک در رفرنسهای فارسی به این موضوع آنچنان که باید پرداخته نشده است، ولی به صورت کلی یک قابلیت در GPUها و APUهای شرکت AMD است که به پردازندهی گرافیکی اجازهی مدیریت اطلاعات در RAM یا حافظهی مجازی را میدهد. البته این قابلیت در اغلب کارتهای گرافیکی AMD ممکن است غیر فعال باشد.

پینشهاد میکنم که اگر از گرافیکهای سری RX 4xx و RX 5xx و همچنین سری RX 5xxx استفاده میکنید، از پچ -no xnack استفاده کنید. همچنین برای اطمینان از اینکه GPU شما آیا از xnack پشتیبانی میکند یا خیر میتوانید به این مسیر بروید:

C:\Program Files\AMD\ROCm\6.2\bin

نکته: بهجای شمارهی 6.2 باید با توجه به نسخهی HIP SDK این مورد اصلاح شود.

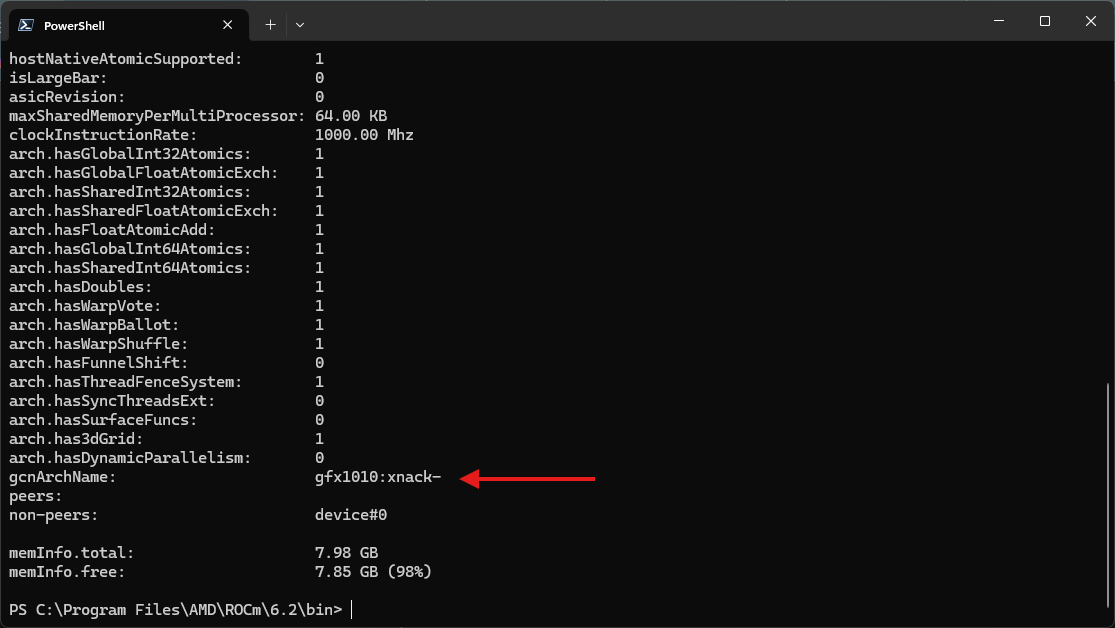

سپس یک خط فرمان در این مسیر باز کنید و این دستور را بنویسید و کلید اینتر را بفشارید:

.\hipInfo.exe

باید چنین اطلاعاتی به شما نمایش داده شود:

برای من در بخش gcnArchName نوشته شده -gfx1010:xnack که یعنی GPU کارت گرافیک کامپیوتر من میتواند از -xnack استفاده کند. ممکن است که برای برخی مدلها +xnack نوشته شده باشد که این یکی دیگر از Modeهای این قابلیت است.

نکته بسیار مهم: با اینکه برای من نوشته شده که از -xnack پشتیبانی میشود، ولی در حین فعال سازی GPU نتوانستم که با فایلهای مربوط به این حالت، در Ollama بار پردازشی را روی GPU قرار دهم و مجبور به استفاده از فایلهای -no xnack شدم. پس شما هم اگر دیدید که با یک حالت GPU راهاندازی نمیشود، با حالت دیگر نیز تست کنید تا به احتمال خیلی زیاد GPU برای شما نیز راهاندازی شود.

مرحلهی چهارم، جایگزینی فایلهای اصلاح شده

در این مرحله باید فایلهای دانلود شده را جایگزین فایلهای قبلی در Ollama یا ابزارهایی که از Ollama استفاده میکنند مانند نرمافزار Msty کنیم. هیچ تفاوتی بین فایلهای -xnack و -no xnack در این مرحله نیست و هر دو به یک شکل انجام میشوند. پس فارغ از اینکه کدام نسخه را دانلود کردهاید این کار را انجام دهید.

ابتدا وارد مسیر نسب نرمافزار Ollama و پوشهی rocm شوید:

C:\Users\%USERNAME%\AppData\Local\Programs\Ollama\lib\ollama\rocm

** بهجای %USERNAME% نام کاربری ویندوز خود را وارد کنید. **

حال فایل rocblas.dll موجود در پچ دانلود شده را جایگزین فایل قبلی در پوشهی rocm کنید.

سپس وارد پوشهی rocblas در مسیر بالا شوید و در آن یک پوشهی دیگر به نام library خواهید دید که بهتر است آن را پاک کنید و پوشهی library موجود در پچ دانلود شده را جای آن کپی کنید.

البته طبق برخی منابع گفته شده که میتوانید پوشهی library پچ را با پوشهی library پیشفرض Ollama ادغام کنید ولی چنین کاری را پیشنهاد نمیکنم. چون در رفرنس اصلی این مقاله تاکید شده که پوشهی library پیشفرض Ollama را باید پاک کنید.

بعد از انجام این مراحل کار تمام است و باید بررسی کنید که آیا Ollama از GPU کامپیوتر شما پشتیبانی میکند یا خیر. اگر تمام مراحل را به درستی پیش رفته باشید، به احتمال خیلی زیاد میتوانید GPU را فعال کنید ولی کماکان احتمال این موضوع وجود دارد که در آینده برخی از گرافیکهای قدیمیتر دیگر نتوانند به خوبی با این پچ کار کنند.

برای بهروز رسانی Ollama به نسخههای جدیدتر، بعد از اعمال این پچ بهتر است که از فایل رسمی Ollama استفاده نشود و از این لینک در بخش Assets آخرین نسخهی موجود را دانلود و جایگزین نسخهی قبلی کنید تا پچ شما از کار نیافتد.

همچنین بهتر است که از مدلهای هوش مصنوعی استفاده کنید که حجمشان برابر یا نصف حجم vRam کارت گرافیک باشند. چرا که با افزایش حجم مدل و تعداد پارامترهای آن ممکن است کامپیوتر و GPUی شما از پس پردازش حجیم مدلهایی با میزان پارامتر بالا بر نیاید.

پیشنهاد من به شما به این شکل است:

پردازنده تا 8 هسته، Ram تا 32 گیگ و گرافیک تا 8 گیگابایت vRam => مدلهایی 0.5 تا 10 میلیارد پارامتر

پردازنده تا 16 هسته، Ram تا 64 گیگ و گرافیک تا 16 گیگابایت vRam => مدلهایی تا 20 میلیارد پارامتر

پردازنده تا 32 هسته، Ram تا 128 گیگ و گرافیک تا 24 گیگابایت vRam => مدلهایی تا 30 میلیارد پارامتر

نکته: این پیشنهادها به شکل تقریبی هستند و ممکن است بسته به مدل هوش مصنوعی و موارد دیگر پردازش این تعداد پارارمتر برای هر کدام از این رنجهای پیشنهادی متفاوت باشد.

امیدوارم که این آموزش بتواند به شما در پیشبرد اهدافتان در زمینهی هوش مصنوعی کمک کرده باشد، اگر این مطلب برای شما مفید بود، خوشحال میشوم من را در کافیته یا دارمت به یک قهوه مهمان کنید و به من برای تولید محتوای بهتر و قویتر انگیزه دهید.