این منبع، مقالهای تحقیقاتی با عنوان «TreeRAG: رهاسازی قدرت ذخیرهسازی سلسلهمراتبی برای بازیابی دانش پیشرفته در اسناد طولانی» را معرفی میکند. این مقاله سیستم جدیدی به نام TreeRAG را پیشنهاد میکند که یک چارچوب بازیابی-تولید تقویتشده (RAG) است و برای مقابله با چالشهای بازیابی اطلاعات از اسناد بلند طراحی شده است. روش اصلی آن شامل بخشبندی درختی (Tree-Chunking) برای سازماندهی اسناد به ساختاری شبیه به درخت و یک استراتژی بازیابی پیمایش دوجهته (Bidirectional Traversal Retrieval) است. هدف TreeRAG حفظ بهتر انسجام و یکپارچگی اطلاعات بین بخشها، در مقایسه با روشهای سنتی RAG و سایر چارچوبهای پیشرفته است. نتایج تجربی نشان میدهد که TreeRAG عملکرد بازیابی و تولید پاسخ را در مجموعهدادههای مختلفی مانند مالی، حقوق و پزشکی بهطور قابلتوجهی بهبود میبخشد.

این تجربه ناامیدکننده برای بسیاری از ما آشناست: یک سیستم هوش مصنوعی مبتنی بر RAG (تولید محتوای дополненشده با بازیابی) را با اسناد طولانی و دقیقی تغذیه میکنیم، سؤالی میپرسیم که پاسخ آن قطعاً در اسناد وجود دارد، اما جوابی ناقص، بیربط یا خارج از بافتار دریافت میکنیم. این ناکامی، تقصیر مدل زبانی بزرگ (LLM) نیست؛ بلکه شکست «سیستم کتابداری» یا «ساختار سازماندهی اطلاعات» آن است. مدلهای هوش مصنوعی هرچقدر هم که قدرتمند باشند، اگر اطلاعات به شکلی آشفته در اختیارشان قرار گیرد، در کتابخانه دانش خودشان گم میشوند.

راهحل این مشکل در یک تغییر بنیادین نهفته است: حرکت از ذخیرهسازی ساده و «مسطح» اطلاعات به سمت ساختارهای هوشمند و سلسلهمراتبی. در این مقاله، بررسی میکنیم که چگونه اصول معماری چارچوب نوآورانه TreeRAG نهتنها این مشکل را حل میکند، بلکه رویکرد ما به بازیابی دانش را از نو تعریف میکند.

--------------------------------------------------------------------------------

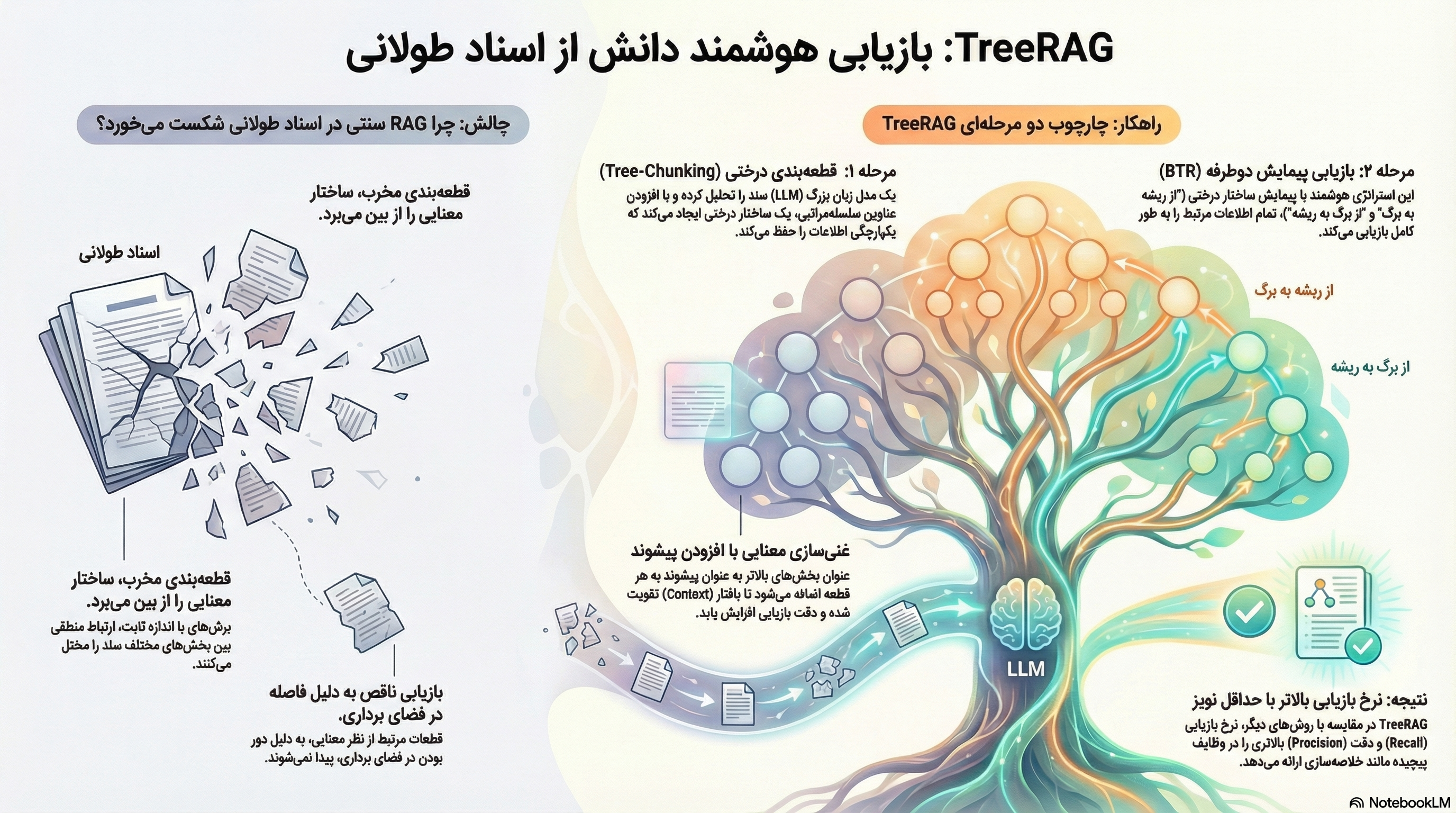

ضعف اصلی چارچوبهای RAG سنتی در همان اولین قدم نهفته است: استفاده از روشهای قطعهبندی ساده (naive chunking). این روشها که در تحقیقات بنیادین TreeRAG به عنوان «بسیار مخرب» (highly destructive) توصیف شدهاند، مانند این است که صفحات کتابها را بهطور تصادفی پاره کرده و روی زمین کتابخانه پخش کنیم. آنها اطلاعات را بر اساس معیارهای سادهای مانند تعداد کلمات یا پاراگرافها تقسیم میکنند.

این رویکرد پیامدهای منفی شدیدی دارد:

نابودی جریان معنایی: با تقسیمبندی مکانیکی، یکپارچگی و پیوستگی معنایی اطلاعات اصلی از بین میرود. یک مفهوم پیچیده که در چند پاراگراف توضیح داده شده، به قطعاتی بیربط تبدیل میشود.

قطع ارتباط بین قطعات: ارتباط معنایی بین قطعات مرتبط با یکدیگر از بین میرود. این امر منجر به «فواصل نامطلوب برداری» (suboptimal vector distances) میشود؛ یعنی قطعاتی که باید از نظر معنایی به هم نزدیک باشند، در فضای برداری از هم دور میافتند.

شکست در پرسوجوهای پیچیده: در نتیجه، بازیابی تمام قطعات لازم برای پاسخ به پرسوجوهای پیچیده، مانند خلاصهسازی متمرکز بر پرسوجو (Query-Focused Summarization - QFS)، تقریباً غیرممکن میشود.

این یک نقص بنیادین در خط لوله هضم داده (data ingestion pipeline) است؛ یک شکست در لایه صفر که سایر بخشهای سیستم نمیتوانند آن را جبران کنند و دقیقاً همان مشکلی است که چارچوبهای پیشرفتهای مانند TreeRAG برای حل آن طراحی شدهاند.

اولین نوآوری بزرگ TreeRAG، روش Tree-Chunking است. این روش به جای تقسیمبندی کورکورانه، به ساختار منطقی که نویسنده در سند ایجاد کرده، احترام میگذارد و در واقع، فهرست مطالب و کارتهای نمایهی کتابخانه را بازیابی میکند.

Tree-Chunking با استفاده از یک LLM، «ساختار کلی به جزئی» (general-to-specific structure) سند را تحلیل کرده و آن را به صورت سلسلهمراتبی دستهبندی میکند و برای هر بخش، عناوین و شمارههای نمایهای اختصاص میدهد. اگر سند را یک کتابخانه فرض کنیم، Tree-Chunking کتابها را بر اساس بخش، فصل و موضوع مرتب میکند، نه بر اساس تعداد صفحات.

مهمترین بخش این فرآیند، مفهومی به نام پیشوندگذاری (Prefix Concatenation) است. قبل از اینکه هر قطعه (chunk) به بردار تبدیل شود، عنوان «سطح بالاتر بلافصل» آن به عنوان یک پیشوند به ابتدای آن اضافه میشود.

این کار تأثیر شگرفی دارد، زیرا:

ارتباط صریح بین یک قطعه جزئی و بافتار کلیتر آن را حفظ میکند.

مشکل «فاصله نامطلوب برداری» را حل کرده و قطعات مرتبط را در فضای برداری به هم نزدیکتر میکند.

ابهام ارجاعی ضمایر را برطرف میکند؛ وقتی ضمیری مانند «آن» یا «شرکت» به موضوعی اشاره دارد که چندین پاراگراف قبلتر ذکر شده، این پیشوند به LLM کمک میکند تا مرجع را به درستی تشخیص دهد.

نوآوری دوم TreeRAG، استراتژی بازیابی هوشمند آن به نام بازیابی پیمایش دوطرفه (Bidirectional Traversal Retrieval - BTR) است. اگر Tree-Chunking کتابخانه را مرتب میکند، BTR نقش یک «کتابدار هوشمند» را ایفا میکند که میداند چگونه از این ساختار درختی برای یافتن دقیق اطلاعات استفاده کند. این استراتژی ضروری است زیرا، همانطور که تحقیقات نشان میدهد، برای برخی پرسوجوها، «مفاهیم متعددی که یک موجودیت واحد را توصیف میکنند، ممکن است از نظر فضای برداری فاصله ایدهآلی از پرسوجوی کاربر نداشته باشند.»

فرآیند با یک گام هوشمندانه آغاز میشود: یک LLM ابتدا «هدفشناسی» (intent recognition) انجام میدهد تا بفهمد آیا کاربر به دنبال یک خلاصه یا یک فهرست است. سپس، بر اساس این هدف، یکی از دو فلسفه پیمایش زیر را به کار میگیرد:

«از ریشه به برگها» (Root-to-Leaves): این یک رویکرد بالا به پایین برای «گسترش بافتار» (context expansion) است. اگر جستجوی اولیه یک گره سطح بالا (مانند خلاصه یک فصل) را پیدا کند، کتابدار هوشمند ما به طور خودکار تمام گرههای برگ (جزئیات دقیق) زیرمجموعه آن را نیز بازیابی میکند. این کار «کامل بودن جزئیات» را تضمین میکند.

«از برگ به ریشهها» (Leaf-to-Root): این یک رویکرد پایین به بالا برای «حفظ بافتار» (context preservation) است. اگر جستجو تنها یک واقعیت خاص یا نقلقول (یک گره برگ) را پیدا کند، کتابدار نهتنها آن را پیدا میکند، بلکه کل فصل (گره والد) را نیز برای ارائه بافتار به شما میدهد و سپس میتواند محتوای گرههای برگ همتا یا تمام گرههای برگ زیرمجموعه آن گره والد را استخراج کند.

این رویکرد آنقدر قدرتمند است که میتواند شکستهای جستجوی معنایی را جبران کند:

این فرآیند تضمین میکند که حتی در موارد شدید که تنها یکی از قطعات صحیح بازیابی شده است، سیستم بتواند بافتار سطح بالاتر را جذب کرده و تمام قطعات مرتبط دیگر را بازیابی کند. این مکانیسم به عنوان یک «شبکه ایمنی ساختاری» عمل میکند که در صورت شکست جستجوی صرفاً معنایی، سازماندهی منطقی سند را رعایت میکند.

آزمایشهای انجام شده روی مجموعه داده Dragonball (شامل حوزههای مالی، حقوقی و پزشکی) نشان میدهد که TreeRAG به «بهبودهای چشمگیری هم در کیفیت نرخ بازخوانی (Recall) و هم در دقت (precision)» دست یافته و در عین حال «حداقل نویز» را به سیستم وارد میکند.

برای درک بهتر جایگاه معماری TreeRAG، میتوان آن را با رقبای اصلیاش مقایسه کرد:

RAPTOR: این چارچوب نیز ساختار درختی ایجاد میکند، اما رویکرد آن پایین به بالا (bottom-up) است؛ یعنی با خوشهبندی معنایی و خلاصهسازی قطعات، گرههای بالاتر را میسازد. در مقابل، TreeRAG از ساختار صریح خود سند و به صورت بالا به پایین (top-down) عمل میکند. این یک تصمیم معماری حیاتی را پیش روی ما میگذارد: TreeRAG وفاداری به ساختار اصلی نویسنده را در اولویت قرار میدهد و برای اسنادی مانند قراردادهای حقوقی یا مقالات پژوهشی فوقالعاده پایدار است. در مقابل، RAPTOR ساختار معنایی نوظهور را در اولویت قرار میدهد که میتواند ارتباطات جدیدی را کشف کند، اما اگر خلاصهسازی LLM دچار خطا شود، با خطر تفسیر نادرست مواجه است.

چشمانداز وسیعتر RAG: TreeRAG جهش بزرگی در بهرهبرداری از سلسلهمراتب صریح یک سند است. چشمانداز وسیعتر RAG به طور همزمان در حال کاوش مسیرهای موازی و مکمل است.

در حالی که TreeRAG ناوبری در نقشه موجود یک سند را کامل میکند، چارچوبهایی مانند GraphRAG و HopRAG بر ساختن نقشههای منطقی کاملاً جدید و پیچیدهتر (گرافها) بر روی متن تمرکز دارند تا به پرسوجوهای چندمرحلهای (multi-hop) پاسخ دهند.

در این میان، CFT-RAG یک رقیب نیست، بلکه یک بهینهسازی مستقیم برای معماری TreeRAG است. این چارچوب که به عنوان یک «روش شتابدهنده Tree-RAG» توصیف میشود، برای حل «تنگناهای کارایی محاسباتی» آن طراحی شده است. این تمایز حیاتی، درک عمیقتری از این حوزه را نشان میدهد.

--------------------------------------------------------------------------------

درس نهایی از TreeRAG قطعی است: هوش بهتنهایی کافی نیست. ساختار، امری حیاتی است. قبل از اینکه از مدلهایمان بخواهیم فکر کنند، باید ابتدا به آنها بیاموزیم که چگونه کتابخانه خود را سازماندهی کنند. آینده RAG فقط ساخت مدلهای بزرگتر نیست؛ بلکه طراحی معماران دانش هوشمندتر است.

حال این سؤال مطرح میشود: با پیچیدهتر شدن سیستمهای هوش مصنوعی، آیا نقش «معمار اطلاعات» از نقش «سازنده مدل» مهمتر خواهد شد؟