اگر بخواهیم بیپرده حرف بزنیم، بیشتر شکستهای سئو از خود محتوا یا لینکها شروع نمیشود، از ندیدن خطاها شروع میگردد. صفحه منتشر میشود، ایندکس ناقص است، ریدایرکت زنجیرهای داریم، عنوانها تکراری است، اسکیما ناهماهنگ است، سرعت در موبایل افت دارد و در نهایت گزارشها سالی یکبار باز میشوند. نتیجه هم معلوم است: ترافیک نوسانی و فرصتهای از دسترفته.

این راهنما دقیقاً برای همین گره نوشته شدهاست؛ یک متن آموزشی و تحلیلی که به شما یاد میدهد چطور با ۱۲ ابزار شناختهشده سئو، خطاها را کشف، اولویتبندی و رفع کنید. لحن متن آموزشی است اما نگاه تحلیل و میدان عمل دارد تا برای مدیر محتوا، کارشناس سئو تکنیکال، توسعهدهنده، و حتی صاحب کسبوکار قابل استفاده باشد.

پیش از رفتن سراغ ابزارها، باید ذهن را روی یک قاعده ساده تنظیم کنیم: هر گزارشی سه لایه دارد:

لایه اول، خطاهای بحرانی فنی که مانع دیدهشدن صفحه میشوند؛ مثل کد وضعیت اشتباه، noindex ناخواسته، robots نادرست، ریدایرکتهای تودرتو، انفجار پارامترهای URL و تعارض Canonical. این موارد همیشه اولویت ۱ هستند چون به دیدهشدن لطمه مستقیم میزنند.

لایه دوم، مسائل تجربه کاربری و سرعت مانند CLS ،LCP ،TTFB، اسکریپتهای بلاککننده رندر و تصاویر بدون فشردهسازی. اینها اولویت ۲ اند و هم روی رتبه و هم روی تبدیل اثر دارند.

لایه سوم، بهینهسازی محتوایی و ساختار داخلی است؛ تگهای عنوان، توضیحات متا، هدرها، لینکهای داخلی، انکرتکستها، و اسکیما. اینها با اینکه مهماند اما بعد از مطمئنشدن از سلامت لایههای ۱ و ۲ سراغشان میرویم.

وقتی با این لنز سراغ هر ابزار سئو بروید، گزارشهای طولانی ناگهان تبدیل به چکلیستهای منطقی میشوند. در ادامه به معرفی 12 ابزار سئو برای کشف و رفع خطا میپردازیم.

Seoptimer برای مواقعی ساخته شده که میخواهید یک صفحه یا دامنه را در چند ثانیه ارزیابی کنید. گزارش آن معمولاً شامل وضعیت متا تگها، هدرها، تراکم کلیدواژه، لینکهای داخلی و خارجی، تگهای Open Graph، آیکونها، وضعیت موبایلفرندلی و چند شاخص سرعت است. افزونه کروم به شما اجازه میدهد همان لحظهای که صفحه را میبینید، ممیزی سبک انجام دهید.

استفاده آموزشی از Seoptimer روشن است: به دانشجویان یا اعضای تیم نشان میدهد که اصول صفحه استاندارد چیست و کدام اشکالها بیشتر تکرار میشود. برای کار عملی هم زمانی مفید میباشد که میخواهید تأثیر یک اصلاح را فوری بسنجید؛ مثلاً تغییر عنوان، افزودن Canonical، یا بهینهسازی متا توضیح. محدودیتش این است که عمق Crawl ندارد و برای خطاهای پیچیده معماری یا دادههای ساختاریافته باید سراغ ابزارهای تخصصیتر بروید.

Website Grader از محصولات HubSpot با هدف ارائه یک نگاه ۳۶۰ درجه به وبسایت طراحی شدهاست. خروجی آن چهار بلوک کلیدی دارد: عملکرد، موبایل، سئو و امنیت. برای تیمهای آموزشی، این تفکیک عالی است چون میتوان بین نقشها تقسیم کار کرد؛ توسعهدهنده روی امنیت و عملکرد تمرکز کند، کارشناس سئو روی متا و ساختار، طراح روی موبایل و Layout.

برای تحلیل قبل و بعد هم مفید میباشد؛ یک اسکرینشات از نمرههای اولیه، سپس اجرای پروژه بهینهسازی و بعد مقایسه عددی. حواستان باشد این امتیاز یک «شاخص راهنما» است نه معیار مطلق رتبهبندی. هدف، روند بهبود است نه شکار نمره کامل.

SiteAnalyzer ماهانه چندین تحلیل رایگان میدهد و نزدیک به پنجاه پارامتر را پوشش میدهد. جذابیت آموزشی این ابزار در دو چیز است: اول نمره جهانی که به شما حس وضعیت کلی میدهد، دوم گزارشهای جزئی درباره سرعت، دسترسی، ساختار لینکها و طراحی.

اگر وبسایت شما تازه راه افتاده یا معماری URL پیچیده دارد، با تمرکز روی Crawlability میتوانید سریعتر مشکل ایندکس را پیدا کنید؛ مثل حلقههای ریدایرکت، پارامترهای بیکنترل، یا لینکهای شکسته که جریان PageRank داخلی را قطع میکنند. در پروژههای آزمایشی هم به درد میخورد؛ چون میتوانید بدون هزینه زیاد، تصویر اولیه نسبتاً دقیقی بگیرید.

MySiteAuditor دقیقاً جایی میدرخشد که نیاز است یک صفحه برای یک کلیدواژه خاص ممیزی شود. فرض کنید یک صفحه لندینگ دارید که قرار است روی «خرید بیمه بدنه ارزان» رتبه بگیرد. این ابزار روی همان صفحه و همان کلیدواژه تمرکز میکند و مواردی مثل وجود کلیدواژه در عنوان، توضیح متا، H1، آدرس صفحه، Alt تصاویر، تراکم منطقی، طول محتوا، لینکهای داخلی مرتبط و سلامت تگها را بررسی میکند.

تولید خروجی PDF تمیز و امکان ارسال ایمیلی باعث میشود برای آژانسها ابزار مناسبی جهت Lead Generation باشد. نسخه آزمایشی ده روزه برای تیمهای آموزشی فرصت خوبی است تا فرآیند ارزیابی صفحهمحور را تمرین کنند. محدودیت اصلی آن این است که به اندازه یک خزنده عمیق، اشکالات معماری یا سایتمپ را نشان نمیدهد.

کنسول جستجوی گوگل ابزار رایگان اما حیاتی است. اینجا داده واقعی رفتار گوگل با سایت شما نمایش داده میشود: چه صفحاتی ایندکس شدهاند، کدامها Excluded هستند و چرا، وضعیت Discover چگونه است، ویدیوها چطور دیده میشوند، نرخ کلیک و جایگاه میانگین برای هر Query و هر URL چیست. در بخش Page Indexing به سرعت متوجه میشوید کدام صفحات به خاطر 404، ریدایرکت، soft 404 ،blocked by robots یا Duplicate without user selected canonical کنار گذاشته شدهاند.

برای آموزش تیم، تمرین خواندن این پیامها مهمتر از حفظ کردن اصطلاحات است؛ شما باید بتوانید پیام خطا را به اقدام عملی تبدیل کنید. مثلا «Duplicate, Google chose different canonical than user» را باید به بررسی کنونیکال، سیگنالهای داخلی، لینکهای خارجی و محتوای مشابه ترجمه کنید. بخش Core Web Vitals هم به شما میگوید روی کدام گروه از URLها مشکل LCP یا CLS دارید تا به جای دستکاری کور، روی الگوهای قالبی اصلاح انجام دهید.

UpCity با دریافت ایمیل، کلیدواژه هدف، آدرس سایت و یک رقیب برای شما کارت امتیاز تولید میکند. خروجی آن برای جلسات غیرفنی فوقالعاده است چون گرافیک روشن دارد و مفاهیم را ساده توضیح میدهد: وضعیت رتبه، بکلینکها، اشارهها، ترافیک تخمینی و چند شاخص فنی. در کلاسهای آموزشی یا ارائه به مدیران، این کارت شروع خوبی برای همسو کردن ذهنهاست. اما اگر قصد دارید خطای خاصی را ریشهیابی کنید، این ابزار را به عنوان نقشه کلی ببینید و برای جزئیات به خزندهها و کنسول برگردید.

Moz Crawl Test یک ابزار قدیمی اما کارآمد برای یافتن مشکلاتی است که معماری سایت را ضعیف میکند. مثلا حلقههای ریدایرکت که هم سرعت را میکشند و هم بودجه Crawl را، تگهای عنوان تکراری که سیگنال موضوعی را مبهم میکنند، یا محتوای تکراری که باعث میشود گوگل بین دو URL مشابه سرگردان شود. اگر سایتی دارید که طی سالها چندین بار مهاجرت داشته، این ابزار به شما نشان میدهد کجاها هنوز رد پای مسیرهای قدیمی وجود دارد. استفاده آموزشی خوب آن این است که برای دانشجویان روشن میکند چرا «یک ریدایرکت ساده» اگر درست مدیریت نشود، تبدیل به زنجیرهای از افت کیفیت میشود.

Found سه جبهه را همزمان میسنجد: تکنیکال، آنپیج و آفپیج. خروجی PDF سبک آن برای شروع جلسات برنامهریزی یا تهیه اسلایدهای داخلی به کار میآید. اگر تیم شما تازه در حال یادگیری تفکیک وظایف است، این ابزار کمک میکند مرزها روشن شود: چه چیزی وظیفه توسعه است، کدام مورد مربوط به محتواست، و کجا باید روابط عمومی و لینکسازی وارد شود. البته برای رصد عمیق بکلینکها یا تحلیل رقبا باید به سراغ مجموعههای تخصصیتر بروید، اما برای شروع مسیر، Found تصویر ساده و سریعی میدهد.

FirstSiteGuide بیشتر بهدرد استراتژی میخورد تا جراحی فنی. با نگاه به رتبهها، کلمات کلیدی و وضعیت محتوا، بهشما نشان میدهد بازار چگونه تقسیم شده و کدام موضوعات بیصاحب ماندهاند. اگر مجله آموزشی دارید، این داده برای برنامهریزی تقویم محتوا طلاست؛ به جای نوشتن دهمین مقاله «سئو چیست»، سراغ موضوعاتی بروید که رقبا کم پوشش دادهاند اما تقاضا وجود دارد. در پروژههای تحلیل، از FirstSiteGuide برای تعریف خوشههای موضوعی، نقشه دستهبندیها و تعیین اولویت تولید محتوا استفاده کنید، سپس یافتهها را با داده واقعی کنسول جستجو تطبیق دهید.

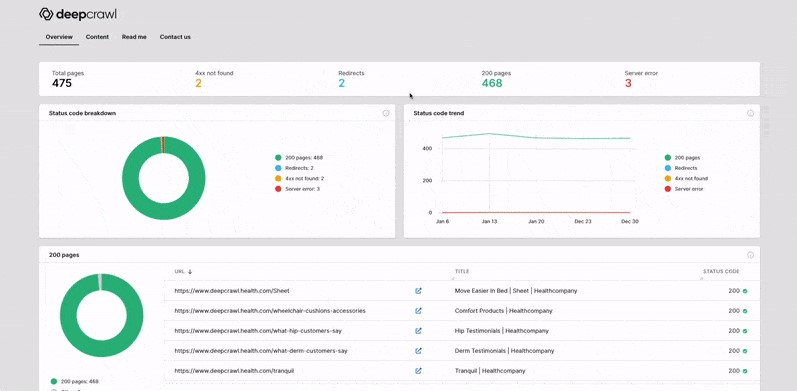

اگر با سایتی طرف هستید که هزاران یا میلیونها URL دارد، Deepcrawl همان ابزاری است که بهآن نیاز دارید. قابلیت برنامهریزی Crawl، تعریف قوانین، شخصیسازی محدودیتها و گزارشهای تیمی باعث میشود بتوانید ممیزیهای دورهای تنظیم کنید و روند بهبود را در طول زمان بسنجید.

برای سایتهای خبری، فروشگاهی و پرترافیک که قالبها، فیلترها و پارامترها زیادند، Deepcrawl اشکالات ریز ولی اثرگذار را بیرون میکشد؛ مثل تولید انبوه URLهای کمارزش توسط فیلترها، عدم هماهنگی Canonical با نسخه انتخابی، یا بودجه Crawl که بیهوده صرف آرشیوهای کمارزش میشود. نکته آموزشی اینجاست که مدیریت سایت بزرگ، بیشتر «مدیریت الگوها» است تا «ادیت دستی صفحات».

SE Ranking در بخش Site Audit بیش از ۷۰ سیگنال را بررسی میکند؛ از وضعیت دامنه و SSL گرفته تا لینکها، محتوا، موبایل و ساختار. خروجی PDF و مهمتر از آن چکلیست اقدام، همکاری بین واحدها را ساده میکند. مثلا توسعه روی فشردهسازی تصاویر و حذف رندر بلاککننده کار کند، محتوا روی ساختار هدرها و پوشش کلیدواژههای فرعی، و سئو روی لینکهای داخلی و اسکیما.

اگر تیم شما تازهکار را با روشهای استاندارد مدیریت پروژه مثل Sprint و Kanban پیش میبرد، این ابزار بهانه خوبی است تا آیتمهای سئو را به تسکهای قابل تحویل تبدیل کنید.

Seomator وبسایت را Crawl میکند و گزارش جامع آنپیج و آفپیج میدهد. قابلیت مانیتورینگ خودکار و هشدار تغییرات کمک میکند وقتی توسعه یا محتوا چیزی را ناخواسته خراب کرد، زود باخبر شوید؛ مثلا یک noindex اشتباهی، حذف Canonical، یا شکستن ساختار اسکیما بعد از آپدیت قالب.

امکان مقایسه دو دامنه برای تحلیل رقبا مفید است؛ شما میبینید که رقیب در چه لایههایی جلوتر است و کجا میتوان با اصلاحات سریع فاصله را کم کرد. استفاده آموزشی Seomator برای تیمهای کوچک این است که با مفهوم «پایش پیوسته» آشنا شوند؛ سئو یک پروژه یکباره نیست، یک سیستم هشدار زودهنگام میخواهد.

اگر بخواهیم این ابزارها را بر اساس سناریوهای واقعی دستهبندی کنیم، تصویر ساده میشود. برای اسکن سریع صفحه و تشخیص ایرادهای رایج، Seoptimer و Found کافیاند. برای نشاندادن تصویر کلی به مدیران یا شروع جلسه، UpCity و Website Grader مناسباند.

برای ریشهیابی فنی، SiteAnalyzer و Moz Crawl Test نقطه شروع خوبی هستند. برای پایش سازمانی و سایتهای بزرگ، Deepcrawl انتخاب منطقی است. برای ممیزی صفحهمحور و لندینگهای کلیدی، MySiteAuditor بهشما تمرکز لازم را میدهد. برای رفتن به دل دادههای واقعی گوگل، Google Search Console غیرقابل جایگزین است.

برای برنامهریزی محتوا و رقابت، FirstSiteGuide به استراتژی شما جهت میدهد. برای تبدیل گزارش به تسک اجرایی و تقسیم وظایف، SE Ranking با چکلیست و گزارش تیمی کار را ساده میکند و برای مانیتورینگ خودکار و مقایسه دامنهها، Seomator نقش آژیر را بازی میکند.

گام اول، تعریف هدف و شاخصهای سنجش است. دقیقا مشخص کنید چه میخواهید بسنجید: بهبود ایندکس صفحات مقالات، کاهش CLS موبایل، افزایش CTR برای ۲۰ کلیدواژه اصلی، یا اصلاح معماری لینکهای داخلی. بدون هدف، گزارشها پراکنده میشوند.

گام دوم، گرفتن اسنپشات اولیه با Website Grader یا UpCity است تا تصویر کلی داشته باشید. گام سوم، ورود به Google Search Console و استخراج فهرست صفحات Excluded، خطاهای خزش، Core Web Vitals و Queryهای کم CTR. گام چهارم، اجرای Crawl با یک ابزار مانند SiteAnalyzer یا Moz Crawl Test برای یافتن ریدایرکتهای بد، تکراریها، تگهای عنوان مسئلهدار و لینکهای شکسته.

گام پنجم، ممیزی صفحهمحور برای لندینگهای کلیدی با MySiteAuditor جهت اصلاحات دقیق محتوا و تگها. گام ششم، تنظیم چکلیست اقدام در SE Ranking و تقسیم تسکها بین توسعه، محتوا و سئو. گام هفتم، پایش تغییرات و اثر آنها با Seoptimer برای صفحات اصلاحشده و ثبت نتایج قبل و بعد. گام هشتم، در صورت سایت بزرگ، زمانبندی Crawl دورهای در Deepcrawl و تعیین قوانین برای پارامترها و سابدایرکتوریها. گام نهم، بازطراحی تقویم محتوا با FirstSiteGuide بر اساس شکافهای کشفشده و ادغام آن با داده واقعی کنسول. گام دهم، راهاندازی مانیتورینگ خودکار Seomator و تعیین هشدارها برای تگهای حیاتی، Robots، Canonical، و سرعت.

این چرخه را بهشکل ماهانه یا فصلی تکرار کنید؛ بهبود پایدار از تداوم میآید نه از یک ممیزی پر سر و صدا.

سرعت و تجربه کاربری با Core Web Vitals شروع میشود: LCP باید سریع لود شود، CLS نباید طرح را بپراند و INP باید تعاملات را روان نگه دارد. برای رسیدن به این اهداف، بهینهسازی تصاویر، استفاده درست از فرمتهای جدید، بارگذاری تنبل، حذف اسکریپتهای بلاککننده و کوچکسازی CSS و JS ضروری است.

Crawlability و ایندکسپذیری ستون بعدی است؛ فایل robots باید دقیق باشد، نقشه سایت XML مرتب و بهروز بماند، پارامترهای URL کنترل شوند و Canonicalها پیام واضحی بدهند. در لایه محتوا، هدرها باید سلسلهمراتب منطقی داشته باشند، عنوان و توضیح متا با نیت کاربر هماهنگ باشد و طول محتوا پاسخ کامل بدهد؛ نه اینکه صرفاً کلمات را زیاد کند. لینکهای داخلی مسیر را برای ربات و کاربر روشن میکنند؛ صفحات یتیم را حذف کنید و برای هر دسته و خوشه موضوعی، ستونهای محتوایی تعریف کنید. در آفپیج، کیفیت ارجاعها مهم است نه صرفاً تعداد؛ لینک از صفحات مرتبط، قابلاعتماد و با ترافیک واقعی ارزشمند است. اسکیما را فراموش نکنید؛ Article، Product، FAQ، HowTo، Video و Breadcrumb کمک میکنند موتور جستجو ساختار شما را بفهمد و در نتایج غنی نمایش دهد.

در سایتهای آموزشی و مجلهای، سه خطا زیاد دیده میشود:

اول، تکرار عناوین و توضیحات متا به خاطر تمپلیتهای مشابه. راهحل، تولید الگوهای پویا با متغیرهای دسته، موضوع و تاریخ، و کنترل کیفیت دستی برای صفحات مهم است.

دوم، صفحات آرشیو و برچسب که بدون محتوا و با صفحهبندی زیاد ایندکس میشوند و بودجه Crawl را هدر میدهند. راه درست، محدود کردن ایندکس آنها یا بهبود واقعی محتوا و لینکهای داخلی این صفحات است.

سوم، تصاویر بزرگ و بدون فشردهسازی که LCP را بالا میبرند. راهحل، فرمتهای بهینه، ابعاد ثابت در HTML یا CSS و استفاده از Lazy Loading است.

در سایتهای فروشگاهی، مشکل رایج، پارامترهای فیلتر و مرتبسازی است که هزاران URL کمارزش تولید میکند. اینجا باید با قوانین پارامترها، نوفالو داخلی هوشمندانه، Canonical درست و نقشه سایت انتخابی جلو رفت. در سایتهای شرکتی، ریدایرکتهای نادرست بعد از تغییر دامنه یا HTTPS معمولاً مانع رتبهگیری میشود؛ زنجیرهها را قطع کنید، نقشه سایت را بهروز نمایید و بکلینکهای مهم را با ایمیل به صاحبانشان تصحیح کنید.

در تیمهای کوچک، یک نفر همه کارها را انجام میدهد و طبیعی است که فرصت برای ممیزی عمیق کم باشد. راهحل، برنامه هفتگی کوتاه است: دوشنبهها Crawl سبک با SiteAnalyzer، چهارشنبهها بررسی کنسول برای خطاهای جدید، پنجشنبهها بهینهسازی یک صفحه با MySiteAuditor و ثبت قبل و بعد با Seoptimer. هر ماه یکبار، گزارش کلی برای مدیریت با Website Grader یا UpCity آماده کنید و دو بار در سال روی Deepcrawl یا یک Crawl عمیق سرمایهگذاری کنید. در تیمهای بزرگتر، نقشها را تفکیک کنید: توسعه مسئول Core Web Vitals و خزندههای عمیق، محتوا مسئول ساختار هدرها، متا و خوشهها، سئو مسئول لینکهای داخلی، اسکیما و نقشه سایت. SE Ranking را برای ساخت چکلیست مشترک قرار دهید و Seomator را برای هشدارهای خودکار تنظیم کنید تا خطای انسانی به حداقل برسد. هدف این است که ابزارها کارِ شما را سبک کنند، نه اینکه شما برده گزارشها شوید.

FirstSiteGuide به شما میگوید رقبا روی چه موضوعاتی کار کردهاند و کدام کلیدواژهها فرصت هستند. این داده را با گزارش Queries در کنسول جستجو ادغام کنید تا ببینید کجا Impression دارید اما CTR ندارید. سپس با MySiteAuditor همان صفحات را صفحهمحور اصلاح کنید: عنوان جذابتر، توضیح متا واضحتر، افزودن مثال کاربردی، پاسخهای کوتاه و روشن به سوالات متداول.

در سطح سایت، با Moz Crawl Test یا Deepcrawl اطمینان حاصل کنید که صفحات ستون با لینک داخلی کافی از مقالههای خوشه تغذیه میشوند. این هماهنگی بین استراتژی محتوا و سلامت فنی است که رشد پایدار میسازد.

اول، ابزار را جایگزین قضاوت نکنید. هر گزارشی میتواند مثبت یا منفی کاذب داشته باشد. معیار نهایی، داده واقعی کنسول و تجربه کاربر است.

دوم، روی الگوها کار کنید نه تکصفحهها. اگر CLS در دهها URL مشکل دارد، ریشه در قالب است نه محتوا.

سوم، هر تغییر مهم را ثبت کنید؛ تاریخ انتشار، بهروزرسانی، تغییر قالب، جابجایی هاست و حتی کمپینهای روابط عمومی. این تاریخچه در تحلیل افت و خیزهای نمودار به شما کمک میکند.

چهارم، از تست A/B در متاها و عنوانها نترسید؛ CTR به شکل شگفتانگیزی به زبان و وعده حساس است.

پنجم، آموزش تیم را مداوم کنید؛ ابزارها را در جلسات داخلی به شکل زنده اجرا نمایید تا اعضا به گزارشها عادت کنند و ترس از اصطلاحات فنی بریزد.

12 ابزار معرفیشده در این راهنما هر کدام تکهای از پازل هستند: Seoptimer و Found برای نگاه سریع، Website Grader و UpCity برای تصویر کلی، SiteAnalyzer و Moz برای ریشهیابی فنی، MySiteAuditor برای تمرکز صفحهمحور، Search Console برای داده واقعی، FirstSiteGuide برای استراتژی محتوا، Deepcrawl برای مدیریت سایتهای بزرگ، SE Ranking برای تبدیل گزارش به کار اجرایی، و Seomator برای هشدارهای خودکار.

اما آنچه تفاوت میسازد، داشتن یک سیستم است: هدف مشخص، چرخه ممیزی تکرارپذیر، تقسیم نقش روشن، ثبت تغییرات و تکیه بر داده واقعی. اگر این نظام را جا بیندازید، سئو از پروژههای مقطعی به یک «عادت سازمانی» تبدیل میشود. نتیجه هم روشن است: خطاهای پرتکرار کمتر میشوند، بودجه Crawl در مسیر درست خرج میشود، تجربه کاربری بهتر میگردد و رشد ترافیک به جای موجهای کوتاه، آرام و پیوسته میشود.

تهیه شده توسط تیم تخصصی سئو سید احسان خسروی (مدیر، متخصص و مشاور استراتژیک سئو)