اگر بخواهیم بیپرده حرف بزنیم، صفحهی یتیم نتیجهی یک سوءتفاهم قدیمی دربارهی «تولید محتوا»ست: محتوای خوب خودش راهش را پیدا میکند. واقعیت سئوی ۲۰۲۵ این است که هیچ صفحهای بدون پیوندهای داخلی هدفمند، شانس معقولی برای کشف سریع، ایندکس پایدار و رتبهگرفتن ندارد.

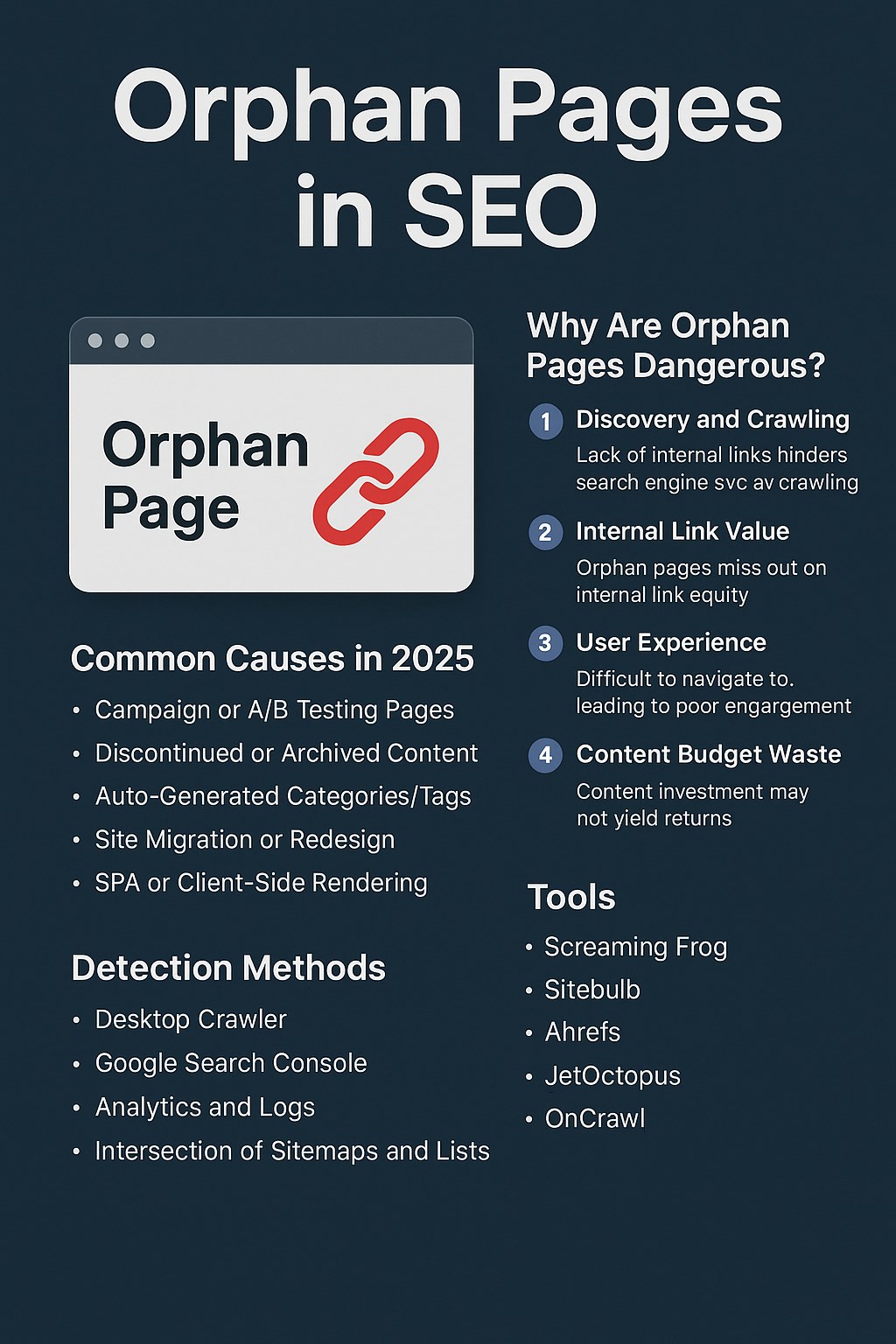

صفحهی یتیم به زبانی ساده، صفحهای است که هیچ مسیر داخلی مستقیم یا غیرمستقیم از دیگر صفحات سایت به آن ختم نمیشود. این یعنی رباتها به دشواری به آن میرسند، سیگنال موضوعی و ارتباطی از شبکهی داخلی دریافت نمیکند و در نهایت، بازگشت سرمایهی محتوایی شما آسیب میبیند.

در این راهنمای جامع، قضیه را از پایه تا اجرا باز میکنیم: نشانهها، ریشهها، روشهای تشخیص عملی، بازیابی و اتصال دوباره و در نهایت یک برنامهی نگهداری دورهای که جلوی بازتولید یتیمی را میگیرد.

خطر اصلی صفحات یتیم (Orphan Pages) کمدیدهشدن نیست، دیر دیدهشدن است. هر چه کشف اولیه و ایندکس به تعویق بیفتد، چرخهی شاخصهای اصلی هم دیرتر روشن میشود: ربات دیرتر برمیگردد، اعتبار داخلی دیرتر تزریق میشود و الگوریتم دیرتر میفهمد این صفحه در کدام خوشهی موضوعی باید قرار بگیرد.

از طرف دیگر، ساختار اطلاعاتی سایت شما مانند یک نقشهی شهر است؛ خیابانهای بنبست و کوچههای بینام، حتی اگر خانههای قشنگی داشته باشند، رفتوآمدی صورت نمیگیرد. نتیجه آن میشود که نرخ تعامل به شکل مصنوعی پایین میماند، اسنیپتها کمتر بهروز میشوند و بودجهی خزش روی مسیرهای بیارزش هدر میرود. در لایهی تجربهی کاربر هم ماجرا ساده است: اگر کاربر از مسیرهای طبیعی ناوبری و پیشنهادهای درونصفحه به این محتوا نرسد، محتوای شما از نظر او اساساً وجود خارجی ندارد. از این رو، یتیمی یک ایراد صرفاً فنی نیست؛ شکاف معماری اطلاعات و شکست استراتژی محتوا و محصول است.

یتیمی در سایتهای امروز فقط با بیدقتی رخ نمیدهد؛ ترکیب روندهای فنی و عملیاتی آن را محتمل میکند. لندینگهای کمپینی که فقط از تبلیغات ورودی میگیرند و به ناوبری اصلی وصل نشدهاند، بعد از پایان کمپین همچنان ایندکس میمانند اما هیچ لینکی به آنها نمیرسد. در فروشگاههای آنلاین، محصولات ناموجود و آرشیوی از کاتالوگ برداشته میشوند ولی صفحهی جزئیات محصول باقی میماند و به جایی راه ندارد. تولید خودکار دستهبندیها و تگها در مدیریت محتوا اگر به منو و فوتر و مسیر کاربر متصل نشود، انبوهی از صفحات کمعمق میسازد که هیچ مسیری به آنها باز نیست.

در ناوبری وجهی، نسخههای پارامتری فیلتر و مرتبسازی اگر بهعنوان صفحهی مجزا ذخیره گردند و سیاست کاننیکال (canonical) درستی نداشته باشند، به سرعت جزیرههای بدون پل میشوند. مهاجرت سایت یا بازطراحی ساختار اطلاعات اگر با نقشهی ریدایرکت و بازچسبانی لینکهای زمینهای همراه نباشد، تعداد زیادی آدرس را از شبکهی اصلی جدا میکند. و نهایتاً در معماریهای SPA و رندر سمت کلاینت، لینکهایی که صرفاً با رویدادهای جاوا اسکریپتی ساخته میشوند اما لنگر HTMLِ واقعی ندارند، برای ربات برابر با نبودن هستند.

برای تشخیص واقعی باید چهار دیدگاه را همزمان ببینید: کراول داخلی، سیگنالهای سرچ کنسول، رفتار واقعی کاربر و ربات در لاگ سرور و تطبیق فهرستهای مرجع.

کراولرهای دسکتاپ یا ابری از صفحهی اصلی حرکت میکنند و هر چه لینک داخلی دارد کشف مینمایند؛ هر آدرسی که در پایگاه داده یا نقشهی سایت هست ولی در این کراول دیده نمیشود، مظنون یتیمی میباشد. در سرچ کنسول، گزارش Page indexing جایی است که آدرسهای Discovered ولی Not indexed پشت سر هم ظاهر میشوند؛ وقتی چنین آدرسی در گزارش لینکهای داخلی هم صفر یا نزدیک به صفر است، مظنون به یقین نزدیک میشود.

در GA4 صفحاتی را که ترافیک مستقیم یا ارجاعی دارند اما هیچ مسیر داخلی به آنها ختم نمیشود علامت بزنید؛ اینها اغلب لندینگهای تبلیغاتی یا صفحات آزمون A/B هستند که به شبکه وصل نشدهاند. لاگ سرور نیز لایهی واقعیت را نشان میدهد: اگر رباتها یا کاربران خارجی چند بار آدرسی را دیدهاند اما کراول داخلی آن را نمییابد، شما با یتیمی مواجهاید.

در نهایت، تقاطع نقشهها و فهرستها تکلیف را روشن میکند: خروجی کراول، XML و HTML sitemap و فهرست URLهای واقعی در CMS را روی هم بیندازید؛ هر آدرسی که فقط روی کاغذ وجود دارد ولی در شبکهی لینکِ داخلی دیده نمیشود، باید زیر تیغ تصمیم برود.

وقتی فهرست آدرسهای یتیم آماده شد، مهمترین کار این است که همه را با یک نسخه درمان نکنید. ابتدا ارزش صفحه را بسنجید: آیا با هدفهای جستجو همخوان است؟ پتانسیل تقاضای جستجو دارد؟ نقش مشخصی در قیف تبدیل بازی میکند؟ با کدام خوشهی موضوعی مینشیند؟ اگر پاسخها مثبت است، صفحه باید احیا شود: بهروزرسانی محتوا، اتصال زمینهای از صفحات قدرتمند مرتبط و اضافهشدن به مسیرهای ناوبری و پیشنهادهای درونصفحه.

اگر پاسخها مبهم یا منفی باشد اما محتوا بخشی از تاریخچهی محصول یا کمپین است، یا آن را با یک صفحهی قویتر ادغام کنید و ریدایرکت ۳۰۱ بدهید، یا اگر واقعاً نیازی به ایندکس ندارد، با noindex نگه دارید و از نقشهی سایت حذف کنید. اگر صفحه اساساً نسخهی پارامتری یا تکثیر تضعیفکننده است، کاننیکال درست را به نسخهی اصلی بدهید و جلوی تولید دوبارهی آن را بگیرید.

این اولویتبندی جلوی دو خطر را میگیرد: هدر دادن لینک داخلی روی صفحات بیارزش و آلودهکردن نقشهی سایت و بودجهی خزش.

وقتی تصمیم به نجات صفحه گرفتید، اتصال آن را با لینکهای زمینهای واقعی انجام دهید، نه با بلوکهای تزیینی که فقط شمارش لینک را بالا میبرند. لینک زمینهای یعنی در متن یک صفحهی مرتبط که خودش ترافیک و اعتبار دارد، بخشی از بحث به شکلی طبیعی به محتوای یتیم برسد و لنگر متن معنیدار باشد. اگر خوشهی موضوعی دارید، صفحهی قطب را نقطهی اول بگذارید و از چند مقالهی ستون فرعی به صفحهی احیاشده پیوند دهید.

بردکرامب را فعال کنید تا مسیر بالادستی همیشه برقرار باشد. در سری محتواها، پیوند قبلی و بعدی کمک میکند ربات و کاربر مسیری خطی داشته باشند. در صفحات محصول، ماژولهای پیشنهاد مرتبط را به جای الگوریتم صرفاً مبتنیبر «جدیدترینها»، به الگوریتم موضوعی و رفتار کاربر متصل کنید تا پیوندها ارزش معنایی داشته باشند. در ساختار منو و فوتر هم به جای پرتاب لینک به همهجا، حداقل یک مسیر سطحی و کنترلشده به صفحهی احیاشده بدهید تا ربات در بازدیدهای بعدی سریع به آن برسد.

در سایتهای مبتنیبر فریمورکهای مدرن، یتیمی گاهی حاصل این فرض است که «گوگل جاوا اسکریپت را میفهمد، پس هر نوع لینکی را میبیند». واقعیت این است که ربات با لینک HTML معمولی راحتتر و پایدارتر کار میکند. اگر ناوبری شما با رویدادهای کلیک سفارشی روی عناصر غیرلنگر ساخته شده، برای ربات برابر با نبودن است. در SPAهایی که محتوای صفحه در سمت کلاینت رندر میشود، تأخیر رندر میتواند کشف پیوندها را عقب بیندازد.

راهحلهای عملی عبارتند از استفاده از لنگرهای واقعی با href و وضعیت فوکوس قابل دسترس، رندر سمت سرور یا رندر هیبریدی برای بخشهای مسیر و تولید sitemap که فقط آدرسهای ایندکسپذیر را پوشش دهد. همچنین در ناوبری وجهی فروشگاهها، صفحههای فیلتر و مرتبسازی را با سیاست مشخص کاننیکال مدیریت کنید و جلوی تبدیلِ آنها به جزیرههای بیمصرف را بگیرید.

نقشهی سایت برای کشف اولیه مفید است، اما جایگزین شبکهی لینک داخلی نمیشود. وقتی آدرسی فقط در sitemap دیده میگردد و هیچ لینک داخلی ندارد، ربات نهایتاً آن را کشف میکند، اما سیگنال ارتباطی و اولویت خزش ندارد. بهترین عمل آن است که sitemap خروجی سیستم مدیریت محتوا را پاکسازی کنید تا فقط آدرسهای ایندکسپذیر و زنده در آن بماند، تاریخ آخرین تغییر واقعاً بهروز باشد و آدرسهایی که noindex یا ریدایرکت شدهاند به سرعت حذف شوند. sitemap باید آینهی سیاست ایندکسپذیری باشد، نه لیست کامل هر چیزی که روزی ساخته شده است.

نشانههای درست را دنبال کنید. در سرچ کنسول، کاهش آدرسهای Discovered but not indexed در کنار رشد تعداد لینکهای داخلی برای همان آدرسها، علامت خوبی است. در گزارش Crawl stats اگر مسیرهای مربوط به خوشهی احیاشده سهم بیشتری از خزش بگیرند، یعنی شبکهی شما برای ربات قابل پیمایشتر شده.

در نمودار Impression و Click انتظار رشد آهسته اما پیوسته در بازهی ۴ تا ۸ هفته منطقی است؛ سرعت آن بستگی به رقابت موضوع دارد. در لایهی تجربهی کاربر، کاهش خروج از صفحه در مسیرهای موضوعی و افزایش عمق پیمایش نشانهی این است که اتصالهای زمینهای کار میکنند.

اگر همهی اینها را میبینید اما رتبهگیری هنوز کند است، اغلب پای هممعنایی و کیفیت محتوا در میان است: متن را با پرسشهای واقعی کاربر و دادههای تازه بهروز کنید، نیت جستجو را دقیقتر هدف بگیرید و تخصص و اعتبار نویسنده را روشنتر نشان دهید.

صفحات یتیم در سایتهای پویا دوباره ساخته میشوند. بهترین دفاع، یک برنامهی نگهداری ساده اما منظم است. ماهانه یک اسکن سبک از بخشهای جدید داشته باشید تا آدرسهای تازهی بدون لینک را سریع بگیرید. هر فصل یک کراول کامل بگیرید، خوشهها را بازبینی کنید، منو و فوتر را با رشد واقعی محتوا هماهنگ کنید و sitemap را پاکسازی کنید. بعد از هر کمپین بزرگ یا انتشار محصول، پیش از آنکه آدرسهای موقت در ایندکس تهنشین شوند، تکلیف اتصال داخلی یا سیاست noindex را روشن کنید. حتی یک چکلیست ساده هنگام انتشار محتوا که شامل محلهای لینکدهی از صفحات موجود، افزودن به مجموعههای پیشنهاد مرتبط و بررسی نمایش در مسیرهای ناوبری است، از تولید صفحات یتیم جلوگیری میکند.

در فروشگاهها یتیمی به شکلهای خاصی ظاهر میشود. صفحهی محصولی که موقتاً ناموجود میشود اگر از شبکه حذف شود، اما ایندکس باقی بماند، یتیم و بیاستفاده است. سیاست بهتر این است که صفحه را زنده نگه دارید، وضعیت موجودی را روشن نشان دهید، گزینههای جایگزین پیشنهاد دهید و اتصال آن را به دسته و مقالات راهنمای مرتبط حفظ کنید. اگر محصول برای همیشه حذف شده، از ریدایرکت ۳۰۱ به نزدیکترین جایگزین استفاده کنید و از sitemap بیرون بکشید.

در دستهبندیهای عمیق، اگر عمق کلیک تا محصول از سه سطح بیشتر شد، به ناوبری میانبر فکر کنید: دستههای موضوعی میانی، فیلترهای محبوب که مسیر کوتاهشده میسازند و ماژولهای پیشنهاد هوشمند که کاربران را از صفحات پرترافیک به نقاط عمیق میبرند.

در سایتهای چندزبانه، گاهی نسخههای زبانی یا محلیسازیشده فقط از طریق hreflang به هم وصل میشوند و مسیر داخلی مستقل ندارند. hreflang جایگزین لینک داخلی نیست؛ هر نسخه باید در شبکهی داخلی همان زبان جایگاه طبیعی داشته باشد. منوهای زبانمحور، صفحات قطب مشترک با پیوندهای نسخهای و ماژولهای پیشنهاد مرتبط مخصوص هر زبان، جلوی به وجود آمدن صفحات یتیم را میگیرند. همچنین مراقب باشید نسخههای غیرفعال یا محتوای نیمهترجمهشده که از منو حذف شدهاند اما در sitemap ماندهاند، تولید یتیمی نکنند.

در محتواهای خبری یا تحلیلی، پنجرهی طلایی دیدهشدن کوتاه است. اگر مطلب در چند ساعت اول اتصالهای زمینهای از صفحات ستونی و صفحات موضوعی نگیرد، ممکن است دیر وارد چرخهی پیشنهادها شود. در وبلاگهای تحلیلی، هر مطلب جدید باید به روشنترین صفحهی قطب متصل شود و از دو یا سه مقالهی ستون فرعی مرتبط لینک بگیرد. در مقابل، صفحات قدیمی اگر با انتشارهای جدید بهروز نشوند و لینکهای تازه دریافت نکنند، به تدریج از شبکه کنار میروند و عملاً یتیم میشوند؛ مرگ آرام محتوا معمولاً از همینجا شروع میشود.

ریشهی یتیمی اغلب در شکاف همکاری بین تیمهاست: بازاریابی کمپین میسازد، اما تیم محتوا برای اتصال داخلی در جریان نیست؛ توسعهدهنده ناوبری را میشکند و خبرش به سئو نمیرسد؛ محصول دستهبندی جدید معرفی میکند ولی منو بهروز نمیشود. راهحل، فرآیند است نه قهرمان.

یک فرم انتشار که فیلدهای مسیرهای پیونددهی پیشنهادی، لنگرهای هدف و جایگاه در خوشهی موضوعی را اجباری کند، کیفیت اتصال را بالا میبرد. داشبوردی که هر ماه صفحات کملینک و آدرسهای Discovered but not indexed را نشان دهد، مسئولیتپذیری میآورد. و یک قانون ساده که هیچ آدرس ایندکسپذیری بدون حداقل دو لینک زمینهای منتشر نمیشود، جلوی بخش بزرگی از یتیمی را میگیرد.

بزرگترین خطا افزودن لینکهای فلهای و غیرمرتبط است؛ شمارش لینک ممکن است بالا برود، اما سیگنال موضوعی تضعیف میشود و تجربهی کاربر بدتر. خطای رایج دیگر اتکا به بلوکهای دینامیک است که رباتها نادیده میگیرند یا دیر میبینند: اسلایدرهای تنبل، تبهای پنهان یا عناصر تعاملی بدون لنگر HTML.

اشتباه سوم نگهداشتن آدرسهای بیارزش در sitemap است که به ربات وعدهی پوچ میدهد و بودجهی خزش را میسوزاند. و نهایتاً، اعتماد بیش از حد به اینکه «گوگل جاوا اسکریپت را میفهمد» به قیمت نادیدهگرفتن اصول دسترسی و لینک استاندارد، سالهاست که تیمها را گرفتار میکند.

اول، فهرست مرجع بسازید: خروجی آدرسهای زنده از CMS، آخرین نسخهی sitemap و فهرست ایندکسشده را کنار هم قرار دهید. دوم، یک کراول کامل از هوم بگیرید تا شبکهی واقعی لینک داخلی را ببینید. سوم، در سرچ کنسول صفحات Discovered but not indexed را برای همین دامنه استخراج کنید و با فهرست کراول تطبیق دهید. چهارم، از GA4 صفحاتی را که ورودی مستقیم یا ارجاعی دارند اما مسیر داخلی ندارند بیرون بکشید. پنجم، تقاطع این فهرستها را بسازید و برچسب بزنید: احیایی، ادغامی، حذف یا noindex. ششم، برای صفحات احیایی برنامهی اتصال بنویسید: از کدام صفحات مبدأ، با چه لنگرهایی و در کدام پاراگرافهای طبیعی. هفتم، منو، فوتر، بردکرامب و پیشنهادهای مرتبط را بهروز کنید تا مسیرهای سطحی و عمیق هر دو برقرار باشند. هشتم، دوباره کراول بگیرید و نتایج را با گزارشهای سرچ کنسول و Crawl stats (آمار کراول یا خزیدن) تطبیق دهید. این چرخه را هر فصل تکرار کنید تا یتیمی مزمن نشود.

گاهی صفحهای را احیا میکنید، لینکهای خوبی هم میگیرد، اما هنوز کند جلو میرود. مسأله اغلب محتوایی است: نیت جستجوی کاربر به درستی هدف گرفته نشده، یا محتوا به پرسشهای ضمنی پاسخ نمیدهد، یا تخصص و اعتبار نویسنده شفاف نشان داده نشده است. در ۲۰۲۵ حساسیت به اصالت و تجربهی واقعی بیشتر شده است. نشان دهید چرا این محتوا به دست شخص یا تیمی نوشته شده که واقعاً با موضوع سر و کار دارد، منابع را تحلیل کنید (نه صرفاً فهرست)، تاریخ بهروزرسانی را واقعی نگه دارید و نشانههای اعتبار را قابل مشاهده کنید. لینک داخلی سوخترسان است؛ موتور اما همچنان کیفیت، ارتباط و تجربه است.

یک شیوهی ساده پاسخگو نگه میدارد: داشبوردی که در آن برای هر خوشهی موضوعی، میانگین لینک داخلی هر صفحه، تعداد صفحات Discovered but not indexed و سهم خزش مسیر مربوطه دیده شود. اگر میانگین لینک داخلی در خوشه پایینتر از حد هدف باشد، به سرعت متوجه میشوید کجا اتصال کم است.

اگر صفحات Discovered but not indexed افزایش پیدا کنند، اولین جایی که نگاه میکنید sitemap و سیاست ایندکسپذیری است. و اگر سهم خزش مسیر پایین بماند، شاید عمق کلیک زیاد است یا لینکها در عناصر غیرقابل دسترس پنهان شدهاند.

سنجش موفقیت در احیای صفحات یتیم فقط با نگاهکردن به «لیست URLها» تمام نمیشود. معیارهای کلیدی مثل Crawl Stats (افزایش نرخ خزش صفحات اصلاحشده)، Internal Links (رشد میانگین پیوندهای داخلی باکیفیت برای هر صفحه) و سیگنالهای سرچ کنسول گوگل (کاهش صفحات Discovered but not indexed و افزایش Impression و Click) ابزارهای واقعی برای قضاوت هستند. این دادهها نشان میدهند که صفحه نه تنها دوباره کشف شده، بلکه در شبکهی موضوعی سایت جای گرفته و در مسیر جستجوی کاربر فعال است.

صفحات یتیم به ما یادآوری میکنند که سئو پروژهای مقطعی نیست؛ یک سیستم زنده و پویاست که همواره نیاز به مراقبت دارد. محتوا، محصول، تبلیغات، توسعه و حتی ساختار تیمی، همگی میتوانند به سادگی جزیرههایی بدون پل بسازند. اما با چارچوب درست، این جزیرهها به شبکه بازگردانده میشوند.

هر بار که صفحهای منتشر میکنید، سه پرسش ساده اما بنیادین باید پاسخ داده شود:

این صفحه در کدام خوشهی موضوعی قرار میگیرد؟

از کدام صفحات باید به آن برسیم؟

کاربر بعد از ورود به این صفحه به کجا هدایت میشود؟

اگر این چرخهی طراحی، پیادهسازی و ارزیابی به صورت پایدار اجرا شود، صفحات یتیم از یک مشکل پنهان و هزینهساز به فرصتی برای رشد و تقویت ساختار سایت تبدیل میشوند. یتیمی، بهجای آنکه تهدیدی برای بودجهی خزش و تجربهی کاربر باشد، به یک شاخص عملیاتی برای سلامت معماری اطلاعات بدل میگردد.

در نهایت، سایتهایی در ۲۰۲۵ موفقاند که معماری خود را «زنده» نگه میدارند: هر صفحه نه تنها دیده میشود، بلکه در شبکهی معنا و تجربه جایگاه دارد؛ و این همان نقطهای است که سئو از سطح فنی به سطح استراتژیک ارتقا پیدا میکند.

تهیه شده توسط تیم تخصصی سئو سید احسان خسروی (مدیر، متخصص و مشاور استراتژیک سئو)