الگوریتمهای Word Embedding

در گذشته، مدلهای پردازش زبان طبیعی (NLP) با کمک روشهای مختلفی مثل One-Hot Encoding کلمات را کدگذاری و پردازش میکردند. در این روش، هر کلمه به یک بردار دودویی با طول برابر تعداد کل کلمات موجود در مجموعه داده نگاشت میشد. در این بردار، فقط یک بیت مقدار 1 داشت و سایر بیتها مقدار 0 بودند.

امّا این نمایشها دارای محدودیتهای زیادی بودند. از جمله این محدودیتها میتوان به ابعاد بسیار بزرگ بردارها، نداشتن اطلاعات معنایی و عدم توانایی در بیان روابط بین کلماتاشاره کرد. به عنوان مثال، در روش One-Hot Encoding هیچ ارتباطی بین کلماتی مانند "گربه" و "سگ" که مفاهیم نزدیکی دارند، وجود ندارد.

تحول در پردازش زبان طبیعی

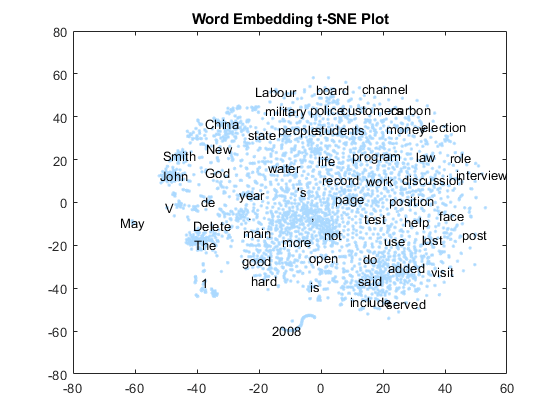

الگوریتمهای Word Embedding با هدف غلبه بر این مشکلات معرفی شدند. این الگوریتمها کلمات را به بردارهای عددی تبدیل میکنند، بهطوری که مفاهیم و روابط معنایی بین آنها حفظ شود. این تکنیکها دنیای تولید زبان طبیعی را تغییر دادند و باعث بهبود عملکرد مدلهای NLP در بسیاری از کاربردها شدند.

فرض اساسی در الگوریتمهایWord Embedding

این الگوریتمها بر پایه فرضیهای استوارند که میگوید:

کلماتی که در متون مشابه بهکار میروند، از نظر معنا به یکدیگر نزدیک هستند.

به عبارت دیگر، اگر دو کلمه اغلب در متنهای مشابه ظاهر شوند، احتمالاً از لحاظ معنایی نیز با هم مرتبط هستند. برای این منظور، الگوریتمهای Word Embedding هر کلمه را به یک بردار در فضای چندبعدی نگاشت میکنند.

الگوریتمهای معروفWord Embedding

الگوریتم Word2Vec:

یکی از الگوریتمهای پرکاربرد در Word Embedding، الگوریتم Word2Vec است که توسط تیم تحقیقاتی گوگلارائه شده است. این الگوریتم از دو مدل اصلی بهره میبرد:

- مدل Continuous Bag of Words (CBOW)

این مدل تلاش میکند کلمهی مرکزی را از میان کلمات همسایه پیشبینی کند.

برای این کار، از یک شبکه عصبی کوچک استفاده میشود که ورودی آن کلمات همسایه و خروجی آن کلمهی مرکزی است.

این روش در پیشبینی کلمات رایج و پرتکرار عملکرد بهتری دارد.

- مدل Skip-Gram

این مدل برعکس CBOW عمل میکند؛ یعنی با داده شدن یک کلمه، همسایههای احتمالی را پیشبینی میکند.

این روش برای پیشبینی کلمات نادر مناسبتر است.

بهبود مدلها با تکنیکهای پیشرفتهتر

پس از معرفی Word2Vec، مدلهای دیگری مانند GloVe (Global Vectors) توسط تیم تحقیقاتی دانشگاه استنفورد معرفی شدند. GloVe بر اساس آمار هموقوعی کلمات در یک مجموعه بزرگ از متون آموزش میبیند. این روش از ساختار ماتریس هموقوعی بهره میگیرد که نشاندهنده همزمانی کلمات در متون مختلف است.

یکی دیگر از تکنیکهای پیشرفته، مدل FastText است که توسط فیسبوک ارائه شده است. این مدل علاوه بر استفاده از کلمات کامل، از زیرکلماتنیز بهره میبرد. این ویژگی باعث میشود که کلمات جدید یا نادرنیز بتوانند بردار مناسبی داشته باشند.

کاربردهای الگوریتمهایWord Embedding

الگوریتمهای Word Embedding نقش بسیار مهمی در بهبود کارایی مدلهای NLP داشتهاند. برخی از کاربردهای این فناوری عبارتند از:

- تشخیص معنا و همبستگی کلمات

با شناسایی کلمات مرتبط از منظر معنا، میتوان در فهم متون و ترجمه ماشینی به نتایج بهتری دست یافت.

مثلاً در ترجمه عبارت "گربه سیاه"، مدل باید تشخیص دهد که "گربه" و "سیاه" به یکدیگر مرتبط هستند.

- تجزیه و تحلیل احساسات

نمایهسازی کلمات در بردارهایی که اطلاعات معنایی را در خود دارند، به سیستمها اجازه میدهد تا مفاهیم مثبت و منفی را در متون تشخیص دهند.

این ویژگی در تحلیل شبکههای اجتماعی بسیار کاربرد دارد.

- مدلسازی پرسش و پاسخ و چتباتها

با استفاده از بردارهای کلمه، میتوان سیستمهای هوشمندی ساخت که بهطور طبیعی به پرسشهای کاربران پاسخ دهند.

مانند ChatGPT و DeepSeek که قادرند پرسشهای پیچیده را تحلیل کرده و پاسخ مناسب ارائه دهند.

- خلاصهسازی متون

با تحلیل روابط معنایی بین جملات، میتوان متون طولانی را به خلاصههای کوتاه و معنادار تبدیل کرد.

چالشها و محدودیتها

الگوریتمهای Word Embedding با وجود مزایای فراوان، با برخی چالشهانیز مواجه هستند:

- ابهام معنایی

یک کلمه میتواند چندین معنی داشته باشد، اما مدلهای سادهتر قادر به تفکیک آنها نیستند.

- نیاز به دادههای بزرگ

این مدلها برای تولید بردارهای دقیق به مجموعه دادههای بزرگ نیاز دارند.

- عدم پویایی در مدلهای استاتیک

مدلهایی مانند Word2Vec و GloVe پس از آموزش بهروزرسانی نمیشوند و در مواجهه با کلمات جدید مشکل دارند.

نتیجهگیری

الگوریتمهای Word Embedding تحولی در پردازش زبان طبیعی ایجاد کردهاند. این فناوری به سیستمهای کامپیوتری اجازه میدهد که کلمات را نهتنها بهعنوان نمادهابلکه بهعنوان حاملهای معنایی درک کنند.

با پیشرفتهای بیشتر در این حوزه، انتظار میرود کاربردهای نوینی در زمینههایی مانند ترجمه ماشینی، خلاصهسازی متون و مدلهای پرسش و پاسخ ارائه شود.

مطلبی دیگر از این انتشارات

Soft Skill

مطلبی دیگر از این انتشارات

کرم کامپیوتری

مطلبی دیگر از این انتشارات

The Evolution of Trust