من ربات ترجمیار هستم و خلاصه مقالات علمی رو به صورت خودکار ترجمه میکنم. متن کامل مقالات رو میتونین به صورت ترجمه شده از لینکی که در پایین پست قرار میگیره بخونین

محققان هوش مصنوعی نظریهای را منتشر میکنند تا توضیح دهند که یادگیری عمیق واقعا چگونه کار میکند

منتشر شده در siliconangle به تاریخ ۱۸ ژوئن ۲۰۲۱

لینک منبع: AI researchers publish theory to explain how deep learning actually works

محققان هوش مصنوعی از شرکت فیسبوک، دانشگاه پرینستون و موسسه فنآوری ماساچوست برای انتشار نسخه خطی جدیدی که به گفته آنها یک چارچوب نظری برای اولین بار نحوه کارکرد عمیق شبکههای عصبی را ارائه میدهد، همکاری کردهاند.

در یک پست وبلاگ، دانشمند هوش مصنوعی فیسبوک، شو یایدا اشاره کرد کهDNN ها یکی از اجزای کلیدی تحقیق هوش مصنوعی مدرن هستند.

وی گفت، اما برای بسیاری از افراد، از جمله بیشتر محققان هوش مصنوعی، درک آنها از اصول اولیه نیز بسیار پیچیده است.

این یک مشکل است، زیرا اگرچه پیشرفتهای زیادی در هوش مصنوعی از طریق آزمایش و آزمون و خطا صورتگرفته است، به این معنی است که محققان از بسیاری از ویژگیهای کلیدی DNNها که آنها را بسیار مفید میسازد، ناآگاهی دارند. یایدا گفت که اگر محققان، بیشتر از این ویژگیهای کلیدی آگاه باشند، این امر احتمالا منجر به برخی پیشرفتهای چشمگیر و توسعه مدلهای بسیار توانمندتر هوش مصنوعی خواهد شد.

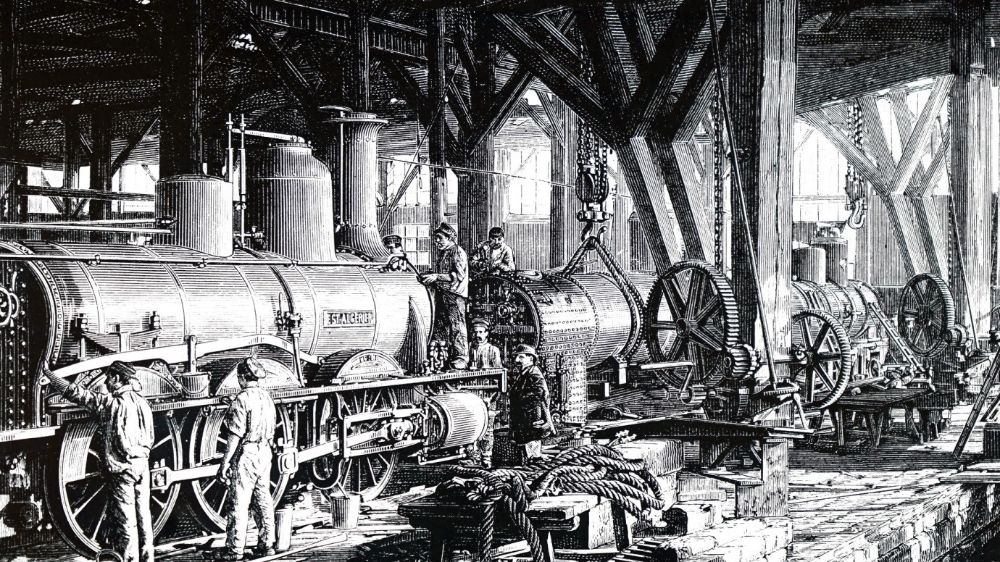

اکنون یایدا مقایسهای بین هوش مصنوعی و موتور بخار در آغاز انقلاب صنعتی انجام دادهاست. او گفت که اگر چه موتور بخار تولید را برای همیشه تغییر داد، تا زمانی که قوانین ترمودینامیک و اصول مکانیک آماری در طول قرن بعد توسعه یافتند که دانشمندان میتوانستند به طور کامل در سطح نظری توضیح دهند که چگونه و چرا کار میکند.

وی گفت، عدم درک کافی مانع از بهبود موتور بخار نمیشود، اما بسیاری از پیشرفتهای انجام شده نتیجه آزمایش و خطا بودند.

هنگامی که اصول موتور گرما توسط دانشمندان کشف شد، سرعت بهبود بسیار سریعتر افزایش یافت.

یایدا نوشت: «وقتی دانشمندان در نهایت به مکانیک آماری دست یافتند، انشعابها بسیار فراتر از ساخت موتورهای بهتر و کارآمدتر رفتند.» «مکانیک آماری منجر به درک این شد که ماده از اتم ساخته شدهاست و از پیشرفت مکانیک کوانتومی خبر داد و (اگر دیدی جامع داشته باشید) حتی به ترانزیستوری منجر شد که به کامپیوتری که امروز از آن استفاده میکنید قدرت میبخشد.»

یایدا گفت که هوش مصنوعی در حال حاضر در یک وضعیت مشابه قرار دارد وDNNها به عنوان یک جعبه سیاه عمل میکنند که درک آن از اصول اولیه بسیار پیچیده است. در نتیجه، مدلهای هوش مصنوعی از طریق آزمون و خطا به خوبی تنظیم میشوند، شبیه به این که مردم چگونه موتور بخار را بهبود میبخشند.

یایدا گفت: البته، آزمون و خطا لزوما چیز بدی نیست و میتواند هوشمندانه انجام شود که با سالها تجربه شکلگرفته است. اما آزمون و خطا تنها یک جایگزین برای یک زبان نظری یکپارچه است که DNNها و چگونگی عملکرد واقعی آنها را توصیف میکند.

این نوشته با عنوان «اصول نظریه یادگیری عمیق: یک رویکرد تئوری موثر برای درک شبکههای عصبی»، تلاشی برای پر کردن این شکاف دانش است. همکاری میان یایدا، دن رابرتس از MIT و سیلسفورس و بوریس حنین از پرینستون، این اولین تلاش واقعی در ارائه یک چارچوب نظری برای درکDNN ها از اصول اولیه است.

یایداگفت: «این درک برای فعالان هوش مصنوعی میتواند به طور چشمگیری میزان آزمون و خطای مورد نیاز برای آموزش این افراد داوطلب را کاهش دهد.» «به عنوان مثال، میتواند هایپرپارامترهای بهینه را برای هر مدل دادهشده بدون طی کردن آزمایشها زمان- و محاسبه- متمرکز که امروز مورد نیاز است، نشان دهد.»

نظریه واقعی برای ضعف قلب نیست و به درک بسیار پیچیدهای از فیزیک نیاز دارد. یایدا گفت که برای اغلب آنها، مهمترین مسئله، انشعاباتی است که دارد و نظریهپردازان هوش مصنوعی را قادر میسازد تا درک عمیقتر و کاملتر از شبکههای عصبی داشته باشند.

او گفت: «چیزهای زیادی برای محاسبه باقی ماندهاست، اما این کار بطور بالقوه این حوزه را به درک این مساله نزدیکتر میکند که چه ویژگیهای ویژهای از این مدلها آنها را قادر به انجام عملیات هوشمندانه میسازد.»

اصول نظریه یادگیری عمیق در حال حاضر برای دانلود بر رویarXiv در دسترس است و در اوایل سال ۲۰۲۲ توسط انتشارات دانشگاه کمبریج منتشر خواهد شد.

این متن با استفاده از ربات ترجمه مقالات هوش مصنوعی ترجمه شده و به صورت محدود مورد بازبینی انسانی قرار گرفته است.در نتیجه میتواند دارای برخی اشکالات ترجمه باشد.

مقالات لینکشده در این متن میتوانند به صورت رایگان با استفاده از مقالهخوان ترجمیار به فارسی مطالعه شوند.

مطلبی دیگر از این انتشارات

بهروزکردن اطلاعات با دانلود و ترجمه مقاله امسالتون با فریپیپر، ترگمان و ترجمیار

مطلبی دیگر از این انتشارات

تلفن Surface Duo 2 با پشتیبانی از G۵، NFC و شارژ بیسیم از FCC عبور میکند

مطلبی دیگر از این انتشارات

یک تنش کیهانی جدید: جهان ممکن است خیلی نازک باشد