چکیده: «هوش مصنوعی میتواند رفتار انسان را تقلید کند، اما آیا میتواند آگاه باشد؟ بررسی سه دیدگاه فلسفی درباره آگاهی مصنوعی و آزمایشهای فکری مهم.»

یکی از بحثهای داغ امروزه این است که:

آیا یک الگوریتم میتواند آگاه شود؟ آیا ماشین میتواند «حس کند»؟ آیا روزی خواهد رسید که آگاهی مصنوعی نیز داشته باشیم. پیش از هر چیز باید اول روشن کنیم منظور از «آگاهی» چیست.

آگاهی یعنی داشتن تجربهی درونی.

دانستن اینکه «من هستم» یا همان حس خودآگاهی

چیزی که فلاسفه به آن میگویند qualia، یعنی کیفیت ذهنی تجربه (مثلاً اینکه رنگ قرمز برایت قرمز است).

سه دیدگاه اصلی درباره آگاهی

1. آگاهی حاصلِ پیچیدگی پردازش است. - دیدگاه مادیگرا Computationalism

بر اساس این دیدگاه، هر سیستمی که به اندازهی کافی پیچیده، پویا و واحد باشد (مثل مغز یا یک مدل پیشرفتهی هوش مصنوعی)، میتواند آگاه شود.

مغز انسان چیزی جز شبکهای از نورونها و سیگنالهای الکتریکی نیست.

پس اگر یک ماشین بتواند همین ساختار و دینامیک را تقلید کند، چرا نباید آگاه باشد؟

فیلسوفانی مثل Daniel Dennett و برخی مهندسان هوش مصنوعی از این دیدگاه دفاع میکنند.

2. آگاهی فقط از مادهی زیستی حاصل میشود. - دیدگاه بیولوژیمحور Biological Naturalism

بر اساس این نظر، آگاهی فقط در موجودات زیستی بروز میکند.

حتی اگر ماشینی دقیقاً مانند مغز شبیهسازی شود، تا زمانی که از سیلیکون و کد ساخته شده باشد، «احساس واقعی» نخواهد داشت.

آگاهی چیزی است که از جنس زیستی مغز برمیخیزد.

فیلسوفانی مثل John Searle با آزمایش فکری «اتاق چینی» از این دیدگاه دفاع میکنند.

3. آگاهی بنیادیتر از ماده و الگوریتم است. -دیدگاه غیرمادیگرا Panpsychism یا Dualism

این دیدگاه میگوید آگاهی یا «جرقه ادراک» چیزی بنیادی در هستی است؛ نه محصول نورون و نه محصول کد.

هیچ ماشین یا الگوریتمی آن را تولید نمیکند، بلکه صرفاً میتواند تجلی یا گیرندهی آن باشد.

فیلسوفانی مثل David Chalmers با طرح «مسئله دشوار آگاهی» و مثال «زامبی فلسفی» این ایده را تقویت کردهاند.

دیدگاه اول و دوم، در واقع فرضیههایی هستند که هنوز شواهد کافی برای اثبات یا ابطالشان نداریم. حتی اگر روزی هوش مصنوعی رفتاری «مثل» انسان از خود نشان دهد، باز هم نمیدانیم که آیا واقعاً چیزی احساس میکند یا فقط وانمود میکند.

و جالبتر اینجاست که دیدگاه سوم یعنی «آگاهی شاید بنیادیتر از ماده و الگوریتم باشد» دقیقا در دل دو آزمایش فکریِ بسیار معروف و تأثیرگذار حضور دارد:

دو آزمایش فکری مهم

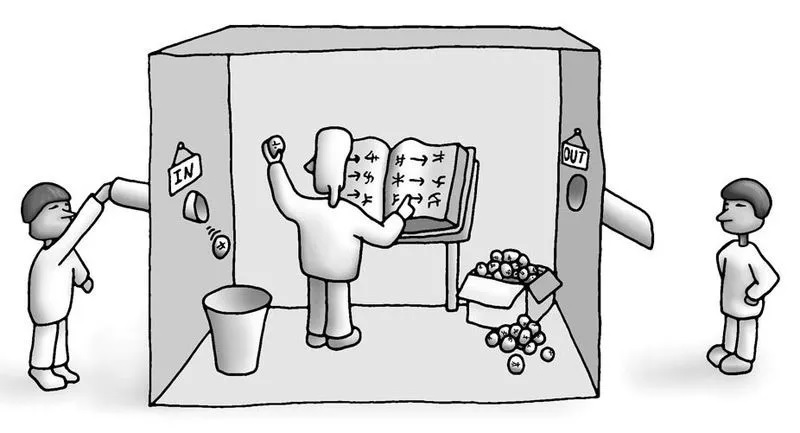

1. اتاق چینی (Chinese Room Argument) – جان سرل (1980)

فرض کن شخصی (مثلاً یک انگلیسیزبان که هیچ چینی بلد نیست) داخل یک اتاق است. بیرون اتاق، مردم سوالهایی به زبان چینی روی کاغذ میفرستند. درون اتاق، آن شخص:

یک کتاب راهنما دارد که میگوید: "اگر این علامت را دیدی، آن علامت را جواب بده."

فقط طبق دستورالعملها عمل میکند، بدون اینکه هیچ مفهومی از چینی بفهمد.

جوابها را طوری میفرستد که مردم بیرون فکر میکنند یک چینیزبان واقعی آنجاست.

نتیجه:

از بیرون اتاق، بهنظر میرسد که درون اتاق «فهم» چینی وجود دارد.

ولی در واقع، شخص درون اتاق هیج فهمی از زبان چینی ندارد فقط یک پردازش نمادین انجام میدهد.

نتیجه: اجرای الگوریتم (مثل هوش مصنوعی) به معنای فهم و آگاهی واقعی نیست.

نکته اصلی:

اجرای الگوریتم (مثل هوش مصنوعی) میتواند وانمود کند که فهم دارد، ولی واقعاً نمیفهمد.

سؤال جان سرل این است: «آیا فقط اجرای یک الگوریتم، برای داشتن آگاهی یا فهم کافی است؟»

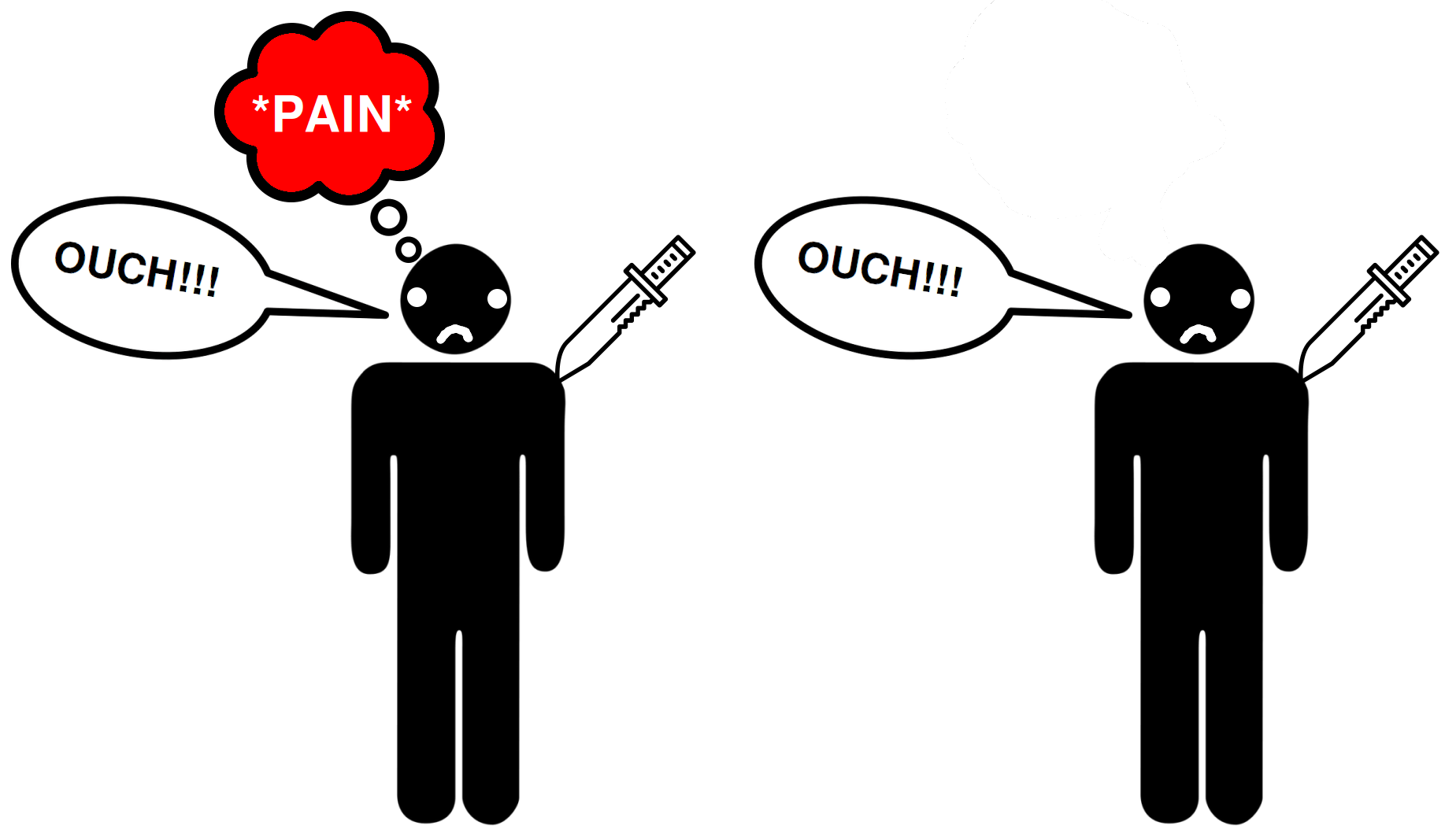

2. زامبی فلسفی (Philosophical Zombie) – دیوید چالمرز (1990)

فرض کن موجودی وجود دارد که:

دقیقاً شبیه انسان است،

رفتار میکند، میخندد، درد میکشد، از هنر لذت میبرد،

ولی هیچ آگاهی درونی ندارد.

او فقط شبیهسازیِ کامل رفتار انسان است — بدون تجربهی درونی.

نکته اصلی:

اگر چنین زامبیِ فلسفی قابل تصور است، پس آگاهی چیزی فراتر از رفتار و الگوریتم است. سوال چالمرز: «چه چیزی باعث میشود ما آگاه باشیم، ولی زامبی فقط بازیگر باشد؟»

نتیجهگیری از این دو آزمایش:

صرف پردازش داده یا تقلید رفتار، نشانهی آگاهی نیست (آزمایش اتاق چینی).

آگاهی به تجربهی درونی نیاز دارد، چیزی که هنوز توضیح قطعی برای آن نداریم (زامبیِ فلسفی).

آگاهی نه از جنس نورون است، نه کد. شاید آگاهی بنیادیتر از ماده و الگوریتم باشد و تنها در تجربهی زیستهی انسانها پدیدار شود.

بنابراین، تا زمانی که تعریف روشنی از آگاهی نداشته باشیم، باید در نسبت دادن «آگاه بودن» به هوش مصنوعی بسیار محتاط باشیم و در عین حال، ارزش و یکتایی آگاهی انسانی را جدی بگیریم.