این سند به بررسی جامع ترجمه ماشینی (MT)، معماریهای زیربنایی آن و روشهای پیشرفته تولید متن میپردازد. ترجمه ماشینی، که هدف آن ترجمه خودکار از یک زبان به زبان دیگر است، عمدتاً بر پایه معماری رمزگذار-رمزگشا (Encoder-Decoder) استوار است. این معماری که با شبکههای عصبی بازگشتی (RNNs) یا ترنسفورمرها پیادهسازی میشود، یک دنباله ورودی را به یک نمایش زمینهمند (Context) فشرده کرده و سپس رمزگشا از این نمایش برای تولید دنباله خروجی استفاده میکند.

یکی از چالشهای اصلی در ترجمه، واگراییهای زبانی است که شامل تفاوت در ترتیب کلمات (مانند زبانهای SVO در مقابل SOV)، واگراییهای واژگانی (مانند شکافهای واژگانی)، تفاوتهای صرفی و چگالی ارجاعی میشود. برای غلبه بر مشکل «گلوگاه اطلاعاتی» (Information Bottleneck) در مدلهای RNN، مکانیزم توجه (Attention Mechanism) معرفی شد که به رمزگشا اجازه میدهد به تمام حالات پنهان رمزگذار دسترسی داشته باشد و بر بخشهای مرتبط متن منبع تمرکز کند. در معماریهای مبتنی بر ترنسفورمر، این کار از طریق توجه متقابل (Cross-Attention) انجام میشود.

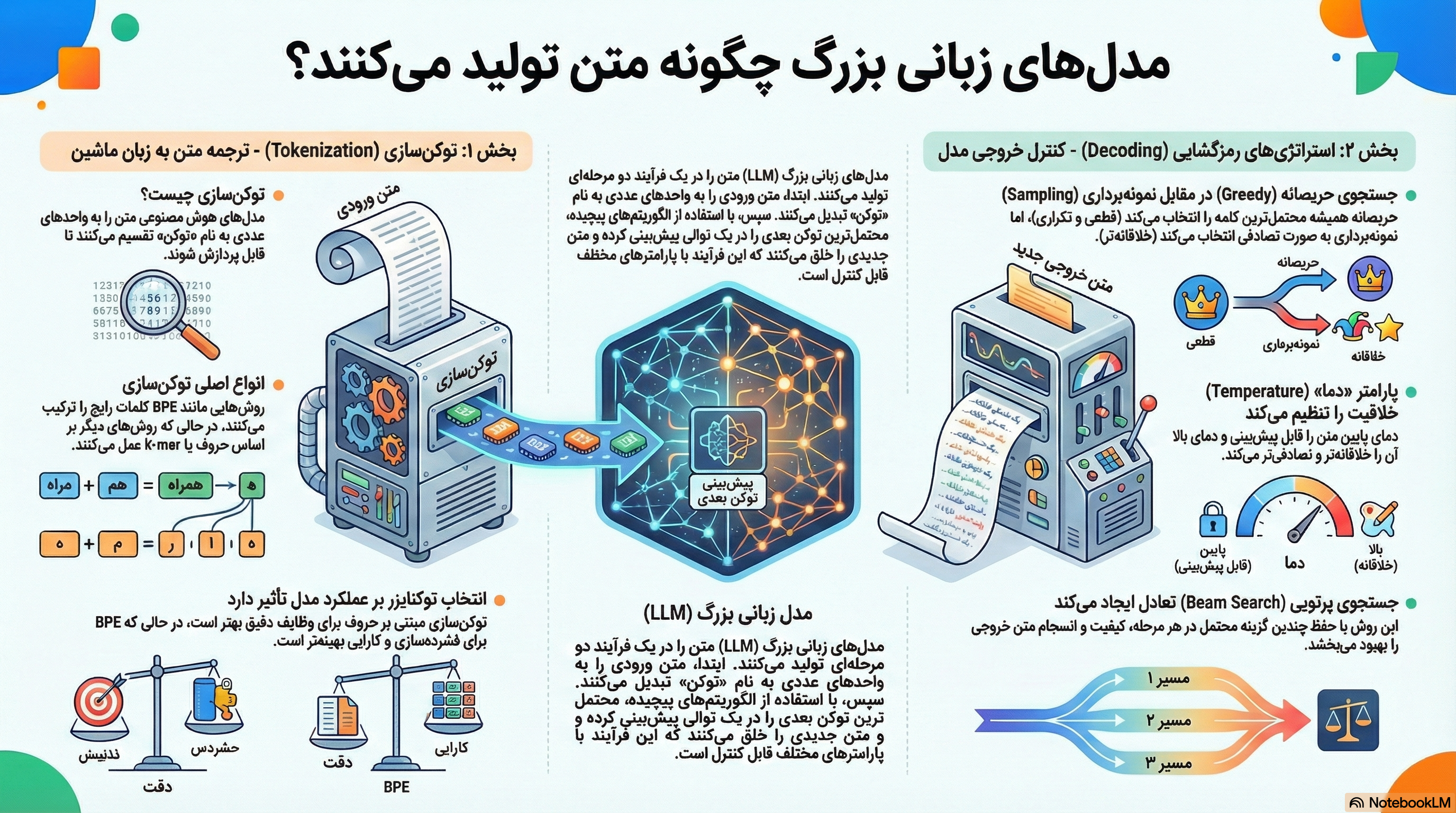

فرایند تولید متن نهایی توسط رمزگشا از طریق روشهای مختلفی انجام میشود که هر یک مزایا و معایب خود را دارند:

جستجوی حریصانه (Greedy Search): سادهترین روش که محتملترین کلمه را در هر مرحله انتخاب میکند اما اغلب به تکرار و راهحلهای غیربهینه منجر میشود.

جستجوی پرتوی (Beam Search): با حفظ k فرضیه محتمل در هر مرحله، کیفیت خروجی را بهبود میبخشد اما همچنان مستعد تکرار است و لزوماً بهینهترین خروجی را پیدا نمیکند.

نمونهبرداری (Sampling): با انتخاب تصادفی کلمه بعدی بر اساس توزیع احتمال، خلاقیت را افزایش میدهد. این روش با پارامترهایی مانند دما (Temperature) برای کنترل تصادفی بودن، Top-K (محدود کردن انتخاب به K کلمه محتمل) و Top-p (انتخاب از میان کوچکترین مجموعه کلمات با احتمال تجمعی p) کنترل میشود تا از تولید متن بیربط جلوگیری شود.

ارزیابی سیستمهای ترجمه ماشینی بر دو معیار اصلی استوار است: کفایت (Adequacy) یعنی حفظ معنای متن مبدأ، و روانی (Fluency) یعنی طبیعی بودن متن در زبان مقصد. ارزیابی انسانی دقیقترین روش است، اما معیارهای خودکار مانند chrF (مبتنی بر همپوشانی n-gram کاراکتری) و BERTSCORE (مبتنی بر شباهت تعبیهسازی) نیز برای ارزیابی سریع به کار میروند.

در نهایت، روندهای نوظهور بر تلفیق گراف دانش (Knowledge Graphs) با مدلهای زبانی بزرگ (LLMs) تمرکز دارند. این رویکرد با هدف غلبه بر محدودیتهای استنتاجی و توضیحپذیری LLMها، به ویژه در حوزههای تخصصی مانند علوم اسلامی-انسانی، یک چارچوب جدید برای تحلیل مفهومی و استنتاج منطقی ارائه میدهد که قادر به درک روابط پیچیده و ارائه خروجیهای هوشمندتر و قابل اعتمادتر است.

--------------------------------------------------------------------------------

ترجمه ماشینی (MT) به استفاده از رایانه برای ترجمه از یک زبان به زبان دیگر اطلاق میشود. همانطور که زورا نیل هرستون بیان میکند: «میخواهم به لهجه مردم تو صحبت کنم. صحبت کردن فایدهای ندارد مگر اینکه مردم بفهمند چه میگویی.» این نقل قول، جوهره اصلی ترجمه را به تصویر میکشد: انتقال معنا به شیوهای قابل فهم.

الگوریتم استاندارد برای ترجمه ماشینی، شبکه رمزگذار-رمزگشا (Encoder-Decoder) است که به آن شبکه دنباله-به-دنباله (Sequence-to-Sequence) نیز گفته میشود. این معماری میتواند با شبکههای عصبی بازگشتی (RNNs) یا ترنسفورمرها پیادهسازی شود. چالش اصلی در ترجمه، تفاوتهای ساختاری و واژگانی عمیق میان زبانهاست. برای مثال، ترتیب عناصر در جملات انگلیسی و ژاپنی کاملاً متفاوت است؛ فعل در انگلیسی در میانه جمله قرار میگیرد، در حالی که در ژاپنی در انتها میآید. این واگراییها نیازمند بازآراییهای ساختاری گسترده در حین فرایند ترجمه هستند.

برای ساخت مدلهای ترجمه ماشینی بهتر، درک تفاوتهای سیستماتیک میان زبانها ضروری است. حوزه گونهشناسی زبانی (Linguistic Typology) به مطالعه این شباهتها و تفاوتها میپردازد.

زبانها بر اساس ترتیب پایه فاعل (S)، فعل (V) و مفعول (O) در جملات اخباری ساده دستهبندی میشوند:

SVO (Subject-Verb-Object): زبانهایی مانند آلمانی، فرانسوی، انگلیسی و ماندارین که فعل بین فاعل و مفعول قرار میگیرد.

SOV (Subject-Object-Verb): زبانهایی مانند هندی و ژاپنی که فعل در انتهای جمله میآید.

VSO (Verb-Subject-Object): زبانهایی مانند ایرلندی و عربی که فعل در ابتدای جمله قرار میگیرد.

این تفاوتها بر ساختارهای دیگر نیز تأثیر میگذارند؛ برای مثال، زبانهای VO معمولاً دارای حروف اضافه (prepositions) هستند، در حالی که زبانهای OV دارای حروف اضافه پسین (postpositions) هستند.

تفاوتهای واژگانی چالشهای متعددی را ایجاد میکنند:

ابهام و تخصصیسازی: یک کلمه در زبان مبدأ ممکن است بسته به زمینه، ترجمههای متفاوتی در زبان مقصد داشته باشد. برای مثال، کلمه انگلیسی "wall" در آلمانی به دو کلمه مجزا ترجمه میشود: "Wand" (دیوار داخلی) و "Mauer" (دیوار خارجی).

شکاف واژگانی (Lexical Gap): گاهی یک زبان فاقد کلمهای است که بتواند معنای دقیق یک کلمه در زبان دیگر را منتقل کند. برای مثال، انگلیسی کلمه معادلی برای "xiào" در ماندارین (به معنای تقوای فرزندی) ندارد.

چارچوببندی رویدادها: زبانها در نحوه بیان حرکت و شیوه آن متفاوت هستند:

زبانهای چارچوب-فعل (Verb-framed): جهت حرکت روی فعل مشخص میشود (مانند اسپانیایی). مثال: La botella salió flotando (بطری شناورکنان خارج شد).

زبانهای چارچوب-وابسته (Satellite-framed): جهت حرکت روی ذره (satellite) مشخص میشود (مانند انگلیسی). مثال: The bottle floated out.

زبانها از نظر ساختار کلمات نیز متفاوت هستند:

زبانهای منفردساز (Isolating): هر کلمه معمولاً از یک تکواژ تشکیل شده است (مانند ویتنامی).

زبانهای چندترکیبی (Polysynthetic): یک کلمه میتواند شامل تکواژهای بسیار زیادی باشد و معادل یک جمله کامل در انگلیسی باشد (مانند سیبریایی یوپیک).

زبانهای التصاقی (Agglutinative): تکواژها مرزهای مشخصی دارند (مانند ترکی).

زبانهای ترکیبی (Fusion): یک وند ممکن است چندین مقوله صرفی را با هم ترکیب کند (مانند روسی).

زبانها در میزان حذف ضمایر متفاوت هستند:

زبانهای ضمیر-انداز (Pro-drop): زبانهایی مانند اسپانیایی، ژاپنی و چینی که میتوانند ضمایر را حذف کنند.

زبانهای سرد (Cold Languages): زبانهایی مانند چینی و ژاپنی که به شدت ضمیر-انداز هستند و از شنونده انتظار کار استنتاجی بیشتری برای بازیابی مرجعها دارند (کمتر صریح هستند).

زبانهای گرم (Hot Languages): زبانهایی مانند انگلیسی که صراحت بیشتری دارند و کار را برای شنونده آسانتر میکنند (بیشتر صریح هستند).

این معماری، الگوریتم استاندارد برای ترجمه ماشینی و بسیاری دیگر از وظایف پردازش زبان طبیعی است. این معماری از سه جزء اصلی تشکیل شده است:

رمزگذار (Encoder): یک دنباله ورودی (مثلاً یک جمله) را میپذیرد و دنبالهای از نمایشهای زمینهمند را تولید میکند.

بردار زمینه (Context Vector): یک بردار با طول ثابت که جوهره اطلاعات ورودی را به رمزگشا منتقل میکند.

رمزگشا (Decoder): بردار زمینه را به عنوان ورودی میپذیرد و یک دنباله خروجی با طول دلخواه تولید میکند.

در مدلهای اولیه رمزگذار-رمزگشا مبتنی بر RNN، بردار زمینه صرفاً آخرین حالت پنهان رمزگذار بود. این امر یک گلوگاه اطلاعاتی (bottleneck) ایجاد میکرد، زیرا یک بردار واحد باید تمام اطلاعات جمله مبدأ را، به خصوص برای جملات طولانی، در خود جای میداد.

مکانیزم توجه (Attention Mechanism) برای حل این مشکل ارائه شد. ایده اصلی توجه این است که به جای استفاده از یک بردار زمینه ثابت، یک بردار زمینه پویا برای هر مرحله از رمزگشایی ایجاد شود. این بردار زمینه پویا، میانگین وزنی تمام حالات پنهان رمزگذار است.

مرحله

شرح

فرمول (برای توجه نقطهای)

۱. محاسبه امتیاز (Score)

شباهت بین حالت پنهان قبلی رمزگشا (hd_i-1) و هر یک از حالات پنهان رمزگذار (he_j) محاسبه میشود.

score(hd_i-1, he_j) = hd_i-1 · he_j

۲. محاسبه وزنها (Weights)

امتیازها با استفاده از تابع سافتمکس نرمالسازی میشوند تا یک توزیع احتمال (α) ایجاد کنند که نشاندهنده میزان اهمیت هر حالت رمزگذار است.

α_ij = softmax(score(hd_i-1, he_j))

۳. محاسبه بردار زمینه (Context Vector)

بردار زمینه (ci) به عنوان میانگین وزنی تمام حالات پنهان رمزگذار محاسبه میشود.

ci = Σ_j α_ij * he_j

این بردار زمینه پویا (ci) سپس در کنار ورودی قبلی و حالت پنهان قبلی رمزگشا برای تولید کلمه بعدی استفاده میشود: hd_i = g(ŷ_i-1, hd_i-1, ci).

معماری رمزگذار-رمزگشا را میتوان با استفاده از بلوکهای ترنسفورمر نیز پیادهسازی کرد.

رمزگذار (Encoder): از بلوکهای ترنسفورمر استاندارد تشکیل شده است که در آن لایههای توجه به خود (self-attention) میتوانند به تمام کلمات در دنباله ورودی نگاه کنند.

رمزگشا (Decoder): از بلوکهای ترنسفورمر اصلاحشده استفاده میکند که علاوه بر لایه توجه به خود، دارای یک لایه توجه متقابل (Cross-Attention) است.

در لایه توجه متقابل:

Query (Q): از خروجی لایه قبلی رمزگشا میآید.

Key (K) و Value (V): از خروجی نهایی رمزگذار میآیند.

این ساختار به هر بلوک رمزگشا اجازه میدهد تا مستقیماً به تمام نمایشهای خروجی رمزگذار توجه کند و اطلاعات مرتبط را برای تولید کلمه بعدی استخراج نماید.

پس از اینکه مدل آموزش دید، برای تولید متن خروجی نهایی از یک الگوریتم رمزگشایی (Decoding) استفاده میشود. این الگوریتمها که ریشه در الگوریتمهای جستجو در هوش مصنوعی دارند، تعیین میکنند که چگونه از توزیع احتمال تولید شده توسط مدل، کلمه بعدی انتخاب شود.

این روش، سادهترین الگوریتم رمزگشایی است که در هر مرحله، کلمهای با بالاترین احتمال را انتخاب میکند (wt = argmax_w P(w | w1:t-1)).

مزایا: سریع و ساده است.

معایب:

مشکل تکرار: مدل به سرعت شروع به تکرار کلمات و عبارات میکند.

عدم بهینگی: با انتخاب بهترین گزینه محلی در هر مرحله، ممکن است توالی کلماتی با احتمال کلی بالاتر که پشت یک کلمه با احتمال کمتر پنهان شدهاند را از دست بدهد.

جستجوی پرتوی با حفظ k فرضیه (دنباله کلمات) محتمل در هر مرحله، مشکل بهینگی جستجوی حریصانه را کاهش میدهد. این عدد k به عنوان عرض پرتو (Beam Width) شناخته میشود.

فرایند: در هر مرحله، هر یک از k فرضیه موجود با تمام کلمات ممکن در واژگان گسترش مییابد. سپس از میان k × V (اندازه واژگان) فرضیه جدید، k فرضیه با بالاترین احتمال تجمعی برای مرحله بعد انتخاب میشوند.

مزایا: معمولاً توالیهایی با احتمال بالاتر از جستجوی حریصانه پیدا میکند و خروجی روانتری تولید میکند.

معایب:

تضمین بهینگی وجود ندارد: لزوماً محتملترین توالی کلی را پیدا نمیکند.

مشکل تکرار: همچنان به شدت از تولید تکراری رنج میبرد. برای مقابله با این مشکل، میتوان از جریمه n-gram (مانند no_repeat_ngram_size=2) استفاده کرد تا از تکرار دنبالههای کوتاه کلمات جلوگیری شود.

برخلاف روشهای قطعی (deterministic) بالا، در نمونهبرداری، کلمه بعدی به صورت تصادفی از توزیع احتمال مدل انتخاب میشود (wt ~ P(w | w1:t-1)). این روش به تولید متن خلاقانهتر و غیرمنتظرهتر کمک میکند، اما اگر کنترل نشود، میتواند به تولید متن بیربط و نامنسجم منجر شود. برای کنترل این فرایند از پارامترهای زیر استفاده میشود:

پارامتر دما توزیع احتمال سافتمکس را کنترل میکند.

دمای پایین (نزدیک به 0): توزیع را «تیزتر» میکند، احتمال کلمات محتمل را افزایش و احتمال کلمات کماحتمال را کاهش میدهد. در حد صفر، نمونهبرداری به جستجوی حریصانه تبدیل میشود. این دما برای وظایفی که به دقت و قطعیت نیاز دارند (مانند خلاصهسازی) مناسب است.

دمای بالا (بزرگتر از 1): توزیع را «مسطحتر» میکند و تفاوت بین کلمات محتمل و کماحتمال را کاهش میدهد. این امر به خلاقیت بیشتر منجر میشود اما خطر تولید اطلاعات نادرست ("توهم") را افزایش میدهد. این دما برای کارهای خلاقانه (مانند طوفان فکری) مناسب است.

در این روش، به جای در نظر گرفتن کل واژگان، مدل تنها از میان K کلمه با بالاترین احتمال، کلمه بعدی را نمونهبرداری میکند. این کار با حذف کلمات بسیار کماحتمال و عجیب، کیفیت متن را بهبود میبخشد.

مشکل: اندازه ثابت K نمیتواند خود را با توزیعهای احتمال متفاوت (تیز یا مسطح) تطبیق دهد.

این روش به صورت پویا اندازه مجموعه کلمات کاندید را تنظیم میکند. در Top-p، کلمات از کوچکترین مجموعه ممکن انتخاب میشوند که احتمال تجمعی آنها از آستانه p فراتر رود.

مزایا: این روش تطبیقپذیر است. برای توزیعهای تیز (جایی که مدل از کلمه بعدی مطمئن است)، مجموعه کلمات کاندید کوچک خواهد بود. برای توزیعهای مسطح (جایی که عدم قطعیت بالاست)، مجموعه بزرگتر خواهد بود و به مدل اجازه خلاقیت بیشتری میدهد. این روش اغلب به جستجوی Top-K ترجیح داده میشود.

توکنسازی: سیستمهای مدرن معمولاً از توکنسازی زیرکلمهای (subword) مانند BPE یا Wordpiece استفاده میکنند. این روش به مدل اجازه میدهد با کلمات نادر یا خارج از واژگان (OOV) برخورد کند.

پیکره متنی موازی (Parallel Corpus): مدلهای ترجمه بر روی مجموعهدادههایی به نام بایتکست (bitext) آموزش میبینند که شامل متونی در دو یا چند زبان است.

ترجمه معکوس (Backtranslation): روشی برای استفاده از دادههای تکزبانه در زبان مقصد است. در این روش، یک سیستم ترجمه اولیه (مقصد به مبدأ) آموزش داده میشود تا دادههای تکزبانه مقصد را به زبان مبدأ ترجمه کند و یک بایتکست مصنوعی ایجاد نماید.

نوع ارزیابی

معیارها

شرح

ارزیابی انسانی

کفایت (Adequacy): که به آن وفاداری (Fidelity) نیز گفته میشود، میزان حفظ معنای دقیق جمله مبدأ را میسنجد.<br>روانی (Fluency): میزان روان، گرامری و طبیعی بودن ترجمه در زبان مقصد را ارزیابی میکند.

دقیقترین روش ارزیابی است اما زمانبر و پرهزینه است. ارزیابان انسانی به ترجمهها امتیاز میدهند یا آنها را رتبهبندی میکنند.

ارزیابی خودکار

chrF: مبتنی بر F-score همپوشانی n-gramهای کاراکتری بین ترجمه ماشینی و یک ترجمه مرجع انسانی است.<br>BERTSCORE: از تعبیهسازیهای BERT برای اندازهگیری شباهت معنایی بین ترجمه ماشینی و مرجع استفاده میکند و به جای تطابق دقیق کلمات، به دنبال تطابق معنایی است.

سریع و ارزان هستند اما دقت کمتری نسبت به ارزیابی انسانی دارند. برای مقایسه تغییرات در یک سیستم واحد بسیار مفید هستند.

مدلهای زبانی بزرگ (LLMs) با وجود تواناییهای چشمگیر در تولید متن، در استدلال عمیق و توضیحپذیری با محدودیتهایی مواجه هستند. آنها ممکن است متنی به ظاهر منطقی تولید کنند اما فاقد عمق و ظرافت تخصصی باشند. برای غلبه بر این مشکل، رویکرد جدیدی مبتنی بر تلفیق LLMها با گراف دانش (Knowledge Graph) ارائه شده است.

گراف دانش ابزاری برای سازماندهی و نمایش اطلاعات ساختاریافته است که در آن مفاهیم به صورت گره (Node) و روابط بین آنها به صورت یال (Edge) مدلسازی میشوند. این ساختار به سیستمهای هوشمند اجازه میدهد:

روابط پیچیده بین مفاهیم را تجسم کنند.

ابهامزدایی از الفاظ مشترک را انجام دهند.

استدلالهای منطقی را تحلیل کرده و تناقضات را شناسایی کنند.

استدلالهای ناقص را تکمیل کنند.

یک پژوهش جدید الگویی برای توسعه LLMهای توضیحپذیر در حوزههای تخصصی مانند علوم اسلامی-انسانی با استفاده از گراف دانش ارائه کرده است. این الگو شامل پنج مرحله اصلی است:

تجمیع معنایی متون: جمعآوری و یکپارچهسازی دادهها از منابع مختلف (مانند ادله، کلام فقها و قرائن).

خوانش استدلالی: پیادهسازی منطق توصیفی و احتمالی برای تحلیل اولیه استنتاجها.

استدلال ماشینی: بازسازی اصول، ارزشگذاری پژوهشی، تحریر محل نزاع و کشف تناقضات.

بازیابی هوشمند اطلاعات و نمایش دانش: ارائه نتایج در قالبهای بصری مانند نمودار و نقشه.

این ترکیب به LLM اجازه میدهد تا اطلاعات دقیق و استوار را از گراف دانش استخراج کرده و در تولید متن خود بگنجاند، که منجر به خروجیهای هوشمندتر، آموزندهتر و قابل اعتمادتر میشود.

سیستمهای ترجمه ماشینی، مانند سایر مدلهای هوش مصنوعی، مستعد بازتولید و تقویت سوگیریهای موجود در دادههای آموزشی هستند. یک نمونه بارز، سوگیری جنسیتی است. برای مثال، هنگام ترجمه از زبانهای بدون جنسیت دستوری (مانند مجارستانی با ضمیر "ő") به انگلیسی، مدلها اغلب بر اساس کلیشههای شغلی، جنسیت را تعیین میکنند.

ő egy ápoló (او یک پرستار است) به she is a nurse ترجمه میشود.

ő egy vezérigazgató (او یک مدیرعامل است) به he is a CEO ترجمه میشود. این سوگیریها میتوانند نابرابریهای اجتماعی را تداوم بخشیده و تقویت کنند، که نیازمند توجه جدی در طراحی و ارزیابی این سیستمها است.